Ce este Traficul Bot? Cum să opriți roboții de trafic care provoacă ravagii

Publicat: 2021-02-08Traficul de boți este orice trafic de internet care provine de la roboți automati. Acești roboți pot îndeplini sarcini mai rapid decât orice om, făcându-i foarte eficienți și populari.

Având atât de mult înțeles greșit despre traficul de bot, ne uităm la diferiții roboți implicați și la ce înseamnă aceasta pentru site-ul dvs. web.

Într-o lume în care miliarde de utilizatori interacționează între ei online în fiecare zi, internetul poate părea un loc agitat. Având în vedere că utilizatorii le plac imaginile, retweetează mesaje și votează în favoarea comentariilor, volumul zilnic de trafic web pe internet este la un nivel maxim.

Dar câți dintre acești vizitatori sunt de fapt reali?

Cu tot mai mulți roboți lansați pe internet în fiecare zi, este acesta un lucru bun pentru proprietarii și utilizatorii de site-uri web sau doar o altă supărare?

Pentru a înțelege pe deplin ce este traficul de bot, trebuie mai întâi să explorăm diferitele tipuri de roboți automatizați și ce fac aceștia.

Ce este Traficul Bot?

Traficul bot poate fi definit ca orice trafic de internet online care nu este generat de un om . Acest lucru înseamnă, de obicei, că traficul provine dintr-un fel de script automat sau program de calculator care este creat pentru a economisi utilizatorului timpul de a face toate sarcinile manual. Deși acești roboți încearcă să imite comportamentul uman, cu siguranță nu sunt oameni.

Acești roboți automatizați pot face lucruri simple, cum ar fi clic pe linkuri și descărcarea de imagini sau lucrări complicate, cum ar fi răzuirea sau completarea formularelor. Orice sunt făcuți să facă, de obicei o fac la scară largă și rulează aproape non-stop. Dacă ați postat vreodată o imagine pe rețelele de socializare precum Instagram sau Facebook și ați primit sute de aprecieri în câteva secunde, atunci cel mai probabil sunt roboți.

Cu peste 50% din internet estimat a fi trafic de bot, este clar că roboții pot fi găsiți aproape peste tot și pe aproape fiecare site web.

Pentru a vă face o idee despre diferitele tipuri de boți de acolo, iată o detaliere rapidă a boților buni și a ceea ce fac aceștia, precum și a boților răi.

Traficul bunului bot

Deși traficul automatizat de boți obține o reputație destul de negativă de la webmasteri, există de fapt o serie de roboți legitimi care încearcă doar să ajute.

Boți pentru motoarele de căutare

Primul și cel mai evident tip de trafic de boți bun trebuie să fie roboții pentru motoarele de căutare. Acești roboți de internet se accesează cu crawlere cât pot de mult pe web și îi ajută pe proprietarii de site-uri web să-și afișeze site-urile în motoarele de căutare, cum ar fi căutarea Google, Yahoo și Bing. Solicitările lor ar putea fi automatizate și listate ca trafic de bot, dar acești roboți sunt cu siguranță boți buni.

Boti de monitorizare

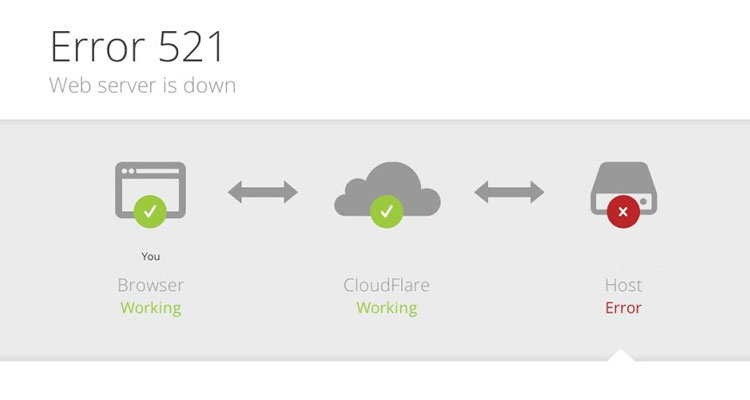

Dacă dețineți un site web, asigurați-vă că site-ul dvs. este sănătos și întotdeauna online este adesea o prioritate pentru mulți proprietari. Pentru a ajuta utilizatorii să se asigure că site-ul lor este întotdeauna accesibil, există o serie de roboți de monitorizare a site-ului care vor trimite automat site-ul dvs. pentru a se asigura că este încă online. Dacă ceva se strica vreodată sau site-ul dvs. se deconecta, atunci veți fi imediat notificat și veți putea face ceva în privința asta.

Crawler-uri SEO

Încercarea de a-ți aduce site-ul pe primul loc în motoarele de căutare poate fi extrem de dificilă, mai ales când nu ai multe informații. Din fericire, există o gamă largă de software care vă pot ajuta să vă îmbunătățiți eforturile de SEO prin accesarea cu crawlere a site-ului și a concurenților pentru a vedea pentru ce vă clasați și cât de bine. Webmasterii pot folosi aceste date pentru a-și îmbunătăți vizibilitatea căutării și pentru a-și îmbunătăți traficul web organic.

Boti de drepturi de autor

A se asigura că nimeni nu ți-a furat imaginile și le-a folosit ca pe ale lor poate fi o sarcină dificilă. Având atâtea site-uri web de verificat continuu, singura soluție sensibilă este ca un bot automat să o facă. Acești roboți web accesează cu crawlere scanarea web pentru anumite imagini pentru a se asigura că nimeni nu utilizează ilegal conținut protejat de drepturi de autor fără permisiune.

Traficul cu botul rău

Spre deosebire de boții buni pe care tocmai i-am menționat mai sus, boții răi fac lucruri foarte rele site-ului dvs. și pot provoca multe daune dacă sunt lăsați să ruleze liber. Acesta poate fi orice tip de atac bot de la trimiterea de trafic fals și trafic de spam sau ceva mult mai perturbator, cum ar fi frauda publicitară.

Web Scrapers

Web scrapers sunt roboți de internet enervanti care răzuiesc site-uri web în căutarea unor informații valoroase, cum ar fi adresa de e-mail și detaliile de contact. În alte cazuri, vor fura conținut și imagini de pe site-uri web și le vor folosi pe propriul lor site sau pe conturile de rețele sociale fără permisiune. Nu beneficiază nimănui în afară de persoana care îl folosește pentru a răzui date.

Spam Bots

Dacă ați primit vreodată un e-mail bizar sau un comentariu pe blog de la cineva, atunci sunt șanse ca un robot spam să-l lase. Acești roboți adoră să lase mesaje generate (care adesea nu au sens) pe blogul unui site web. De asemenea, completează formulare de contact pe site-uri web și proprietarii de spam cu mesaje promoționale.

Rețele DDoS

Unul dintre cei mai vechi și mai mortali boți răi de acolo trebuie să fie botul DDoS. Cunoscuți sub numele de roboți distribuiți de refuz al serviciului, acești roboți sunt adesea instalați pe PC-urile victimelor nebănuite și sunt utilizați pentru a viza un anumit site web sau server, cu scopul de a le scoate din online.

Cunoscut ca un atac DDoS, au existat o mulțime de rapoarte în trecut conform cărora aceștia au făcut unele daune financiare grave site-urilor care au ajuns să fie offline timp de câteva zile.

Scanere de vulnerabilitate

Acești roboți ar putea părea boți buni din jurnalele de server ale unui site web, dar, din păcate, nu este cazul. Există o serie de roboți rău intenționați care vor scana milioane de site-uri pentru vulnerabilități și le vor raporta creatorului lor. Spre deosebire de boții autentici care ar informa proprietarul site-ului web, acești roboți rău intenționați sunt special conceputi pentru a raporta unei singure persoane care, cel mai probabil, va vinde informațiile sau le va folosi ei înșiși pentru a pirata site-uri web.

Faceți clic pe Fraud Bots

Necunoscut pentru mulți, există o mulțime de roboți sofisticați care produc o cantitate uriașă de trafic de roboți rău intenționat care vizează în mod special anunțurile plătite. Spre deosebire de roboții care produc trafic nedorit pe site, acești roboți se angajează în ceva cunoscut sub numele de fraudă publicitară.

Responsabil pentru clicurile frauduloase pe reclamele plătite, acest trafic non-uman costă agenții de publicitate miliarde în fiecare an și este adesea deghizat în trafic legitim. Fără un software bun de detectare a botului, această activitate bot poate costa agenții de publicitate o mare parte din bugetul lor publicitar.

Cum pot fi boții de trafic rău pentru site-uri web?

Acum știți despre diferitele tipuri de roboți buni și rău intenționați, cum poate traficul cu bot să fie rău pentru site-ul dvs.?

Lucrul important de înțeles despre roboți este că majoritatea scripturilor și programelor sunt concepute pentru a face o singură lucrare de mai multe ori. Creatorul botului dorește, evident, ca treaba să fie făcută cât mai repede posibil, dar acest lucru poate aduce multe probleme pentru site-ul dvs.

Cea mai mare problemă este că, dacă un robot solicită în mod continuu informații de pe site-ul dvs., atunci acest lucru poate duce la o încetinire generală. Aceasta înseamnă că site-ul va fi lent pentru toți cei care îl accesează, ceea ce poate cauza probleme masive dacă, de exemplu, ești un magazin online.

Solicitările consecvente de scraping ar putea duce, de asemenea, la denaturarea KPI-urilor importante și a datelor Google Analytics, cum ar fi rata de respingere.

În cazuri extreme, prea mult trafic de bot poate duce de fapt întregul site web offline, ceea ce, evident, nu este bine. Dar, din fericire, acest lucru se întâmplă doar în circumstanțe extreme, de cele mai multe ori, efectele traficului bot pe site-ul dvs. sunt foarte subtile.

A avea o mulțime de trafic bot pe site-ul dvs. web va duce de obicei la lucruri precum:

- Mai multe vizualizări de pagină

- Utilizare mai mare a lățimii de bandă

- Google Analytics incorect

- Calitatea distorsionată a datelor de marketing

- Scăderea conversiilor

- E-mailuri nedorite

- Timpi de încărcare mai lungi

- Costuri mai mari ale serverului

- Rata de respingere crescută

- Tensiune crescută asupra centrelor de date

Cum să detectați traficul botului

Dacă doriți să verificați dacă site-ul dvs. web este afectat de traficul bot, atunci cel mai bun loc pentru a începe este Google Analytics.

În Google Analytics, veți putea vedea toate valorile esențiale ale site-ului, cum ar fi timpul mediu pe pagină, rata de respingere, numărul de vizualizări ale paginii și alte date de analiză. Folosind aceste informații, puteți determina rapid dacă datele de analiză ale site-ului dvs. au fost denaturate de traficul bot și în ce măsură.

Deoarece nu puteți vedea adrese IP ale utilizatorilor în Google Analytics, va trebui să examinați aceste valori pentru a vedea dacă au sens. O valoare foarte mică pe site este un indicator clar că majoritatea vizitatorilor dvs. ar putea fi roboți. Un bot de internet durează doar câteva secunde pentru a accesa cu crawlere o pagină web înainte ca aceasta să părăsească și să treacă la următoarea țintă.

Un alt loc de verificat în Google Analytics este secțiunea de recomandări pentru a verifica dacă nu primiți niciun spam de recomandare. Multe companii vizează alte site-uri cu un bot personalizat care va spama adresa URL a site-ului lor.

Când un webmaster își verifică traficul de recomandare în Google Analytics, va vedea numele site-ului web și va fi înclinat să îl viziteze. Oricât de grosolan sună, poate ajuta site-ul să genereze o mulțime de vizitatori (în principal din curiozitate!). S-ar putea să nu sune ca și cum ar face rău site-ului dvs., dar de fapt vă modifică toate valorile, vă irosesc lățimea de bandă și vă blochează serverul în general.

Cum să opriți traficul cu bot

Filtrarea traficului prost de boți și oprirea roboților automatizați să vă afecteze site-ul este complet posibilă, dar soluția va depinde de tipul de sursă de trafic care vă afectează site-ul. Amintiți-vă, nu tot traficul de bot este rău, iar blocarea roboților, cum ar fi crawlerele motoarelor de căutare, nu este chiar o idee bună!

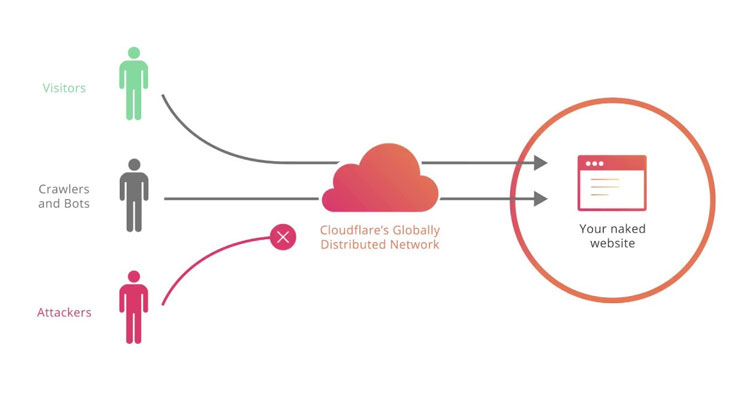

Dacă site-ul dvs. web este predispus să fie răzuit de roboți, scanere de vulnerabilități și roboți de trafic automatizați, atunci sunt șanse să doriți o filtrare de bot sub forma unui firewall sau CAPTCHA. Cel mai bun mod de a face acest lucru este să instalați un serviciu gratuit de filtru bot pe site-ul dvs. numit CloudFlare.

Pe lângă faptul că este o rețea de livrare de conținut (CDN), CloudFlare acționează ca un firewall de aplicație între site și utilizator, ceea ce înseamnă că va permite doar utilizatorilor legitimi să acceseze site-ul dvs. Orice utilizator suspect nu va trece și nu va putea accesa site-ul dvs. Aceasta înseamnă că nu vă vor irosi lățimea de bandă, nu vă vor ruina analizele sau nu vă vor fura conținutul.

O altă modalitate utilă de a bloca roboții este să utilizați fișierul roboți txt al site-ului dvs., completându-l cu agenți de utilizator sau cu numele real al roboților cunoscuți. Puteți afla mai multe despre blocarea roboților în fișierul robots txt în acest ghid la îndemână. Desigur, acest lucru funcționează numai dacă robotul respectă fișierul robots.txt, ceea ce fac majoritatea roboților autentici. Dacă încercați să scăpați de un bot rău deranjant, atunci folosirea opțiunii CloudFlare menționată mai sus este cea mai bună.

Cu toate acestea, dacă doriți să vă protejați site-ul de alte forme de roboți, cum ar fi clicurile frauduloase și repetitive pe anunțurile dvs., atunci veți avea nevoie de altceva.

Protejați-vă reclamele de traficul prost de bot

Oricine rulează anunțuri cu plată pe clic pe Google este supus traficului bot. Având în vedere atât de mulți crawler-uri care elimină în mod constant Google și rezultatele sale, este doar o chestiune de timp până când acești roboți dau clic pe anunțurile dvs. și vă distrug datele de analiză și bugetul.

PPC Protect este un instrument automat de detectare a fraudei publicitare care va identifica orice fraudă prin clic pe anunțurile dvs. cu plata pe clic în timp real.

Prin colectarea multor date de la fiecare clic, software-ul va putea detecta când o adresă IP este suspectă și va împiedica acel utilizator să vă vadă anunțurile în viitor.

Acest lucru ajută la combaterea traficului bot de la instrumentele SEO care accesează cu crawlere Google și alte motoare de căutare care caută anunțuri PPC. Cu o mulțime de aceste instrumente disponibile, ați fi surprins de câte ori accesează cu crawlere rezultatele căutării căutând anunțuri și alte informații.

Pentru a vă proteja anunțurile de traficul bot nedorit și scrapers, faceți clic mai jos pentru a vă înscrie pentru o probă gratuită de 14 zile a serviciului nostru.