Wikipedia Web Scraping 2023: Extragerea datelor pentru analiză

Publicat: 2023-03-29Scrapingul online vă permite să colectați date deschise de pe site-uri web în scopuri precum compararea prețurilor, cercetarea de piață, verificarea anunțurilor etc.

În mod obișnuit, sunt extrase cantități mari de date publice necesare, dar atunci când luptați împotriva blocajelor, extragerea poate deveni dificilă.

Restricția poate fi fie blocarea ratei, fie blocarea IP (adresa IP a cererii este restricționată deoarece provine dintr-o zonă interzisă, tip interzis de IP etc.). (adresa IP este blocată deoarece a făcut mai multe solicitări).

Acum, dacă sunteți pregătit să scoateți câteva cunoștințe și informații utile, atunci sunt sigur că probabil că v-ați gândit să eliminați Wikipedia, enciclopedia cunoașterii care găzduiește tone de informații.

Să înțelegem câteva lucruri despre Wikipedia web scraping.

Cuprins

Wikipedia Web Scraping

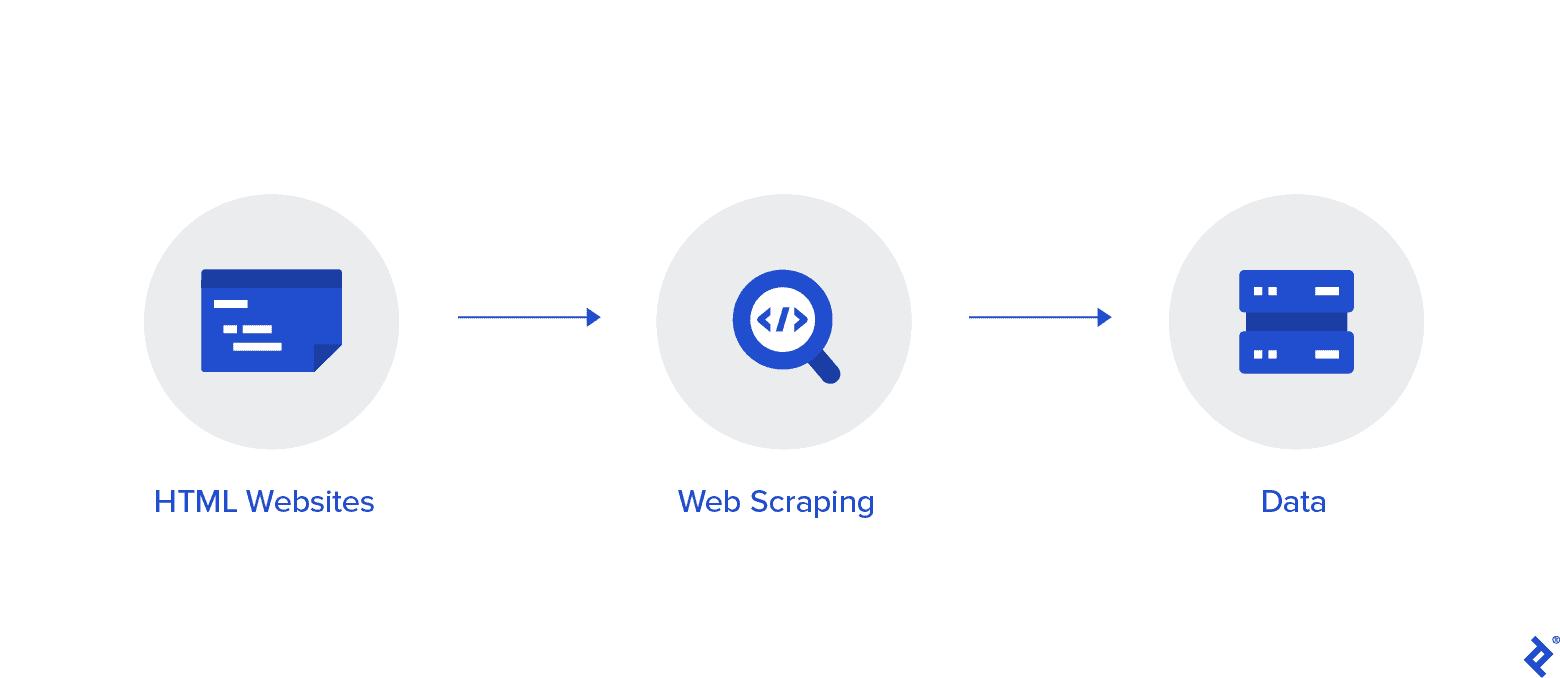

Web scraping este o metodă automată de colectare a datelor de pe internet. Informații aprofundate despre web scraping, o comparație cu crawlingul web și argumente în favoarea web scraping sunt furnizate în acest articol.

Obiectivul este de a aduna date de pe pagina de pornire Wikipedia folosind diverse metode de scraping web, apoi le analizam.

Veți deveni mai familiarizați cu diferite metode de scraping web, biblioteci de web scraping Python și proceduri de extracție și procesare a datelor.

Web Scraping și Python

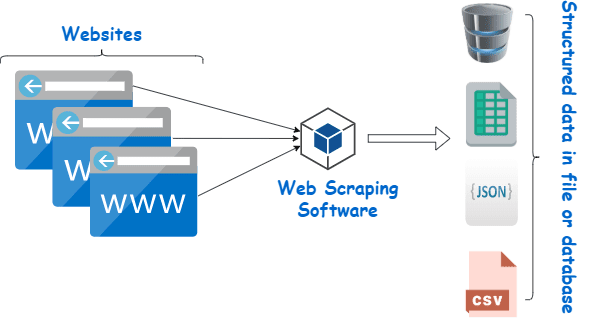

Web scraping este, în esență, procesul de extragere a datelor structurate dintr-o cantitate mare de date dintr-un număr mare de site-uri web, folosind un software care este creat într-un limbaj de programare și salvarea locală a acestuia pe dispozitivele noastre, de preferință în foi Excel, JSON sau foi de calcul.

Acest lucru îi ajută pe programatori să creeze cod logic și ușor de înțeles atât pentru proiectele mici, cât și pentru cele mari.

Python este considerat în primul rând cel mai bun limbaj pentru web scraping. Poate gestiona în mod eficient majoritatea sarcinilor legate de accesarea cu crawlere a web-ului și este mai mult o soluție universală.

Cum să răzuiți datele de pe Wikipedia?

Datele pot fi extrase din pagini web într-o varietate de moduri.

De exemplu, îl puteți implementa singur folosind limbaje informatice precum Python. Dar, cu excepția cazului în care sunteți pasionați de tehnologie, va trebui să studiați mult înainte de a putea face multe cu acest proces.

Este, de asemenea, consumator de timp și poate dura atât timp cât trecerea manuală a paginilor Wikipedia. În plus, web scrapers gratuite sunt accesibile online. Cu toate acestea, adesea le lipsește fiabilitatea, iar furnizorii lor pot avea intenții dubioase.

Investiția într-un web scraper decent de la un furnizor de renume este cea mai bună metodă de a colecta date Wiki.

Următorul pas este de obicei simplu și necomplicat, deoarece furnizorul vă va oferi instrucțiuni despre cum să instalați și să utilizați racleta.

Un proxy este un instrument pe care îl puteți utiliza împreună cu wiki scraper pentru a răzui mai eficient datele. Cadrele bazate pe Python, cum ar fi Scrapy, Scraping Robot și Beautiful Soup sunt doar câteva exemple despre cât de ușor este să răzuiești folosind acest limbaj.

Proxy pentru Scrape date din Wikipedia

Aveți nevoie de proxy-uri extrem de rapide, sigure de utilizat și garantate că nu vă vor afecta atunci când aveți nevoie de ele pentru a răzui datele în mod eficient. Astfel de proxy-uri sunt disponibile de la Rayobyte la prețuri rezonabile.

Facem eforturi pentru a oferi o varietate de proxy, deoarece suntem conștienți de faptul că fiecare utilizator are preferințe și cazuri de utilizare diferite.

Rotirea proxy-urilor pentru web scraping Wikipedia

O instanță a unui proxy este una care își rotește adresa IP în mod regulat. De asemenea, pentru a preveni întreruperile, adresa IP este imediat schimbată atunci când apare un ban. Acest lucru face ca acest proxy special să fie o alegere excelentă pentru scraping site-ului.

Proxy-urile statice, în comparație, au o singură adresă IP. Dacă ISP-ul dvs. nu permite înlocuirea automată, vă veți întâlni cu un zid de cărămidă dacă aveți acces doar la o singură adresă IP și aceasta este blocată. Din acest motiv, proxy-urile statice nu sunt cea mai bună opțiune pentru web scraping.

Proxy-uri rezidențiale pentru datele Wiki scraping web

Proxy-urile rezidențiale sunt adrese IP proxy pe care furnizorii de servicii de internet (ISP) le distribuie și sunt asociate cu anumite gospodării. Pentru că provin de la oameni reali, obținerea lor este destul de dificilă. Drept urmare, sunt rare și relativ scumpe.

Când utilizați proxy-uri rezidențiale pentru a răzui date, parți să fiți un utilizator obișnuit, deoarece acestea sunt legate de adresele unor persoane reale.

Prin urmare, utilizarea proxy-urilor rezidențiale reduce semnificativ șansele de a fi descoperit și blocat. Prin urmare, sunt candidați excelenți pentru data scraping.

Rotația proxy rezidențială pentru colectarea datelor wiki

Un proxy rezidențial rotativ, care combină cele două tipuri despre care tocmai am vorbit, este cel mai bun proxy pentru web scraping Wikipedia.

Puteți accesa un număr mare de IP-uri de acasă folosind un proxy care le rotește frecvent.

Acest lucru este esențial deoarece, în ciuda dificultății în identificarea proxy-urilor rezidențiale, volumul de solicitări pe care le generează va atrage în cele din urmă atenția site-ului web care este răzuit.

Rotirea asigură că proiectul poate continua chiar dacă adresa IP devine inevitabil pe lista neagră.

Prin urmare, avem ceea ce aveți nevoie, fie că decideți să utilizați mai multe proxy pentru centre de date, fie că preferați să investiți în câțiva proxy rezidențiali.

Vă veți bucura de cea mai bună experiență de scraping web cu proxy care rulează la viteză de 1 GBS, lățime de bandă nelimitată și asistență pentru clienți non-stop.

De asemenea, puteți citi

- Cele mai bune tehnici de răzuire web: un ghid practic

- Octoparse Review Este cu adevărat un instrument de răzuire pe web?

- Cele mai bune instrumente de răzuire web

- Ce este Web Scraping? - Cum se utilizează? Cum poate aduce beneficii afacerii dvs

De ce ar trebui să răzuiești Wikipedia?

Wikipedia este unul dintre cele mai de încredere și bogate în informații servicii din lumea online în acest moment. Există răspunsuri și informații la aproape toate tipurile de subiecte la care vă puteți gândi pe această platformă.

Așadar, în mod firesc, Wikipedia este o sursă excelentă din care să extrageți date. Să discutăm principalele motive pentru care ar trebui să răzuiești Wikipedia.

Web scraping pentru cercetare academică

Colectarea datelor este una dintre cele mai dureroase activități implicate în cercetare. După cum s-a discutat deja, răzuitoarele pentru web fac această procedură mai rapidă și mai ușoară, economisind totodată o tonă de timp și energie.

Cu un web scraper, puteți scana rapid numeroase pagini wiki și puteți colecta toate datele de care aveți nevoie într-un mod organizat.

Presupuneți pentru o clipă că scopul dvs. este să determinați dacă depresia și expunerea la lumina soarelui variază în funcție de țară.

Puteți folosi un răzuitor Wiki pentru a localiza informații precum prevalența depresiei în diferite națiuni și orele însorite ale acestora, în loc să parcurgeți numeroase intrări Wikipedia.

Managementul reputației

Realizarea unei pagini Wikipedia a devenit o strategie de marketing obligatorie pentru multe tipuri diferite de afaceri în epoca modernă, deoarece postările Wikipedia apar frecvent pe prima pagină a Google.

Dar, a avea o pagină pe Wikipedia nu ar trebui să fie sfârșitul eforturilor tale de marketing. Wikipedia este o platformă aglomerată, așa că vandalismul este ceva care se întâmplă destul de frecvent.

Drept urmare, cineva ar putea adăuga informații nefavorabile pe pagina companiei tale și ar putea dăuna reputației tale. Ca alternativă, îți pot defăima afacerea într-un articol wiki relevant.

Din acest motiv, trebuie să fii cu ochii pe pagina ta Wiki, precum și pe alte pagini care menționează afacerea ta odată ce aceasta a fost realizată. Puteți face acest lucru cu ușurință cu ajutorul unui răzuitor wiki.

Puteți căuta periodic în paginile Wikipedia referințe la afacerea dvs. și puteți sublinia eventualele cazuri de vandalism acolo.

Îmbunătățiți SEO

Puteți utiliza Wikipedia pentru a crește traficul către site-ul dvs. web.

Creați o listă de articole pe care ați dori să le modificați folosind un răzuitor de date Wiki pentru a localiza paginile care sunt relevante pentru afacerea dvs. și pentru publicul dvs. țintă.

Începeți prin a citi articolele și a face câteva ajustări utile pentru a câștiga credibilitate ca colaborator al site-ului.

Odată ce v-ați stabilit o anumită credibilitate, puteți adăuga conexiuni la site-ul dvs. în locurile unde există link-uri întrerupte sau unde sunt necesare citări.

Legături rapide

- Cele mai bune proxy franceze

- Cel mai bun proxy Spotify

- Cele mai bune proxy Nike

Biblioteci Python utilizate pentru web scraping

Python este cel mai popular și mai reputat limbaj de programare și instrument de web scraping din lume, așa cum sa spus deja. Acum să ne uităm la bibliotecile de scraping web Python care sunt disponibile chiar acum.

Bibliotecă de solicitări (HTTP pentru oameni) pentru Web Scraping

Este folosit pentru a trimite diferite solicitări HTTP, cum ar fi GET și POST. Dintre toate bibliotecile, este cea mai fundamentală, dar și cea mai importantă.

Bibliotecă lxml pentru Web Scraping

Parsarea foarte rapidă și de înaltă performanță a textului HTML și XML de pe site-uri web este oferită de pachetul lxml. Acesta este cel pe care trebuie să-l alegeți dacă intenționați să răzuiți baze de date uriașe.

Frumoasă bibliotecă de supă pentru web scraping

Lucrarea sa este construirea unui arbore de analiză pentru analizarea conținutului. Un loc grozav de început pentru începători și foarte ușor de utilizat.

Biblioteca Selenium pentru Web Scraping

Această bibliotecă rezolvă problema pe care o au toate bibliotecile menționate mai sus, și anume răzuirea conținutului din paginile web populate dinamic.

A fost conceput inițial pentru testarea automată a aplicațiilor web. Din acest motiv, este mai lent și nepotrivit pentru sarcini la nivel industrial.

Scrapy pentru Web Scraping

Un cadru complet de web scraping care utilizează utilizarea asincronă este BOSS-ul tuturor pachetelor. Acest lucru sporește eficiența și îl face extraordinar de rapid.

Concluzie

Deci acesta a fost cel mai important aspect pe care trebuie să-l știți despre Wikipedia Web Scraping. Rămâneți la curent cu noi pentru mai multe astfel de postări informative despre Web Scraping și multe altele!

Legături rapide

- Cele mai bune proxy pentru agregarea tarifelor de călătorie

- Cele mai bune proxy franceze

- Cele mai bune proxy Tripadvisor

- Cele mai bune proxy Etsy

- Cod cupon IPRoyal

- Cele mai bune proxy TikTok