Этика ИИ: как маркетологи должны ответственно относиться к инновациям

Опубликовано: 2023-08-21Искусственный интеллект (ИИ) — это не просто научно-фантастический феномен, ставший реальностью, это технологическая опора, развивавшаяся десятилетиями прямо у нас под носом. ИИ реализовал мечты о повышении эффективности, и многие бренды уже используют маркетинг ИИ за последние несколько лет.

Хотя это вызвало волнение и энтузиазм, существуют опасения, связанные с этикой ИИ. Как и многие инновации, видение метавселенной технологической индустрии имело жутковатое сходство с такими СМИ, как Black Mirror и Snow Crash . А учитывая такие произведения, как «Притча о сеятеле, машине и я, роботе», вписывающиеся в культурный дух времени, становится понятно, почему любители научной фантастики, исследователи и технологи одинаково предупреждают об опасности игнорирования этики ИИ.

В этой статье мы определим, что такое этика искусственного интеллекта, почему брендам следует беспокоиться, а также основные этические проблемы, с которыми сталкиваются маркетологи, включая безопасность рабочих мест, дезинформацию и алгоритмическую предвзятость. Мы также поделимся пятью шагами, которые помогут вам поддерживать этичные методы ИИ в командах и во всей организации.

Что такое этика ИИ?

Этика ИИ — это система моральных принципов и профессиональных практик, используемых для ответственного информирования о разработке и результатах технологий искусственного интеллекта. Это также относится к изучению того, как оптимизировать воздействие и снизить риски и/или последствия ИИ.

Ведущие технологические компании, государственные учреждения, такие как Организация Объединенных Наций, а также исследовательские сообщества и сообщества специалистов по обработке данных работали над формированием и публикацией руководящих принципов по решению этических проблем. Например, Организация Объединенных Наций по вопросам образования, науки и культуры (ЮНЕСКО) в ноябре 2021 года опубликовала первый глобальный стандарт этики искусственного интеллекта: Рекомендацию по этике искусственного интеллекта.

На уровне страны и на местном уровне действуют некоторые правила в области ИИ, но по мере роста ИИ и других новых технологий предприятиям следует ожидать большего государственного регулирования. По мере того, как ИИ все больше интегрируется в нашу жизнь, этика ИИ становится важной частью цифровой грамотности.

Почему этика ИИ важна

Компании уже инвестируют в ИИ, но трудность заключается в обеспечении ответственного использования.

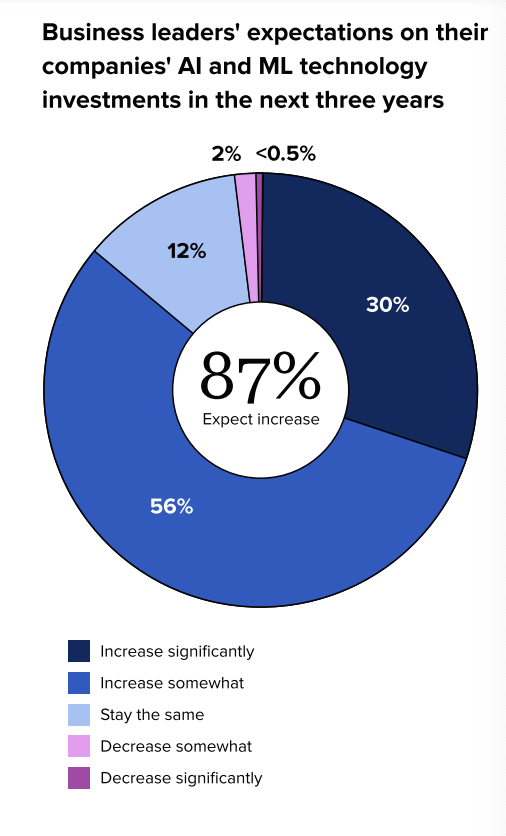

Согласно отчету «Состояние социальных сетей в 2023 году: искусственный интеллект и сбор данных в центре внимания», лидеры бизнеса ожидают увеличения инвестиций в искусственный интеллект в течение следующих нескольких лет. Наш отчет также показал, что 98% бизнес-лидеров согласны с тем, что компаниям необходимо лучше понимать потенциал технологий искусственного интеллекта и машинного обучения (ML) для достижения долгосрочного успеха.

Хотя ИИ может улучшить производительность, эффективность и добиться положительных результатов в бизнесе, бренды также сталкиваются с непредвиденными последствиями его применения. Среди прочих причин это может быть связано с отсутствием исследований или необъективными наборами данных. Неправильное использование ИИ или игнорирование этических соображений может привести к подрыву репутации бренда, сбоям в работе продукта, судебным разбирательствам и проблемам с регулированием.

Первый шаг к соблюдению этических стандартов во всех командах вашей организации начинается с понимания проблем, с которыми сталкиваются маркетологи, чтобы вы могли разработать план по снижению этих бизнес-рисков и защите своего бренда.

Какие вопросы этики ИИ волнуют маркетологов

В технологической отрасли существует множество этических проблем, связанных с ИИ, включая, помимо прочего, следующие:

- Генерация ложного контента

- Объясняемость

- Социальное воздействие

- Неправильное использование технологий

- Предвзятость

- Ответственность за данные и конфиденциальность

- Справедливость

- Надежность

- Прозрачность

- Экологическая устойчивость

- Разнообразие и инклюзивность

- Моральная свобода действий и ценностное выравнивание

- Доверие и ответственность

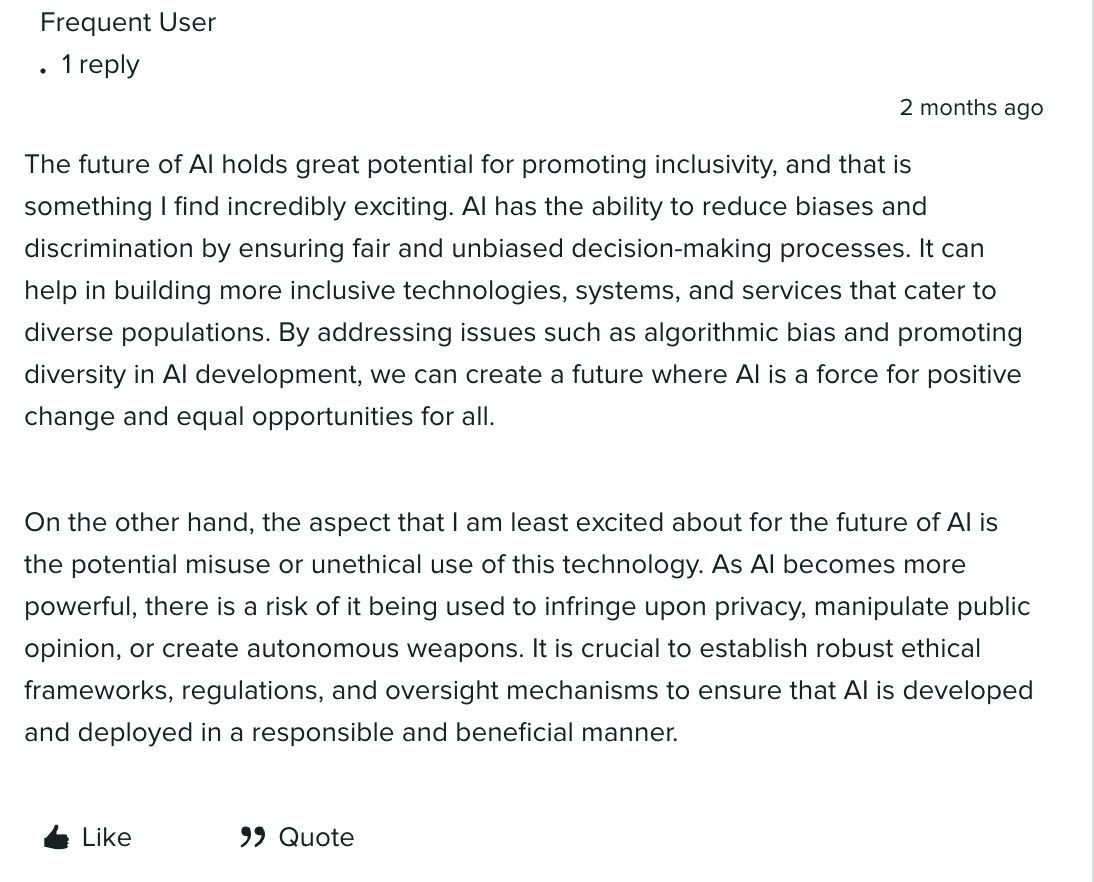

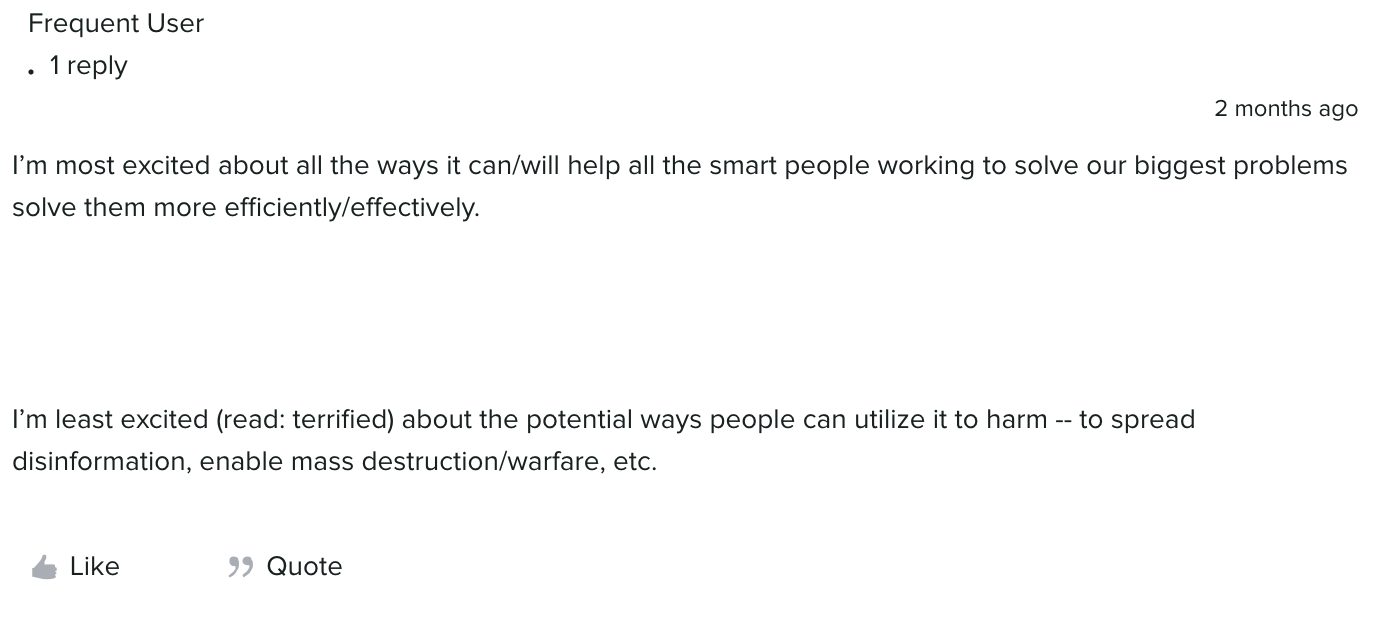

Некоторые считают, что ИИ может помочь в создании более инклюзивных технологий, систем и услуг, которые могут обслуживать различные группы населения. Ключевым моментом является создание этических рамок, правил и механизмов для обеспечения ответственного использования.

Член Arboretum, общественного форума Sprout, отметил, что ИИ может способствовать инклюзивности и уменьшать предвзятость/дискриминацию, обеспечивая справедливые и непредвзятые процессы принятия решений. Решая такие проблемы, как алгоритмическая предвзятость в разработке ИИ, можно было бы сформировать будущее, в котором ИИ станет позитивной силой перемен.

Наряду с потенциалом позитивных изменений существуют также возможности для неправильного или неэтичного использования ИИ по мере того, как он становится все более мощным. Наше сообщество обсудило несколько рисков, включая нарушение конфиденциальности, манипулирование общественным мнением и автономное оружие.

Подобные комментарии лишь затрагивают поверхность этических проблем в разных отраслях, но главные проблемы для маркетологов включают в себя: безопасность работы, конфиденциальность, предвзятость и дискриминация, дезинформация и дезинформация, а также проблемы интеллектуальной собственности/авторского права, которые мы подробно рассмотрим в следующий раздел.

Влияние на рабочие места и перемещение рабочих мест

Роботы, обеспечивающие мировое господство, — это наименьшая из наших забот — по крайней мере, на данный момент.

И это потому, что исследователям и экспертам не угрожает технологическая сингулярность или идея о том, что ИИ превзойдет человеческий интеллект и воспроизведет такие черты, как социальные навыки. Они знают об ограничениях ИИ и потенциальных последствиях замены рабочих мест.

Цель исследований и инвестиций в ИИ не в том, чтобы заменить людей, а в том, чтобы помочь нам сэкономить время и усилия, чтобы делать более эффективные вещи. Боб Вулфли, директор по социальным сетям и партнерским отношениям компании Flock Freight, провел прекрасную аналогию с ИИ: «ИИ похож на посудомоечную или стиральную машину в наших домах. Подумайте о том, сколько времени вы сэкономите, если не будете мыть посуду или одежду вручную».

В нашей серии «Непрочитанные» члены маркетинговой и творческой команды Sprout обсудили, как они в настоящее время используют ИИ, от персонализированных покупок до использования таких функций, как ViralPost, для планирования публикаций в социальных сетях. Посмотрите видео ниже, чтобы услышать их горячие мнения о преимуществах и опасениях ИИ, включая замену рабочих мест:

Вопросы конфиденциальности

Обеспокоенность, связанная с конфиденциальностью, защитой и безопасностью данных, является главной заботой брендов. Инвестиции в безопасность становятся все более приоритетными для предприятий, поскольку они стремятся избежать любых возможностей для наблюдения, взлома и кибератак. Поскольку персонализация становится все более популярной, бренды внедряют передовые методы сбора, хранения и анализа данных для защиты клиентов и организаций.

Алгоритмическая предвзятость и дискриминация

Поскольку он учится на данных, плохо сконструированный или обученный ИИ может демонстрировать предвзятость в отношении недопредставленных подмножеств данных. Было несколько крупных случаев предвзятости в отношении созданных ИИ произведений искусства, чат-ботов, программного обеспечения для распознавания лиц, алгоритмов и инструментов ИИ для практики найма.

Например, несколько пользователей TikTok и Twitter [переименованных в X в июле 2023 года] назвали ветку с изображением «#Южно-Суданской Барби», украшенной оружием, что является негативным стереотипом, связанным с регионом, борющимся с социально-политическими проблемами, такими как геноцид и кризисы с беженцами. .

![Ответ пользователя на сгенерированную искусственным интеллектом фотографию «#SouthSudan Barbie» в ветке Твиттера [с июля 2023 года переименована в X]. В сообщении говорится: «Мы продолжаем говорить вам, что предвзятость встроена в этот мусор, созданный ИИ».](/uploads/article/221435/S1hZxuJ0KyrnC8ur.png)

С предвзятостью, входящей в еще более низкие ставки, ИИ использует подобные случаи, возникает вопрос, как нам работать против предвзятости и дискриминации, когда наборы обучающих данных могут поддаваться предвзятости?

Дезинформация и дезинформация

Как и люди, ИИ не идеален. Ответы ИИ на подсказки могут быть неточными, и есть опасения, что люди распространят дезинформацию со злым умыслом. Наряду с угрозами дезинформации существует вероятность кризиса бренда и репутационного ущерба, особенно без соответствующих мер безопасности и протоколов.

Вопросы интеллектуальной собственности и авторского права

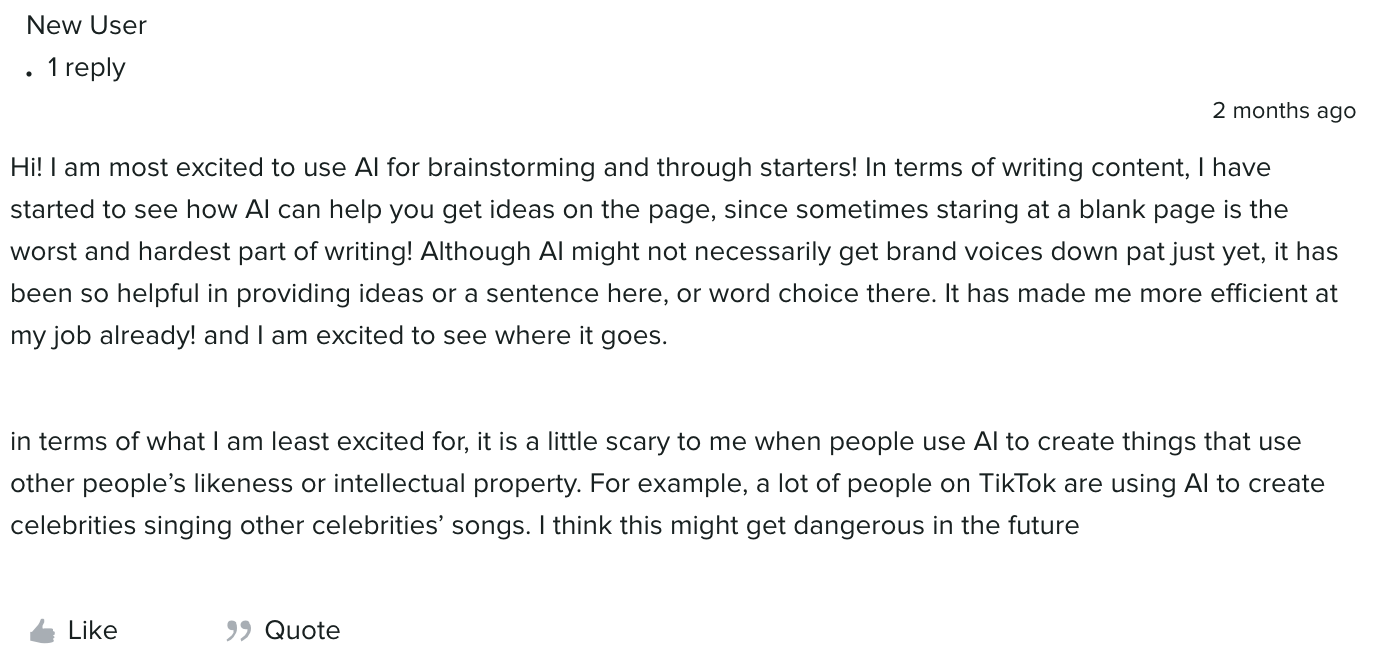

Вы, наверное, видели персонажей Гарри Поттера в фильмах Уэса Андерсона или жителей Бикини Боттом, поющих популярные песни. Это примеры того, как многие используют ИИ для использования изображений и подобий людей или интеллектуальной собственности.

ИИ — отличный спарринг-партнер для творческих задач, таких как мозговой штурм и создание набросков, но в зависимости от того, как используются результаты, он может привести к нарушению авторских прав, плагиату и нарушению прав интеллектуальной собственности. Например, в январе 2023 года группа художников подала иск против Midjourney и Stability AI, утверждая, что инструменты нарушают права миллионов художников. Генеративный ИИ открывает юридическую банку червей, и есть еще много вопросов, которые нужно охватить, но создание упреждающих правил и рамок поможет снизить этические риски.

5 шагов для поддержания этики ИИ в командах

Вот пять шагов, которые помогут вам составить план по снижению этических рисков, связанных с ИИ:

1. Установите внутренние основные правила и обязанности по использованию ИИ

Рассмотрите возможность создания группы по этике ИИ, состоящей из специалистов по этике, юристов, технологов и руководителей, которые помогут установить основные правила для вашей организации. Например, использование генеративного ИИ только для черновиков и мозгового штурма, но не для внешнего опубликованного контента, является отличным основным правилом.

Наряду с этими основными правилами определите роль и обязанности каждого члена команды, участвующего в ИИ, включая команду по этике. Установите свои цели и ценности для ИИ. Это поможет заложить основу для вашей политики в области этики ИИ и лучших практик.

2. Определите и проверьте роль ИИ

ИИ не может заменить создателей контента, специалистов по стратегии в социальных сетях или любую другую роль в маркетинге. Определите задачи ИИ, которые требуют надзора или вмешательства человека, и определите цели вашей политики этики ИИ, чтобы помочь разработать процессы для разработки, управления и информирования об ИИ.

Как только вы определите цели своей этической политики, определите пробелы и возможности для ИИ в вашей организации. Рассмотрим следующие вопросы:

- Как организация использует ИИ в настоящее время и как мы хотим использовать его в будущем?

- Какое программное обеспечение и анализ могут помочь нам снизить бизнес-риски?

- Какие пробелы создают технологии и анализ? Как нам их заполнить?

- Какие тесты или эксперименты нам нужно провести?

- Какие существующие решения мы можем использовать с текущими передовыми практиками для наших продуктовых команд?

- Как вы будете использовать данные и идеи?

- Как мы установим позиционирование нашего бренда и обмен информацией о технологиях и этике ИИ?

3. Разработайте надежный процесс оценки поставщиков.

Сотрудничайте со своими ИТ- и юридическими командами, чтобы должным образом проверять любые инструменты с возможностями ИИ и устанавливать процесс этического риска. Их опыт поможет вам оценить новые соображения, такие как набор данных, на котором обучается инструмент, и средства контроля, которые поставщики используют для смягчения предвзятости ИИ. Процедура комплексной проверки каждого инструмента перед внешним или внутренним запуском поможет вам снизить будущие риски.

4. Поддерживайте прозрачность раскрытия информации

Сотрудничайте со своими юридическими и/или конфиденциальными командами, чтобы разработать внешние сообщения и/или заявления об отказе от ответственности, чтобы указать, где и когда ваш бренд полагается на ИИ. Эти сообщения можно использовать для контента, обслуживания клиентов и т. д. Например, TikTok обновил свои принципы сообщества, требуя от создателей маркировать контент, созданный ИИ. Сообщая о своих этических стандартах и принципах защиты этики ИИ, вы поможете завоевать доверие коллег, потенциальных клиентов и клиентов.

5. Продолжайте обучение среди руководства и команд.

ИИ — это не то, с чем бизнес-руководители могут спешить. Как и в любой новой волне новых инноваций, помимо новых технологических вех будет существовать кривая обучения. Помогите уравнять правила игры, организовав внутренние тренинги и семинары, чтобы обучить всех членов команды, руководителей и заинтересованных лиц этике ИИ и тому, как ответственно его создавать.

Поступайте правильно с этикой ИИ

Учитывать этику — это не просто правильно, это важнейший компонент использования технологий искусственного интеллекта в бизнесе.

Узнайте больше от лидеров и маркетологов о том, как ИИ повлияет на будущее социальных сетей, на нашем вебинаре, а также о других выводах из отчета о состоянии социальных сетей в 2023 году и советах по созданию эффективного социального контента.