Список из 22+ лучших инструментов для веб-скрейпинга 2022 года Какой лучший инструмент для веб-скрейпинга?

Опубликовано: 2022-10-21

Скребковый робот

Scraper API обрабатывает прокси, браузеры и CAPTCHA, поэтому вы можете получить HTML с любой веб-страницы с помощью простого вызова API!

Bright Data (ранее Luminati)

Bright Data (ранее Luminati) — это крупнейший в мире прокси-сервис с резидентной прокси-сетью из 72 М IP-адресов по всему миру и интерфейсом управления прокси-серверами для нулевого кодирования. Начните 7-дневную бесплатную пробную версию.

API парсера

Scraper API обрабатывает прокси, браузеры и CAPTCHA, поэтому вы можете получить HTML с любой веб-страницы с помощью простого вызова API!

В этом посте мы перечислили лучшие инструменты веб-скрейпинга, которые вы должны попробовать прямо сейчас. Итак, давайте погрузимся.

Инструменты Web Scraping специально созданы для извлечения данных с веб-сайтов. Эти инструменты, также известные как инструменты для сбора данных из Интернета или инструменты для извлечения данных из Интернета, полезны для людей, которые хотят собирать какие-либо данные или информацию с интернет-сайтов. Web Scraping — это современный метод ввода данных, который устраняет необходимость повторного ввода или копирования информации.

Эти виды программного обеспечения ищут новые данные вручную или автоматически, извлекают обновленные данные и сохраняют их, чтобы вы могли легко получить к ним доступ. Например, вы можете собрать информацию о товарах и их стоимости с Amazon с помощью инструмента парсинга.

Если вы копируете данные с сайта в электронную таблицу, базу данных или любое другое центральное место для последующего извлечения, то вы очищаете Интернет. Но если вы делаете это вручную, это может занять много времени.

Вы можете выполнить этот процесс сбора данных автоматически, используя инструменты веб-скрейпинга.

Вы можете выполнять веб-скрейпинг с помощью следующих восьми методов:

- Анализ объектной модели документа (DOM)

- HTML-разбор

- Ручное копирование и вставка

- Вертикальная агрегация

- Сопоставление текстового шаблона

- Распознавание семантической аннотации

- Анализ веб-страниц компьютерного зрения

- HTTP-программирование

Оглавление

Ищете лучшие инструменты для веб-скрейпинга 2021 года?

Такие процедуры, как веб-скрейпинг, HTML-скрейпинг или любая другая форма извлечения данных, могут быть сложными. От получения точного исходного кода страницы и точного просмотра источника до рендеринга javascript и получения данных в пригодной для использования конфигурации на самом деле предстоит проделать большую работу. Несмотря на то, что у разных пользователей разные требования, есть инструменты, доступные для каждого из них — людей, которые хотят создавать веб-скраперы с нулевым кодированием, разработчиков, которые хотят создавать веб-сканеры для сканирования больших сайтов, и многих других.

В этом посте мы перечисляем 20 лучших инструментов веб-скрейпинга для сбора данных без кодирования. Мы также перечислили 4 дополнительных инструмента после списка 20 лучших, что составляет 24 инструмента для парсинга веб-страниц, из которых вы можете выбирать.

Топ 22+ лучших инструментов веб-скрейпинга 2022 года:

Вот список из 20 лучших инструментов веб-скрейпинга на октябрь 2022 года, которые вы должны использовать для удовлетворения потребностей в извлечении данных вашего веб-сайта. Эти инструменты были отмечены как пользователями, так и критиками за их функции, общую производительность, цены и другие ключевые аспекты как одни из лучших инструментов, которые вы можете использовать для веб-скрейпинга.

1) Bright Data (ранее Luminati) №1 среди лучших инструментов для веб-скрейпинга

Luminati Networks создала инструмент сбора данных нового поколения, который обеспечивает интегрированный и персонализированный поток данных на единой, простой для понимания приборной панели. Наборы данных адаптированы к потребностям вашей компании, начиная от тенденций электронной коммерции и контента социальных сетей и заканчивая бизнес-аналитикой и опросами потребителей.

Инструменты и возможности:

- Вы можете получать автоматизированную аналитику данных от Data Collector в любое время и в любом месте.

- Нет необходимости в сложной платформе для сбора данных.

- У вас есть полный контроль над процессом сбора данных.

- Разблокировщик данных

- Менеджер прокси Luminati позволяет вам управлять своими прокси как профессионал без программирования.

- Через несколько минут у вас будет стабильный поток данных.

- С помощью одного заказа их Search Engine Crawler следующего поколения позволяет вам получать реальные результаты поиска пользователей по любому ключевому слову во всех основных поисковых системах.

- Сбор данных, который является универсальным и чувствительным к заменителям на целевом сайте, что приводит к высокой степени успеха.

- Их удобное расширение для браузера позволяет легко ориентироваться на конкретную геолокацию и изменять настройки прокси-сервера.

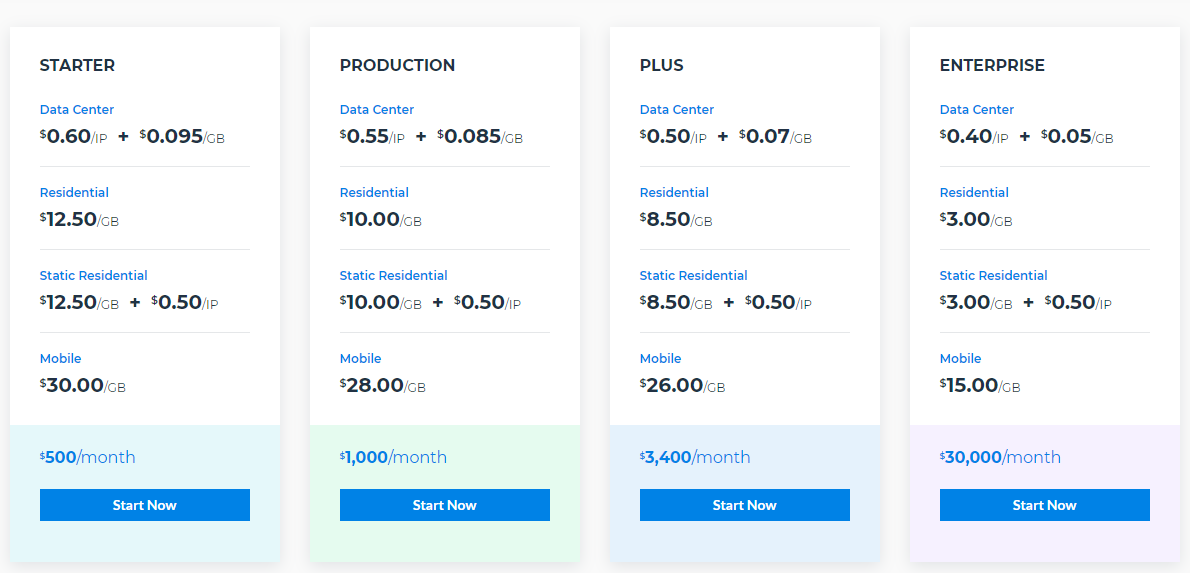

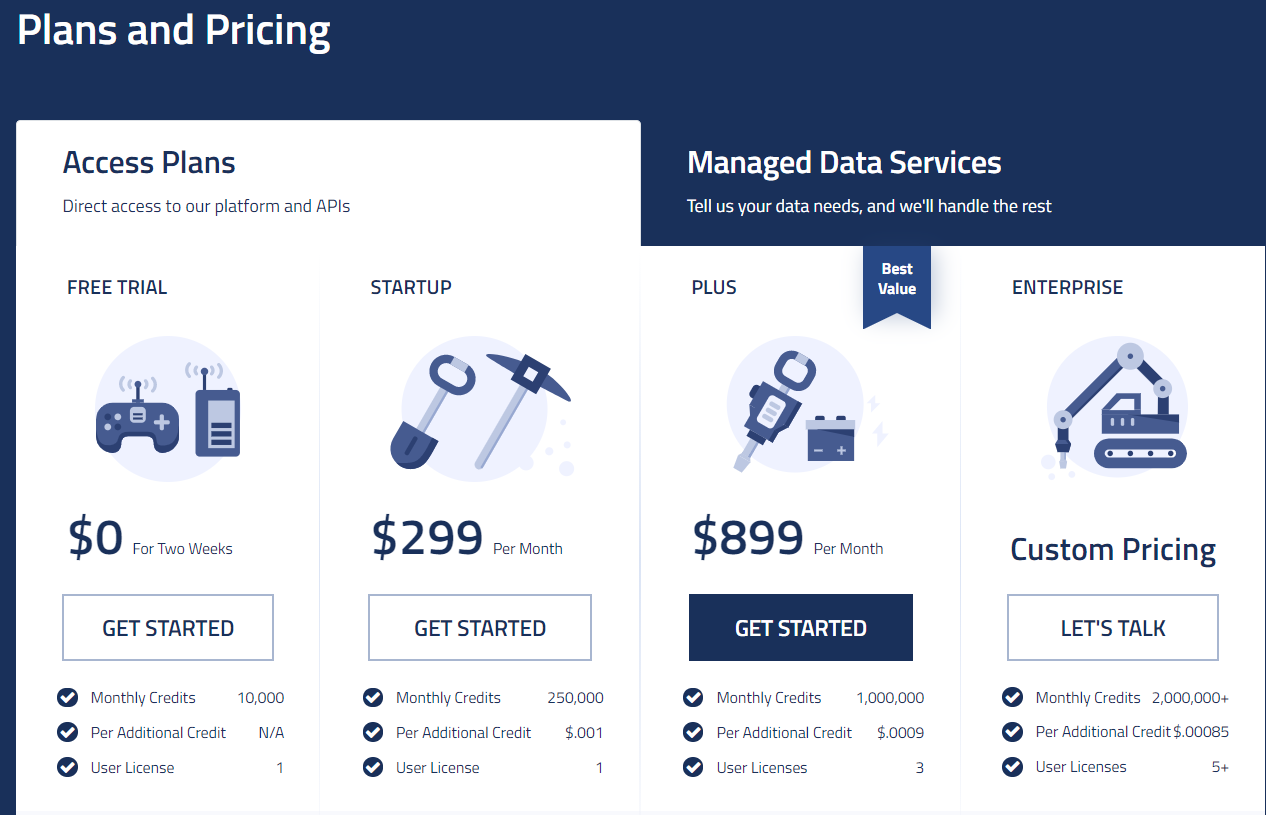

Цены

2) Scraping Robot № 2 Лучший инструмент для веб-скрейпинга

Scraping Robot — эффективный и удобный инструмент для очистки веб-страниц. Поскольку он очень прост в использовании, он подходит для начинающих. У него есть некоторые современные инструменты и функции, которые не предлагают большинство других доступных сайтов, а даже если они и есть, они берут с вас гораздо больше.

Это лучший инструмент для сбора данных и развития вашего бизнеса. Они установили несколько партнерских отношений в отрасли, чтобы снизить цену в нескольких местах, и разработали хорошо организованную процедуру, которая снижает затраты на разработку и технические расходы. Таким образом, все эти характеристики создают продукт, обеспечивающий более высокий уровень производительности по более низкой цене, чем у конкурентов.

Инструменты и возможности

- Фильтр модуля:

Хотя эта функция находится в стадии разработки, в ближайшем будущем они могут добавить такие функции, как фильтры продуктов и фильтры профилей.

- Библиотека демонстраций:

Эта библиотека содержит все детали и информацию о том, как работает каждый модуль.

- API:

Они предоставляют своим клиентам доступ на уровне разработчика. Это может помочь вам организовать прокси-серверы, серверы и ресурсы разработчиков и управлять ими.

- Дорожная карта:

Под этим сегментом можно увидеть, на что все они рассчитаны в будущем. Это позволит вам узнать, какие все функции будут доступны для вас в ближайшем будущем.

Он разделен на три части:

- Жить

- В ходе выполнения

- Планируется

Вы также можете проголосовать или предложить некоторые функции. Они также обещают добавлять все больше и больше функций на свою страницу с ценами.

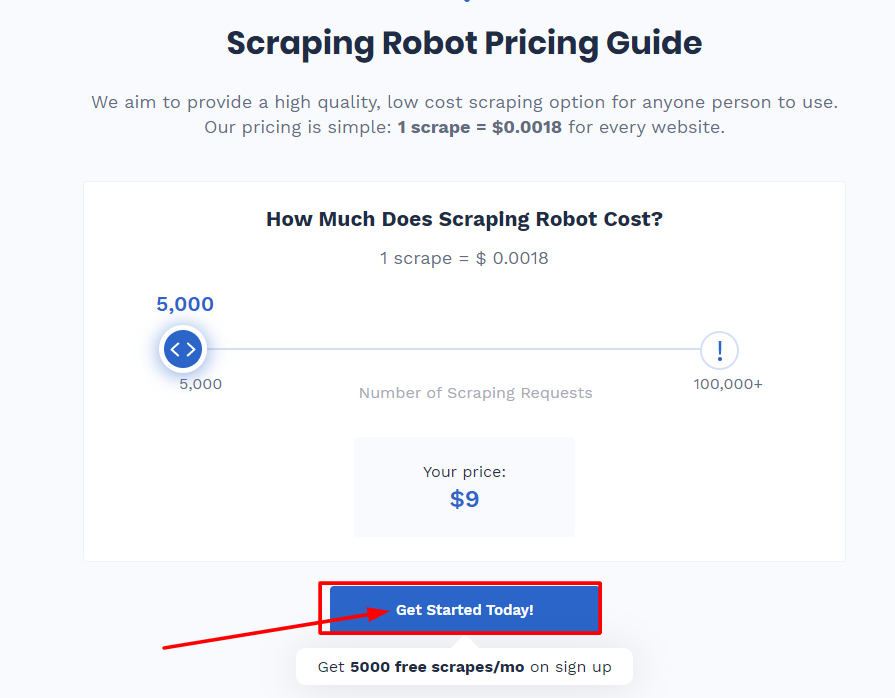

Планы и цены

Когда вы зарегистрируетесь, они будут предоставлять вам 5000 скрейпов каждый месяц бесплатно. Этого вполне достаточно, если данных, которые вы ищете, меньше, но если вам нужно больше данных, вам придется заплатить 0,0018 доллара за чистку. По их словам, причиной этого является их сотрудничество с Blazing SEO, поставщиком премиальных прокси.

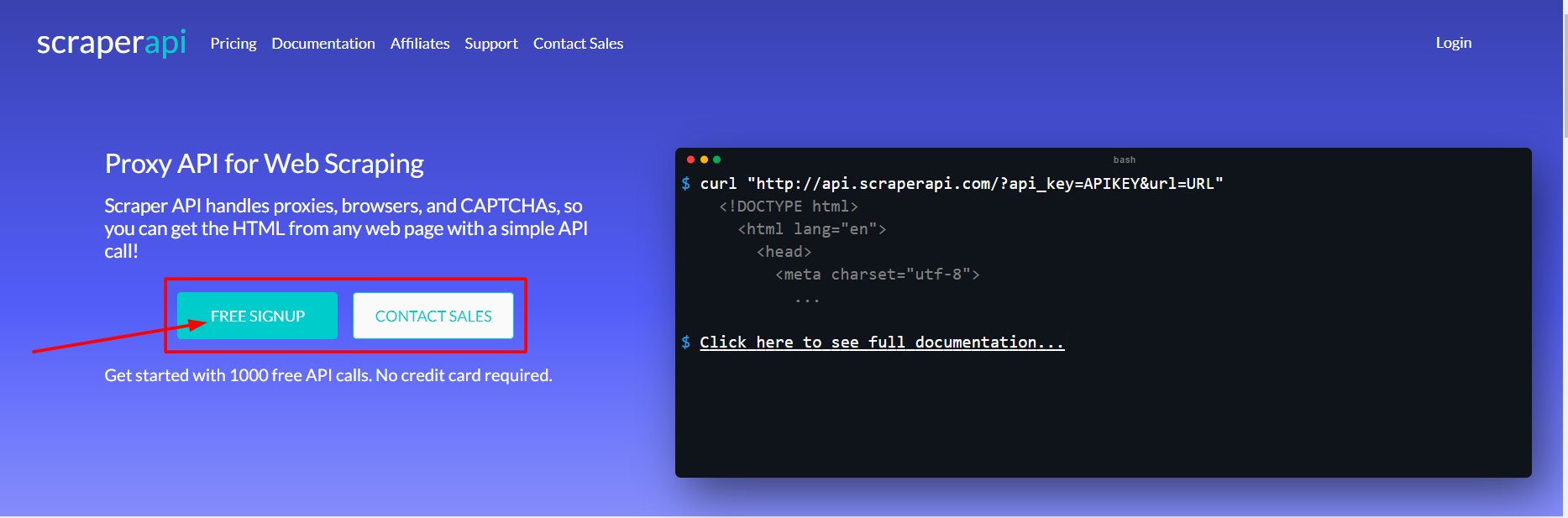

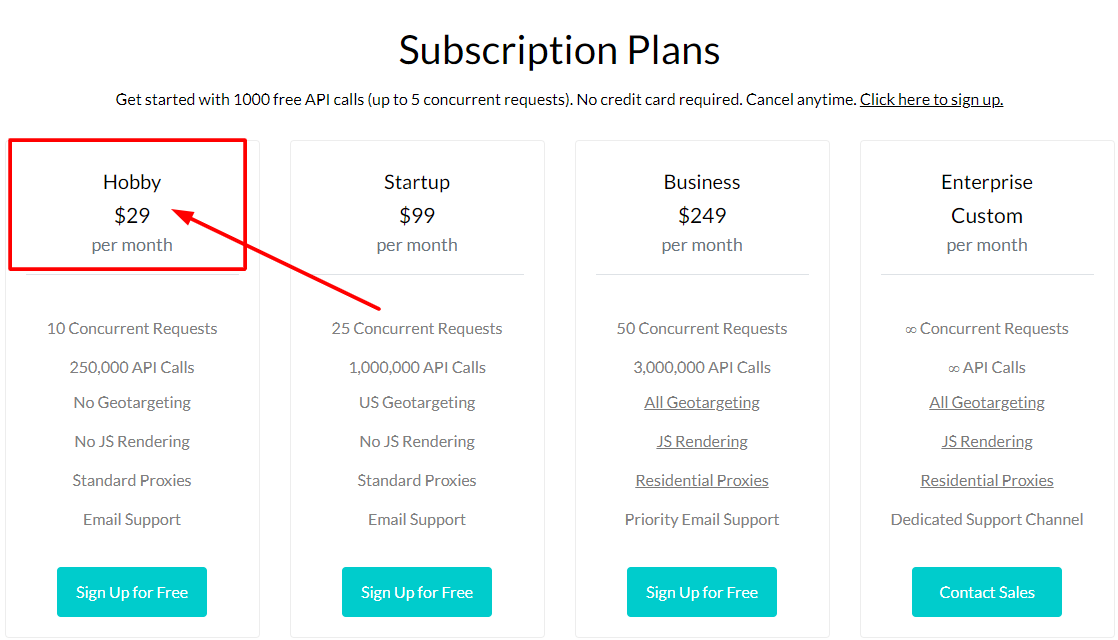

3) Scraper API №3 среди лучших инструментов для парсинга веб-страниц

Scraper API — это программа, которая позволяет программистам создавать веб-скрейперы. Он работает для прокси-серверов, браузеров и CAPTCHA, позволяя разработчикам получать необработанный HTML-код с любого сайта с помощью простого вызова API.

Это идеальная платформа веб-скрейпинга для разработчиков с выделенными пулами прокси для парсинга социальных сетей, парсинга билетов, парсинга поисковых систем, парсинга цен электронной коммерции и многого другого! л. Вы можете подать заявку на оптовую скидку, если вам нужно большое количество страниц ежемесячно.

Инструменты и функции

- Это поможет вам отображать JavaScript

- Вы можете настроить заголовки каждого запроса, а также тип запроса

- Он предлагает исключительную скорость и надежность, что помогает в создании масштабируемых парсеров.

- Геолокированные вращающиеся прокси

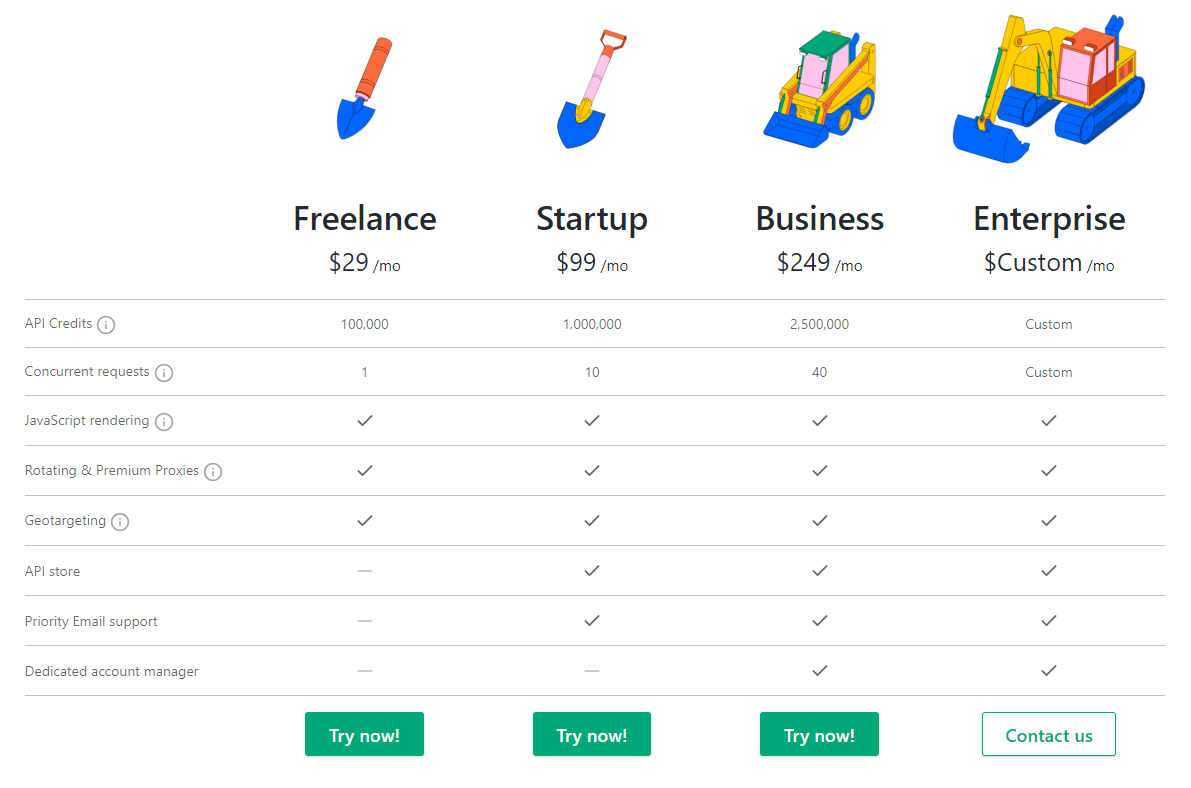

Цены

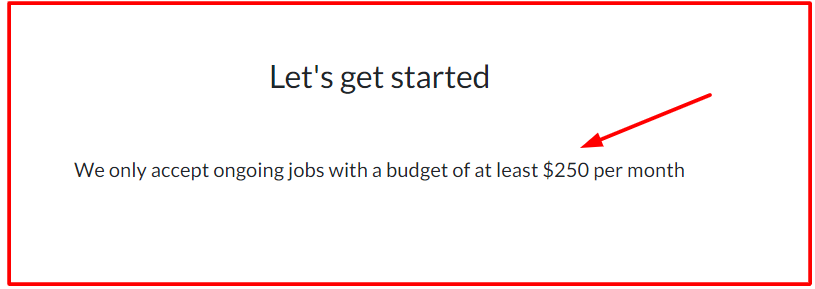

4) ОчиститьSimple

ScrapeSimple — лучший инструмент для веб-скрейпинга для разработчиков, которые ищут собственный парсер, разработанный с нуля. Извлечение данных теперь так же просто, как заполнение формы со всеми вашими предпочтениями и инструкциями для типа данных, которые вы хотите.

ScrapeSimple показывает, что это профессионально управляемый инструментальный сервис, который создает и управляет пользовательскими парсерами для своих пользователей. Просто скажите им, какие данные вы хотите собирать и с какого сайта, и ваш персонализированный парсер будет настроен на отправку данных вам в формате CSV на регулярной основе (ежедневно, еженедельно, ежемесячно или в любое время) напрямую. на ваш почтовый ящик.

Этот инструмент подходит для предприятий, которым нужен только парсер HTML и не нужно вручную записывать какой-либо код. Их время отклика молниеносно, а их обслуживание клиентов очень полезно и приветливо.

Цены

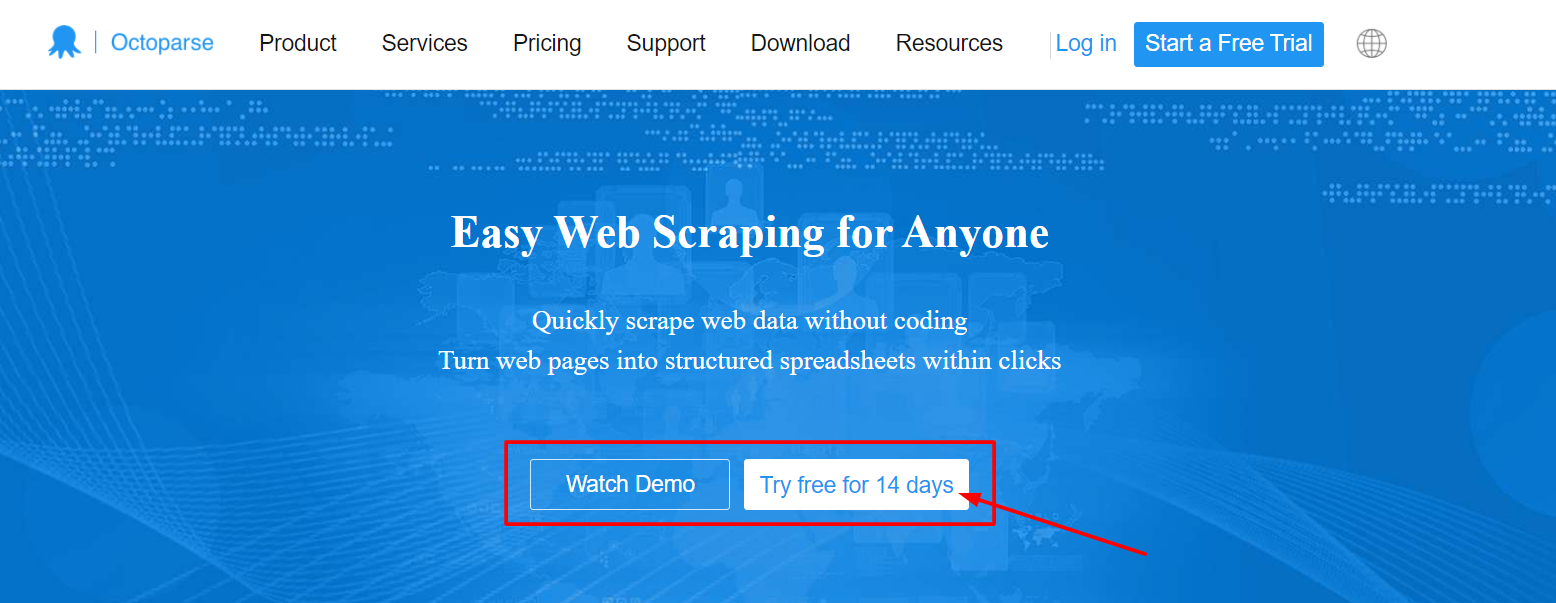

5) Октопарс

Octoparse — отличный и быстрый инструмент для парсинга веб-страниц как для программистов, так и для тех, кто не занимается кодированием, которые хотят извлекать информацию с веб-сайтов без написания кода, но при этом иметь полный контроль над процессом. Это очень распространено для очистки данных электронной коммерции.

Его можно использовать для извлечения веб-данных в большем масштабе (до миллионов), а данные можно хранить в упорядоченных и структурированных файлах, таких как Excel и CSV, для загрузки. Клиенты также могут воспользоваться бесплатным планом и пробной версией для платных подписчиков.

Популярные функции этого инструмента включают:

- Облачное извлечение с ротацией IP для обхода капчи и блокировки

- Он имеет встроенный инструмент RegEx для автоматической очистки данных.

- Вы можете запланировать просмотр веб-страниц и периодически получать обновления данных.

- Он использует соединение API для настройки конвейера данных непосредственно в вашу базу данных.

- Он поддерживает системы Windows и Mac.

Цены

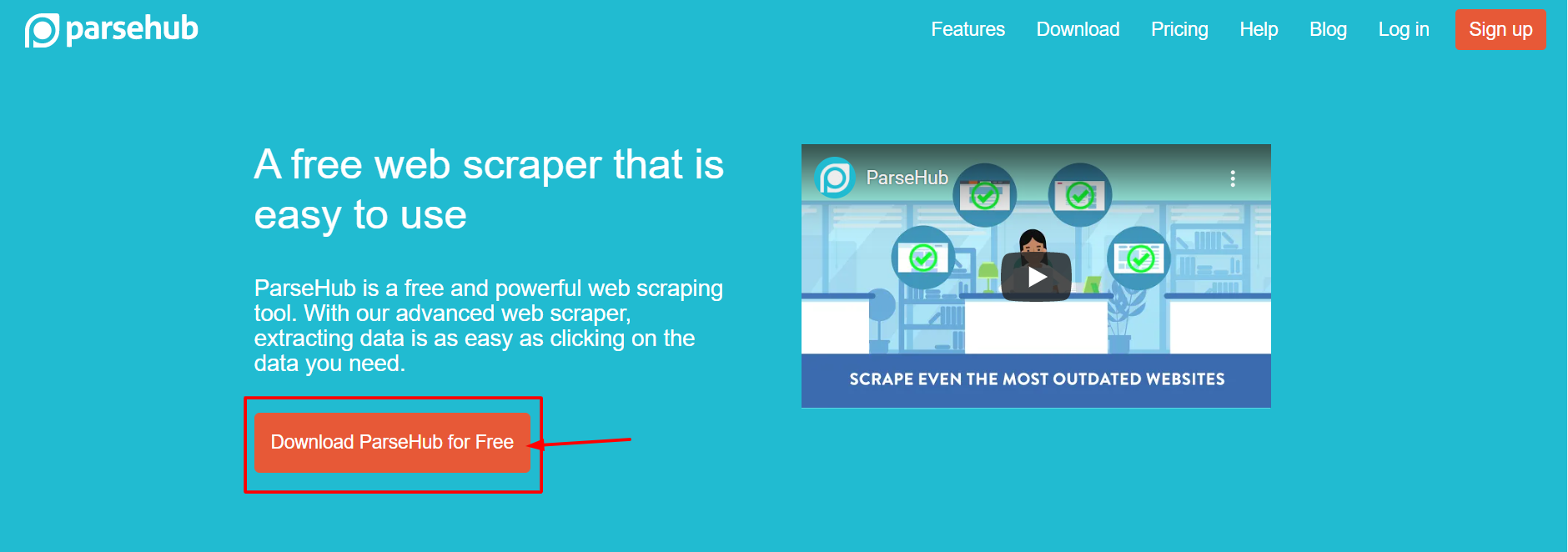

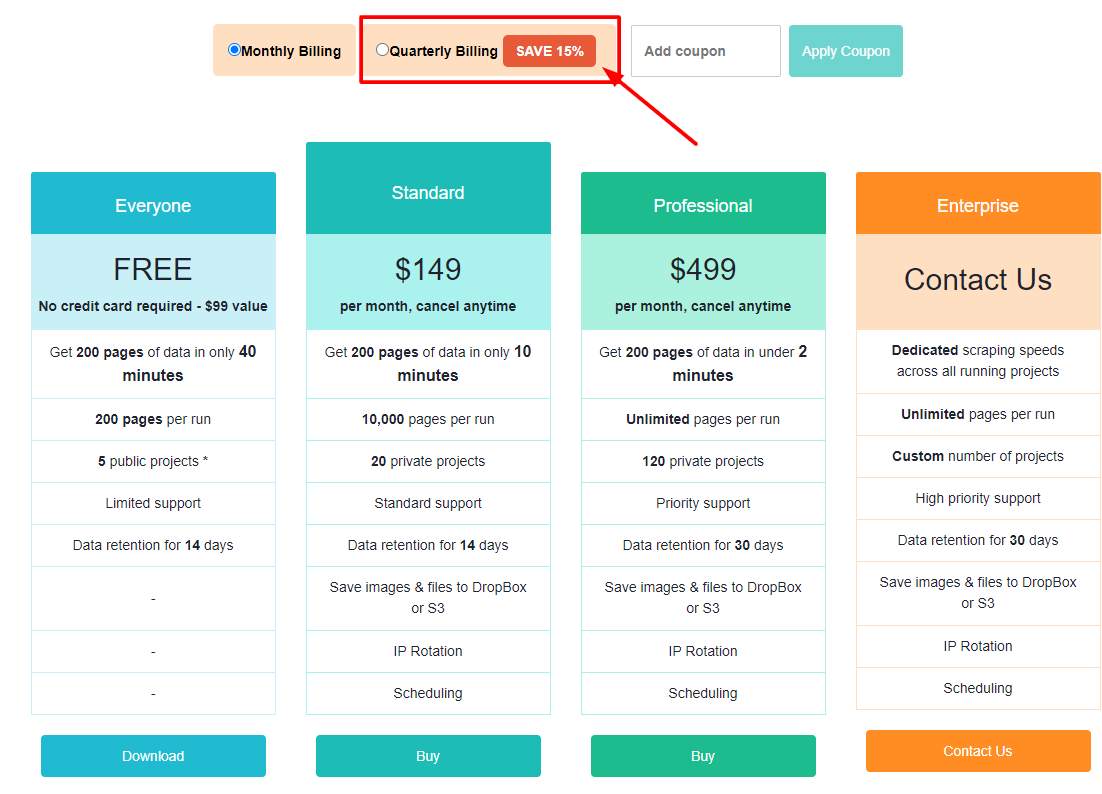

6) ПарсХаб

Parsehub — замечательный и эффективный бесплатный инструмент для парсинга веб-страниц, который позволяет создавать веб-скрейперы без написания кода. Его используют многие аналитики, журналисты, специалисты по данным и другие. Его действительно легко использовать. Очень легко визуализировать веб-скрейперы. Вам просто нужно нажать на данные, которые вы хотите экспортировать, и они будут экспортированы в формате JSON или Excel.

Пользователи могут пользоваться такими функциями, как автоматическая ротация IP-адресов, парсинг без входа в систему, навигация по раскрывающимся спискам и вкладкам, извлечение данных из таблиц и карт и многое другое. Кроме того, он предоставляет щедрый бесплатный план, который позволяет пользователям очищать до 200 страниц данных менее чем за 40 минут! Он предлагает настольные клиенты для Windows, Mac OS и Linux, что позволяет вам получать к ним доступ с вашего компьютера независимо от операционной системы.

Инструменты и возможности

- Очистка текста и HTML перед загрузкой данных

- Простой в использовании графический интерфейс

- Собирать и хранить информацию на серверах автоматически

Цены

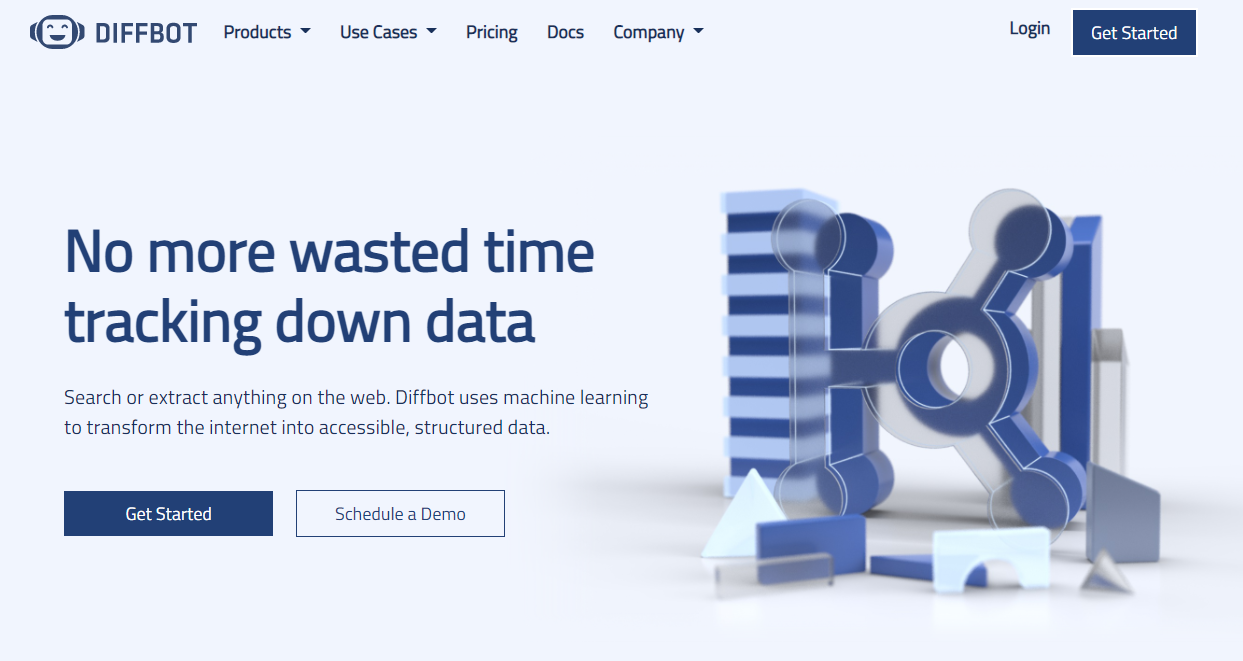

7) Диффбот

Diffbot идентифицирует полезные данные на веб-странице, используя компьютерное зрение, а не декодирование HTML, что отличает его от других парсеров, доступных в Интернете. Это означает, что даже если HTML-разметка страницы изменится, парсеры будут продолжать работать до тех пор, пока внешний вид страницы остается прежним.

Это отличная функция для долго работающих парсеров веб-скрейпинга. С помощью этого инструмента экстракторы AI позволяют извлекать структурированные данные из URL любой формы. Хотя это немного дорого, он предлагает роскошное решение, которое некоторые потребители считают стоящим. Их самый дешевый план стоит 299 долларов в месяц.

Инструменты и возможности:

- У вас будет доступ к ряду источников данных, основанных на полном и точном понимании каждой системы.

- С помощью экстракторов AI можно извлекать структурированные данные из любого URL-соединения.

- С помощью Crawlbot Knowledge Graph вы можете масштабировать извлечение данных до нескольких доменов.

- Эта функция предоставляет вам точные, полные и подробные данные из Интернета, которые требуются бизнес-аналитике для создания полезной аналитики и идей.

Цены

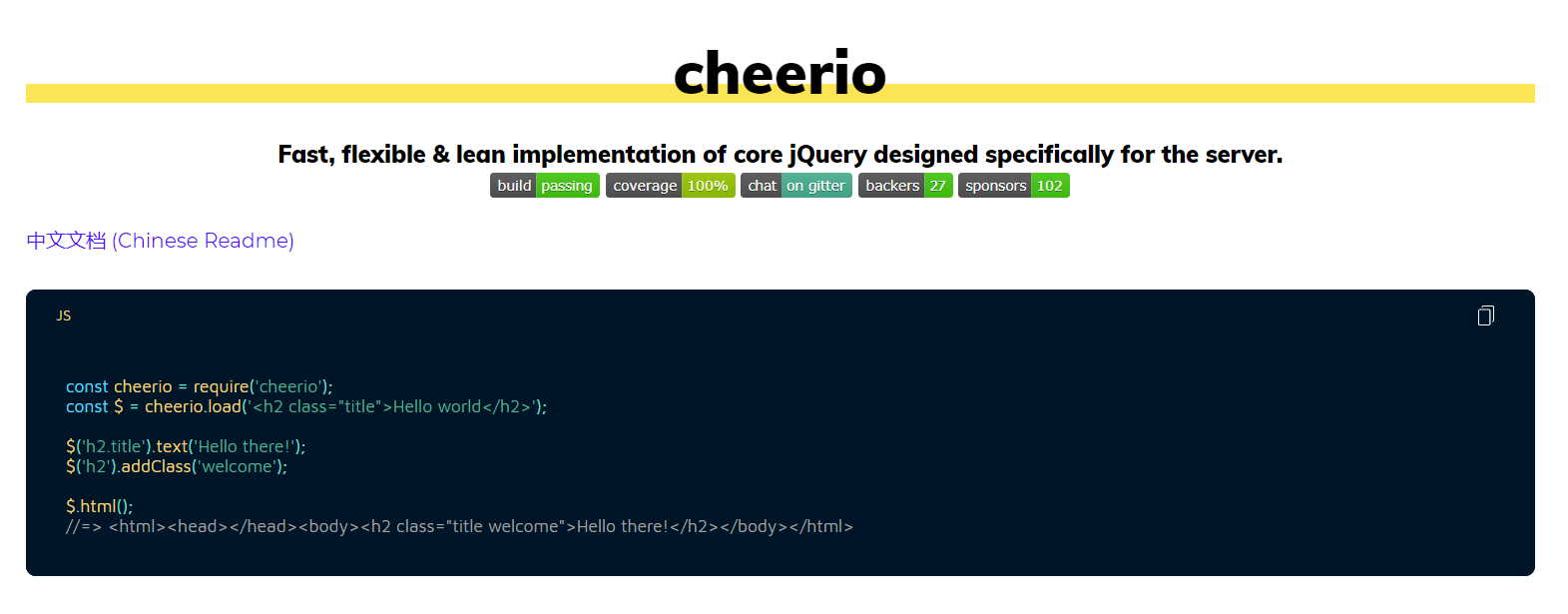

8) Веселье

Он предназначен для разработчиков NodeJS, которые хотят просто анализировать HTML. Те разработчики, которые знакомы с jQuery, могут сразу заметить лучший синтаксис парсинга веб-страниц javascript.

У Cheerio есть API, который очень похож на jQuery, что упрощает разработчикам, уже знакомым с jQuery, использование этого веб-инструмента для парсинга HTML. Это молниеносно и имеет ряд полезных функций для очистки HTML, текста, идентификаторов, классов и многого другого. Долгое время это была самая популярная библиотека для анализа HTML, написанная на NodeJS, и, возможно, это один из самых популярных инструментов веб-скрейпинга NodeJS или javascript для новых проектов.

9) Красивый суп

BeautifulSoup — это идеальный инструмент для разработчиков Python, которым нужен простой и удобный интерфейс для анализа HTML, но не нужны возможности или трудности, связанные с другими парсерами.

Beautiful Soup — это наиболее распространенный парсер HTML для разработчиков Python, подобно тому, как Cheerio — лучший инструмент для веб-скрейпинга для разработчиков NodeJS. Прошло десять лет с тех пор, как этот метод был так хорошо принят и зарегистрирован.

Доступно множество руководств по синтаксическому анализу веб-страниц, чтобы научить разработчиков использовать этот метод для очистки различных веб-сайтов как в Python 2, так и в Python 3. Если вы ищете библиотеку для синтаксического анализа HTML Python, это, безусловно, лучший вариант.

10) Мозенда

Mozenda — идеальная платформа для корпораций и предприятий, которым нужен самообслуживаемый облачный инструмент для очистки веб-страниц. Mozenda просмотрела более 7 миллиардов страниц и имеет опыт обслуживания клиентов со всего мира.

Его клиенты могут использовать свою мощную облачную платформу для запуска парсеров. Одной из особенностей, которая отличает их от других инструментов веб-скрейпинга, является поддержка клиентов, которая предоставляет номера телефонов и адреса электронной почты для всех платных пользователей. Эта платформа имеет широкие возможности расширения и, как и Diffbot, немного дорогая: самый простой пакет стоит от 250 долларов в месяц.

Вы можете очищать текст, изображения и материалы PDF с веб-страниц с помощью Mozenda. Он известен как одно из лучших приложений для веб-скрейпинга для обработки и подготовки файлов данных к публикации.

Инструменты и возможности:

- Вы можете использовать свой любимый инструмент Bl или базу данных для сбора и публикации веб-данных.

- Всего за несколько минут вы можете создавать агенты парсинга веб-страниц, используя интерфейс «укажи и щелкни».

- Включены функции Job Sequencer и Request Blocking, которые помогают собирать веб-данные в режиме реального времени.

- Это показывает, что у него лучшее управление учетными записями и обслуживание клиентов в отрасли.

11) Соскоб пчелы

Scraping Bee — это приложение для парсинга веб-страниц, которое работает с несколькими браузерами и прокси-серверами. Он также может запускать Javascript на веб-страницах и менять прокси-серверы для каждого запроса, позволяя вам получать доступ к необработанной HTML-странице без блокировки. У них также есть специальный API для очистки результатов поиска Google.

Инструменты и возможности:

- Он поддерживает рендеринг JavaScript

- Он предлагает автоматическую ротацию прокси.

- Вы можете напрямую использовать это приложение в Google Sheet.

- Это приложение поддерживается веб-браузером Google Chrome.

- Хорошо подходит для парсинга Amazon

- Поддерживает парсинг поиска Google

Цены

12) xtract.io

xtract.io — это персонализированный инструмент очистки данных, который собирает и упорядочивает веб-данные, текстовые документы, PDF-файлы, сообщения социальных сетей, исторические данные и даже электронные письма в формате, готовом для бизнеса.

Инструменты и возможности

- С помощью персонализированного инструмента извлечения данных вы можете собирать подробные данные, такие как информация из каталога продукции, контактные данные, сведения о компании, финансовая информация, списки работ, данные об аренде, обзоры, данные о местоположении и рейтинги.

- Благодаря мощной платформе API вы можете легко включать расширенные и очищенные данные непосредственно в свои бизнес-приложения.

- С предварительно настроенными планами вы можете автоматизировать весь процесс извлечения данных.

- По сравнению с предварительно настроенными бизнес-правилами с жесткой согласованностью данных вы можете получить доступ к проверенным данным высокого качества.

- Данные можно экспортировать в различных форматах, включая JSON, текстовые файлы, HTML, CSV, TSV и другие.

- Избегайте проблем с CAPTCHA, меняя прокси-серверы, чтобы легко извлекать данные в реальном времени.

13) Скребок-бот

Scraping-Bot.io — это хорошо организованный метод извлечения информации из URL-адресов. Он предоставляет API-интерфейсы, настроенные в соответствии с вашими потребностями в извлечении, такие как общий API для извлечения необработанного HTML-кода веб-страницы, инфраструктура API для очистки веб-сайта и API для извлечения списков недвижимости с веб-сайтов недвижимости.

Инструменты и возможности:

- Легко интегрируется

- Рендеринг JavaScript в безголовых браузерах

- Доступные тарифные планы

- Работает с прокси и веб-браузерами

- Прокси высокого качества

- Полная HTML-страница

- До 20 одновременных запросов

- Геотаргетинг

- Позволяет удовлетворить широкий спектр требований по очистке сыпучих материалов

- Ежемесячный план базового использования бесплатно

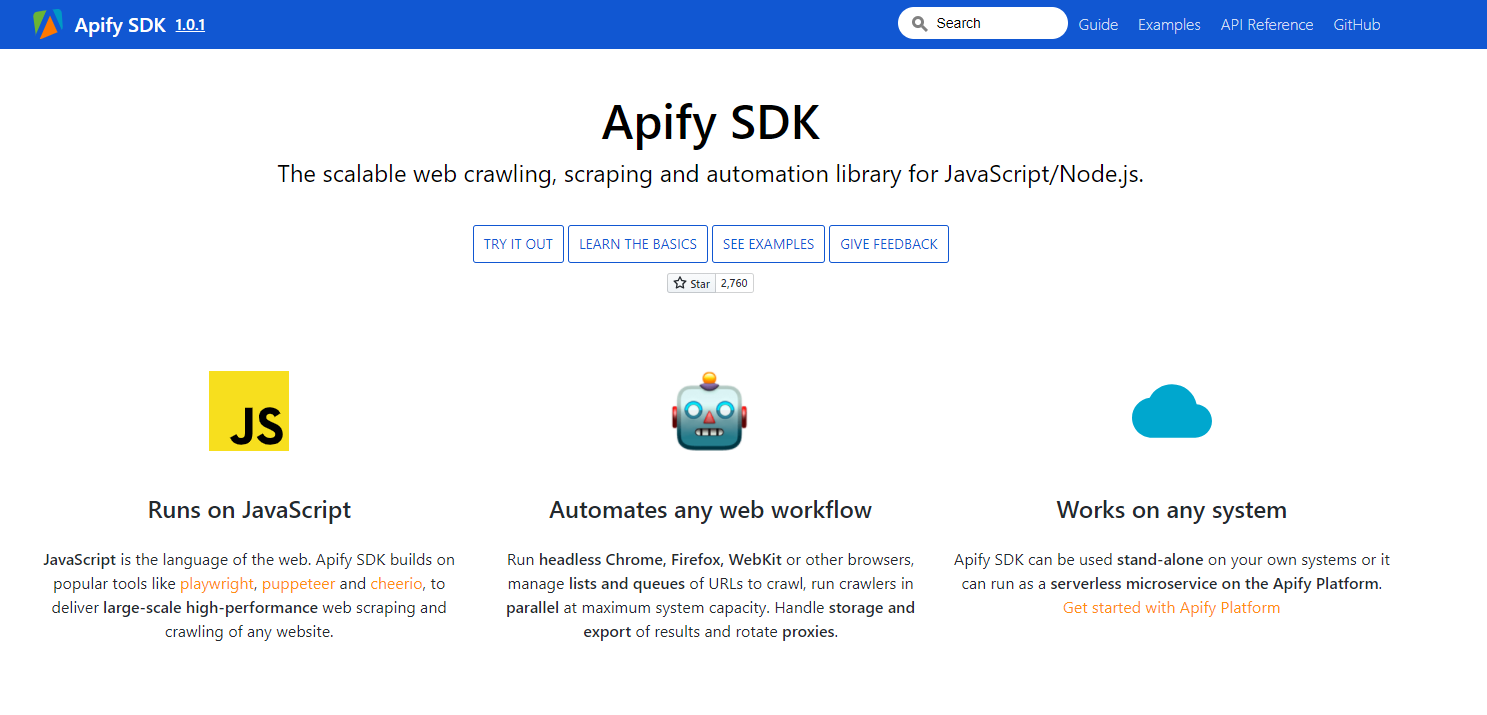

14) Апифай SDK

Apify SDK — это библиотека веб-сканирования, парсинга и автоматизации Javascript и NodeJS. Он позволяет использовать безголовые браузеры для создания, веб-автоматизации и обмена данными.

Инструменты и возможности:

- Автоматизирует любой веб-процесс. Запускайте безголовые веб-браузеры, такие как Google Chrome, Mozilla Firefox, WebKit или другие браузеры.

- Управляйте и организуйте списки и URL-адреса для сканирования и запускайте сканеры одновременно с максимальной производительностью системы.

- Займитесь хранением и экспортом результатов и ротацией прокси.

- Беспроблемное и быстрое сканирование в Интернете

- Может работать в любой системе

- Работает на JavaScript

15) Импорт.ио

Import.io помогает вам в разработке наборов данных, импортируя информацию с одной страницы и экспортируя ее в формат CSV. Это один из наиболее часто используемых инструментов веб-скрейпинга для интеграции данных в приложения через инфраструктуру API и HTTP-API.

Инструменты и возможности:

- Взаимодействия с веб-формами или логинами просты и понятны.

- Вы также можете заранее подготовить извлечение данных.

- Благодаря поддержке облака Import.io вы можете хранить и получать доступ к данным.

- Сделайте наглядный отчет с диаграммами и графиками.

- Взаимодействия и проекты в Интернете автоматизированы.

16) Webhose.io

Webhose.io предлагает вам прямой доступ к встроенным данным и данным в реальном времени для сканирования тысяч веб-сайтов. Это дает вам доступ к аутентичным каналам с более чем десятью годами полезных знаний.

Инструменты и возможности:

- Стандартизированные и машиночитаемые наборы данных JSON и XML.

- Это позволяет вам получить доступ к обширной базе данных каналов данных без необходимости платить какие-либо дополнительные сборы.

- Его расширенный фильтр помогает в управлении детальным анализом и файлами данных, которые необходимо передать.

17) Декси Интеллектуал

Dexi Intelligent — еще одно популярное приложение для парсинга веб-страниц, которое позволяет мгновенно превратить любой объем данных в ценность для бизнеса. Этот инструмент для парсинга веб-страниц позволяет сократить расходы и сэкономить время для вашей компании.

Инструменты и возможности:

- Повышение качества, точности и эффективности

- Максимальная скорость для анализа данных

- Быстрое и эффективное извлечение данных

- Захват знаний в больших масштабах

18) Перехитрить

Это надстройка для Firefox, которую легко установить из магазина надстроек Firefox. Чтобы купить этот продукт, вам будут предложены три различных альтернативных плана, основанных на ваших потребностях.

- Pro Edition (мощный простой веб-скрейпинг)

Годовая подписка: $69.00

Разовая покупка: $95.00

- Expert Edition (Мастер для опытных пользователей)

Годовая подписка: $195.00

Разовая покупка: $275.00

- Enterprise Edition (большой объем, многопользовательский)

Годовая подписка. : $535.00

Разовая покупка: $745.00

Инструменты и возможности:

- Вы можете использовать Email Sourcer V.9 для получения контактов из Интернета.

- Outwit Hub не требует специальных навыков программирования для извлечения знаний из веб-сайтов.

- Вы можете начать парсинг тысяч веб-страниц одним нажатием кнопки исследования.

Цены

19 ) Стример данных

Инструмент Data Streamer помогает собирать материалы и информацию из социальных сетей со всего Интернета. Это один из лучших парсеров, использующий обработку естественного языка для извлечения важных метаданных.

Инструменты и возможности:

- Он имеет встроенный полнотекстовый поиск на базе Kibana и Elasticsearch.

- Интегрированное удаление шаблонов и извлечение данных на основе методов поиска информации

- Он построен на отказоустойчивой инфраструктуре и гарантирует высокую доступность данных

- Удобная и универсальная консоль администратора

20) ФМайнер

FMiner — еще один известный инструмент веб-скрейпинга, который можно использовать для извлечения данных, сканирования, очистки экрана, макросов и веб-поддержки как в Windows, так и в Mac OS.

Инструменты и возможности:

- Использование простого визуального редактора для создания проекта извлечения данных

- Он помогает вам перемещаться по страницам веб-сайта, интегрируя структуры ссылок, раскрывающиеся коллекции и сопоставление шаблонов URL.

- Данные могут быть получены с динамических веб-сайтов Web 2.0, которые трудно сканировать.

- Это позволяет вам использовать сторонние автоматизированные службы декапчи или ручной ввод для проверки безопасности веб-сайта CAPTCHA.

ПОЧЕТНЫЕ ОТЗЫВЫ!

Теперь, когда мы закончили с 20 лучшими инструментами для веб-скрейпинга на февраль 2021 года, вот дополнительный список из 4 инструментов для веб-скрейпинга, которые, по нашему мнению, требуют почетного упоминания в этом посте. Эти инструменты также были признаны несколькими пользователями и критиками одними из лучших инструментов для очистки веб-страниц, которые вы можете использовать.

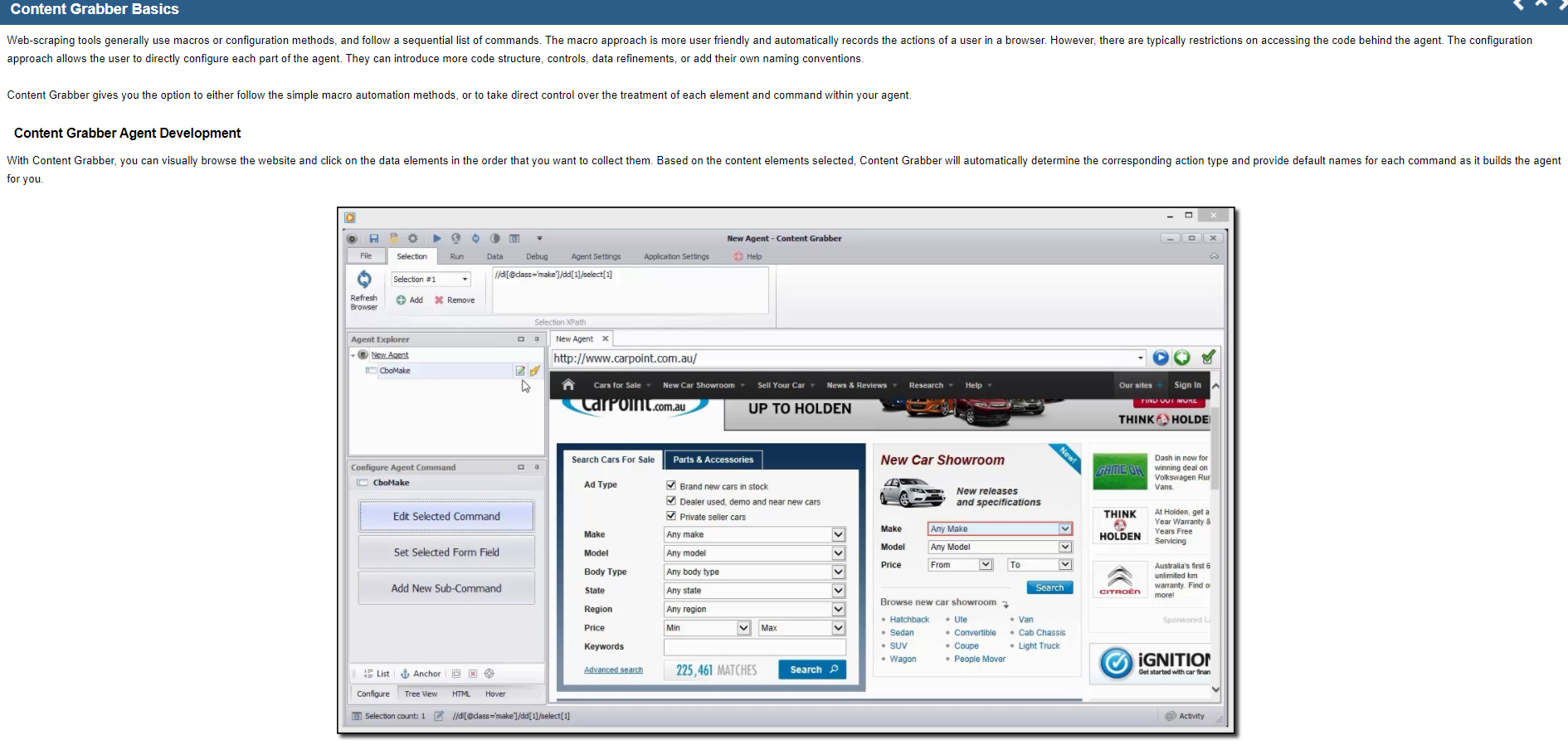

21) Захват контента

Контент-граббер — это надежное решение для обработки больших данных, предназначенное для извлечения веб-данных. Это поможет вам масштабировать вашу сеть, потому что это один из лучших парсеров. Эта платформа предлагает базовые функции, такие как визуальный редактор «наведи и щелкни».

Инструменты и возможности:

- Извлечение веб-данных быстрее, чем другие инструменты

- Помогает вам создавать веб-приложения с помощью специального веб-API, который позволяет вам выполнять веб-данные прямо с вашего веб-сайта.

- Помогает вам перемещаться между различными платформами

22) Zyte (ранее известный как ScrapingHub)

Zyte, ранее известный как Scraping Hub, представляет собой облачный инструмент для парсинга веб-страниц, который помогает разработчикам извлекать важные данные. Он превращает всю веб-страницу в хорошо организованный контент. Если их конструктор сканирования не удовлетворит ваши потребности, их профессиональная команда готова помочь вам. Стандартный бесплатный план позволяет запускать одно сканирование за раз, а премиальный план, который стоит 25 долларов в месяц, позволяет запускать до четырех сканирования одновременно.

Итак, какой из них ваш любимый инструмент для веб-скрейпинга? И какие данные вы хотите собрать из Интернета? Дайте нам знать в комментариях ниже и предложите любой другой хороший инструмент для веб-скрейпинга, который, по вашему мнению, должен быть в списке.

Почему вы должны использовать инструменты веб-скрейпинга?

Инструменты веб-скрейпинга могут оказаться полезными по безграничным причинам в различных сценариях.

Сбор информации для исследования рынка

Эти инструменты могут помочь вам быть в курсе того, куда движется ваша компания в ближайшие шесть месяцев, таким образом, выступая в качестве важного инструмента для исследования рынка. Эти инструменты могут получать данные от более чем одного поставщика аналитических данных и фирм, занимающихся исследованиями рынка, и объединять их в одном месте для удобства ссылок и анализа.

Извлечь контактную информацию

Эти инструменты можно даже использовать для получения информации, такой как электронные письма и контактные номера, с разных веб-сайтов, что позволяет составить список поставщиков, производителей и других лиц, представляющих интерес для вашего бизнеса, с их соответствующими контактными номерами и адресами.

Скачать решения из StackOverflow

С помощью инструмента веб-скрейпинга вы также можете загрузить некоторые решения для автономного чтения или хранения, собирая информацию с таких сайтов, как StackOverflow и многих других сайтов вопросов и ответов. Это приводит к снижению вашей зависимости от стабильного интернет-соединения, так как ресурсы быстро доступны, несмотря на доступность интернета.

Ищите кандидатов или работу

Для сотрудников, которые ищут кандидатов, чтобы объединиться со своей командой, или для тех, кто ищет работу, которые находят конкретную вакансию, эти инструменты отлично подходят для простого извлечения информации и данных на основе отдельных примененных фильтров и успешного извлечения данных без каких-либо ручных поисков.

Отслеживание цен в нескольких магазинах

Если вы заинтересованы в покупках в Интернете и хотели бы отслеживать текущую стоимость продуктов, которые вы ищете, на нескольких рынках, онлайн-сайтах и магазинах, то вам наверняка нужен инструмент для веб-скрейпинга.

Быстрые ссылки:

- Подробный обзор Debito :

- Гладкий Билл Обзор

- Обзор NetSuite:

Часто задаваемые вопросы (FAQ) о том, какой инструмент лучше всего подходит для парсинга веб-страниц?

Что подразумевается под веб-скрейпингом?

Если вам интересно, что такое парсинг данных? - Web Scraping (синоним парсинга данных) — это процедура извлечения и импорта данных с определенного сайта в электронную таблицу. Очистка данных помогает получать данные или информацию из Интернета, а затем передавать эти данные в вывод, который может быть прочитан людьми.

Для чего используется веб-скрейпинг?

Веб-скрейпинг очень полезен для исследования рынка, поиска потенциальных клиентов, сравнения продуктов, анализа контента, сравнения цен, сбора данных для бизнес-аналитики и т. д.

Какие все факторы я должен учитывать при выборе инструмента веб-скрейпинга?

Вы должны обратить внимание на факторы, перечисленные ниже, при выборе хорошего инструмента для парсинга веб-страниц: Он должен быть прост в использовании. Стоимость инструмента для парсинга веб-страниц. Функции и возможности. Производительность и скорость. Гибкость инструмента в соответствии с требованиями. Поддерживаемые форматы данных. Доступность службы поддержки

Заключение: инструменты веб-скрейпинга для извлечения данных в 2022 году

Веб-скрапинг может быть утомительным и сложным процессом. Есть много факторов, которые следует учитывать при принятии этого решения, но, в конце концов, вы должны выбрать тот инструмент, который лучше всего соответствует вашим потребностям! Bright Data избавил меня от всех этих хлопот, предоставив простой в использовании интерфейс для извлечения данных из разных источников в одну электронную таблицу, экономя часы каждую неделю или месяц по мере необходимости, не жертвуя точностью, еще раз спасибо их замечательной команде обслуживания клиентов, если что-либо когда-либо идет не так.