Что такое краулинговый бюджет [и как его оптимизировать]?

Опубликовано: 2022-05-16Краулинговый бюджет — это один из тех SEO-терминов, о которых вы, вероятно, слышали от маркетологов.

Однако знаете ли вы, что это значит и что это такое?

Не волнуйтесь, мы здесь не для того, чтобы проверять вас. Наоборот, мы здесь, чтобы помочь вам понять все о краулинговом бюджете, почему он важен и как вы можете его проверить и оптимизировать.

В конце концов, прежде чем ходить, нужно научиться ползать, верно?

Что такое краулинговый бюджет?

Бюджет сканирования — это количество страниц, которые Google может просканировать на веб-сайте в течение определенного периода времени.

Видите ли, каждый раз, когда вы публикуете страницу на своем веб-сайте, вам нужно ждать, пока Google проиндексирует и ранжирует ее, а чтобы сделать это, его роботы должны сначала ее просканировать.

Этот процесс может происходить быстрее или медленнее в зависимости от таких обстоятельств, как размер вашего веб-сайта, популярность тем, объем трафика на вашей странице и т. д.

Но как на самом деле работает сканирование?

Давай выясним.

Как работают сканеры?

Более 10 лет назад Google осознал, что у них ограниченные ресурсы, и они могли найти только ограниченный процент бесконечного онлайн-контента, который постоянно публикуется в Интернете.

Затем, в 2017 году, Google опубликовала официальную статью «Что значит краулинговый бюджет для робота Googlebot», в которой объяснила свое определение краулинга и другие важные детали.

Вот основные факты:

- Сканирование эффективно, если на вашем веб-сайте не более нескольких тысяч URL-адресов.

- Быстро отвечающие страницы увеличивают лимит сканирования

- Вы можете уменьшить скорость сканирования вашего сайта с помощью Google Search Console.

- Популярные URL сканируются чаще

- Обилие малоценных URL-адресов (дублированный контент, программные страницы с ошибками и т. д.) может негативно сказаться на индексации и сканировании.

- Сканирование не является прямым фактором ранжирования

По сути, чтобы обеспечить максимальную просматриваемость вашего веб-сайта, вам необходимо иметь быстрое время загрузки, избегать дублированного и некачественного контента и делать свои страницы популярными.

Однако важно отметить, что большинству владельцев веб-сайтов не нужно слишком беспокоиться о краулинговом бюджете. Стоит обратить внимание на большие веб-сайты с тысячами страниц, такие как магазины электронной коммерции, цифровые публикации и популярные блоги.

Почему важен краулинговый бюджет?

Бюджет сканирования очень важен для ваших усилий по SEO, особенно когда у вас тысячи страниц и вы постоянно публикуете много новых статей ежедневно. Боты захотят просканировать ваш новый контент, но одновременно они будут повторно посещать и остальную часть вашего сайта.

Если они столкнутся с многочисленными неудачами и/или проблемами, которые их смущают, они застрянут, тратя краулинговый бюджет на старые страницы, вместо того, чтобы инвестировать его в новый контент, который вы хотите, чтобы они проиндексировали. Это потенциально может создать задержки и временно (или даже навсегда) сделать ваши URL-адреса недоступными в поисковой выдаче.

Например, вы публикуете новости или информацию, которая важна для того, чтобы как можно быстрее привлечь к себе внимание.

Вы бы не хотели ждать неделю, пока ваш пост будет проиндексирован, не так ли?

В конце концов, вы не сможете попасть в поисковую выдачу, если ваша страница не проиндексирована. Допустим, вы пишете о мировом событии, которое произошло сегодня, но ваша страница просканирована через пять дней. В этот момент уже слишком поздно для достижения вашей первоначальной цели, так как событие уже не является актуальным и свежим. Не говоря уже о том, что множество других веб-сайтов написали об этом и вовремя проиндексировали.

Сканирующим ботам нередко требуется до недели, чтобы проиндексировать вашу страницу, но, честно говоря, это должно занять меньше времени.

Кроме того, тем временем вы будете продолжать публиковать новые страницы, которые необходимо своевременно сканировать, индексировать и предоставлять вашей целевой аудитории. И это рецепт узкого места индексации.

В общем, если вы часто достигаете пределов своего краулингового бюджета, вы рискуете, что некоторые из ваших страниц проскользнут между трещинами и не попадут в поисковую выдачу. В результате они не выиграют от органического трафика и будут иметь гораздо более низкую видимость, чем остальная часть вашего контента.

А если вам интересно, как проверить свой краулинговый бюджет — это просто. Просто зайдите в консоль поиска Google и выберите «Сканирование» → «Статистика сканирования».

Оптимизация краулингового бюджета

Важно помнить, что краулинговый бюджет зависит от трех основных факторов: размера сайта, состояния сайта и его популярности.

Это означает, что вам не нужно беспокоиться о краулинговом бюджете, если:

- Ваш веб-сайт умеренно мал, то есть содержит менее нескольких тысяч страниц.

- Ваш веб-сайт не содержит ошибок кода состояния и имеет надлежащую канонизацию.

- Ваш веб-сайт популярен, а это означает, что у вас есть подписчики в социальных сетях и другие каналы для обмена вашим контентом и создания трафика.

Соответствие этим критериям означает, что робот Googlebot сможет эффективно сканировать ваш веб-сайт.

Если у вас отсутствует какой-либо из этих трех факторов, существует риск того, что вы можете столкнуться с различными уровнями проблем со сканированием и потерять видимость в обычном поиске для некоторых ваших страниц.

Вот несколько рекомендаций по использованию краулингового бюджета:

Улучшите скорость вашего сайта

Как упоминалось выше, скорость веб-сайта и время загрузки страницы могут повлиять на ограничение сканирования. Исправный и быстрый веб-сайт означает, что робот Googlebot может сканировать больше ваших страниц за меньшее время.

С другой стороны, более медленная загрузка страниц снижает скорость сканирования, и на большом веб-сайте это может привести к общим проблемам с индексацией.

Короче говоря, обязательно оптимизируйте скорость вашего сайта. Это не только упростит работу ботов, но и улучшит пользовательский опыт.

Применить внутреннюю связь

В лучшем случае обратные ссылки должны указывать на каждую страницу вашего сайта. Это не только хорошая практика SEO для привлечения посетителей на ваш сайт и демонстрации поисковым системам важности вашего контента, но и для привлечения робота Googlebot.

Проще говоря, обратные ссылки — золотой мальчик SEO.

Но вот в чем дело.

Помимо обратных ссылок, Google также любит внутренние ссылки. Это помогает ему обнаружить все ваши страницы и лучше понять, как они связаны между собой. И хотя обратные ссылки может быть трудно найти, вы полностью контролируете внутренние и можете добавить столько, сколько хотите (только не переусердствуйте).

Применение этого метода оптимизации гарантирует, что больше ваших страниц будет просканировано.

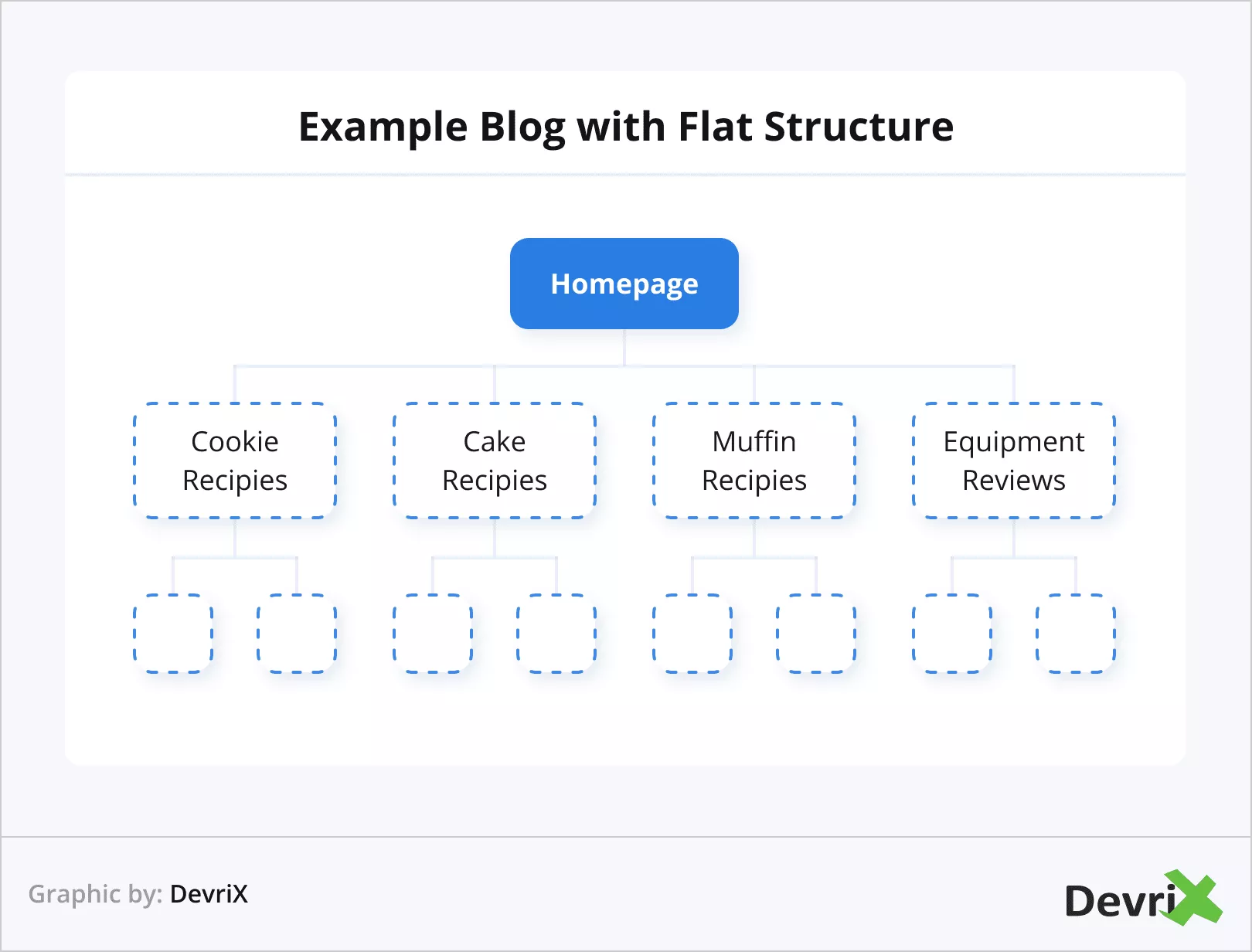

Используйте плоскую веб-архитектуру

Популярность очень важна в глазах Google. Вот почему было бы полезно использовать плоскую архитектуру веб-сайта. Плоская архитектура позволяет авторитету ссылок иметь равные пропорции на всех ваших страницах.

Это поможет ботам легче следить за тем, как связаны ссылки на вашем веб-сайте, а также позволит вам лучше группировать связанные страницы и получить авторитет по теме.

На практике это означает, что и пользователи, и поисковые системы могут попасть на любую страницу вашего сайта за четыре клика.

Избегайте страниц-сирот и дублированного контента

Потерянная страница — это та, которая не содержит ни одной внешней или внутренней ссылки. Это делает эти типы страниц изолированными от остального контента, и, по логике, роботу Googlebot их труднее обнаружить.

Вы можете легко избежать потерянных страниц, добавив хотя бы одну внутреннюю ссылку к каждой статье и странице, которые у вас есть.

Управление дублирующимся контентом

Дублированный контент вызывает множество проблем. Наличие нескольких URL-адресов с одинаковыми параметрами сбивает с толку ботов. Это приведет к пустой трате времени робота Googlebot, так как ему придется выяснять, какая страница является основной, а какая дублирующей версией, а это приведет к замедлению процесса сканирования.

Для таких сайтов, как платформы электронной коммерции, где обычно используется несколько похожих URL-адресов из-за нескольких похожих продуктов с небольшими различиями, такими как размер и цвет, обязательно используйте канонические теги, которые направят робота Googlebot на страницы, которым вы хотите отдать приоритет.

Запретить сканирование некоторых страниц

На каждом веб-сайте есть такие страницы, как вход в систему, контактные формы, корзины покупок и так далее. Их не нужно сканировать, и, кроме того, их нельзя сканировать. Тем не менее, Google попытается, поэтому рекомендуется сообщить ботам, что они должны пропускать их и экономить ресурсы.

Чтобы выполнить это действие, используйте файл robots.txt, чтобы запретить сканирование нужных страниц.

Обновите старый и напишите новый контент

Мы упоминали, что Google любит свежий контент? Оно делает.

Google может даже прекратить сканирование вашей страницы из-за того, что в последние несколько раз на ней не было ничего нового.

Представьте, робот Googlebot посещает ваш сайт раз в два дня и каждый раз находит новый контент для индексации. Затем вдруг по какой-то причине вы перестаете обновлять свой сайт. Однако робот Googlebot продолжает посещать его с той же частотой. Через некоторое время бот замечает, что нового контента для индексации нет, и, в конце концов, делает посещения реже.

В противоположном сценарии, когда вы начинаете чаще предоставлять свежий контент, робот Googlebot может начать чаще посещать ваш сайт.

Источник

Как правило, при определении того, какие страницы необходимо обновить, учитывайте актуальность — статья может быть двухлетней давности, и в ней все еще может быть актуальная информация (однако вам все равно следует ее обновить). Или это может быть материал месячной давности, который уже потерял свою свежесть.

Уменьшить количество страниц ошибок

Это просто понять.

Робот Googlebot тратит время, пытаясь просканировать страницы с кодами ошибок 5xx (ошибка сервера), кодами ошибок 4xx (ошибка не может быть найдена), кодами ошибок 3xx (перенаправления) и т. д., и в результате это снижает предел скорости сканирования.

Источник

По сути, каждая страница, которая приводит к коду, отличному от 200, — это пустая трата времени и ресурсов сканирования. На практике нет необходимости обращать внимание Google на страницы, которые вы удалили или перенаправили. Вместо этого отдайте приоритет исправлению активных URL-адресов.

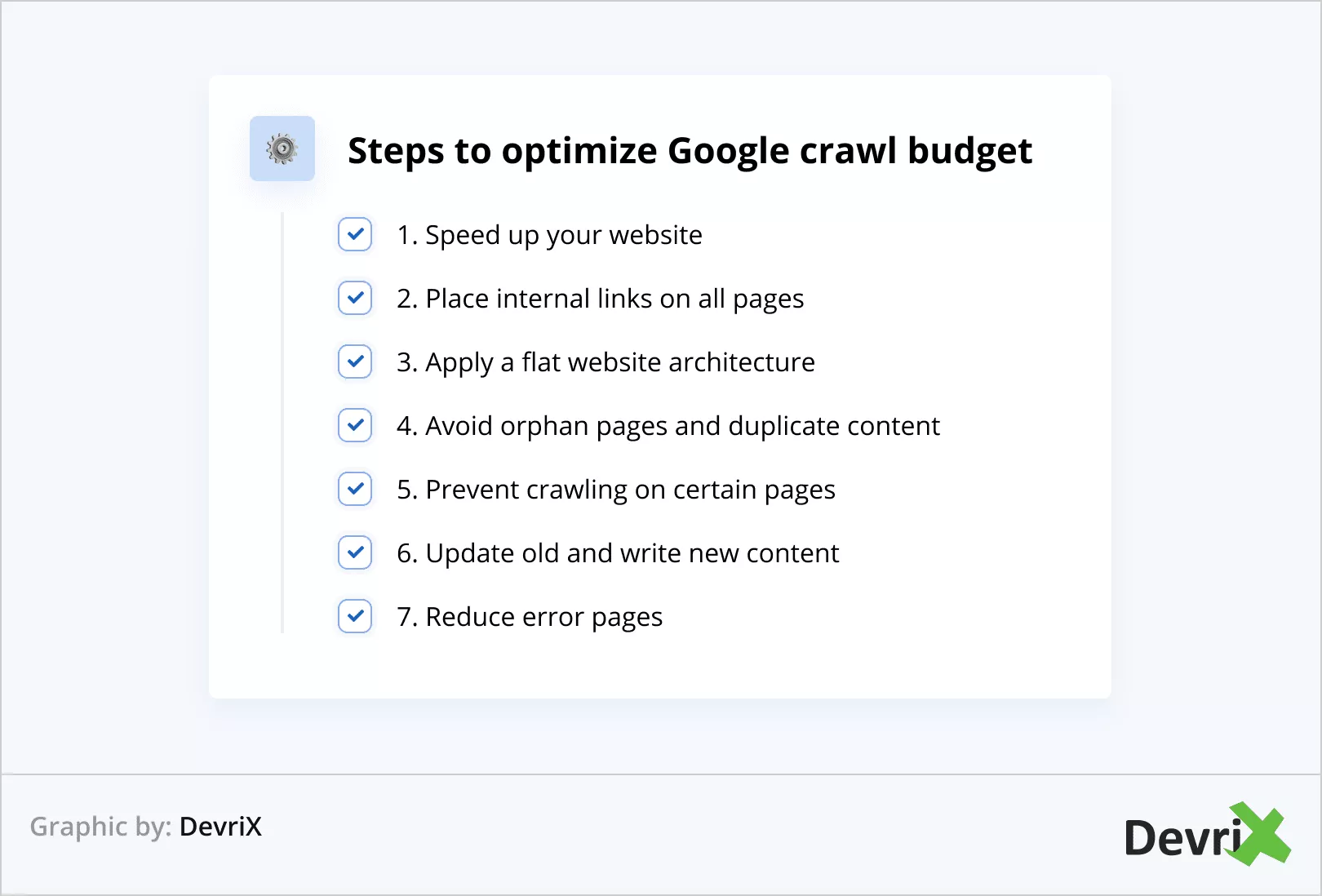

Коротко об оптимизации краулингового бюджета

Давайте повторим шаги по оптимизации краулингового бюджета Google:

- Ускорьте свой сайт

- Разместите внутренние ссылки на всех страницах

- Примените плоскую архитектуру веб-сайта

- Избегайте потерянных страниц и дублированного контента

- Запретить сканирование на определенных страницах

- Обновите старый и напишите новый контент

- Уменьшить количество страниц с ошибками

Бонусный совет

Вы можете проверить, как часто ваш веб-сайт сканируется, выполнив анализ файла журнала. Таким образом, вы можете определить, сканируются ли определенные страницы чаще, чем другие.

Кроме того, анализ файла журнала может помочь вам понять, есть ли проблемы в определенных областях веб-сайта.

Кроме того, анализ файла журнала может помочь вам понять, есть ли проблемы в определенных областях веб-сайта.

Нижняя линия

Краулинговый бюджет необходим для общей видимости вашего сайта в поисковых системах. Если робот Googlebot не может просканировать и проиндексировать ваши страницы, вы практически не существуете в сети.

Обязательно примените все методы оптимизации краулингового бюджета, которые мы обсуждали в статье, и вы пожнете плоды.

Google сможет быстрее находить и индексировать ваш контент, и, в конечном счете, ваш сайт будет впереди конкурентов, которые не смогли или пренебрегли оптимизацией.

1:0 для вас! Отличная работа!