วิธีปรับปรุงประสิทธิภาพการรวบรวมข้อมูลและการจัดทำดัชนีระดับองค์กร

เผยแพร่แล้ว: 2023-07-13Enterprise SEO เล่นตามกฎที่แตกต่างกัน

กลยุทธ์ที่อาจใช้ได้กับเว็บไซต์ขนาดเล็กหรือเฉพาะกลุ่มอาจไม่ได้ผลเสมอไป

แล้วจะเกิดอะไรขึ้นเมื่อ SEO ขององค์กรมี ขนาดใหญ่เกินไป

ในบทความนี้ ผมจะแบ่งปันสามตัวอย่างในชีวิตจริง จากนั้น คุณจะได้เรียนรู้ถึงยาแก้พิษที่เป็นไปได้สำหรับการจัดการ SEO ในวงกว้างอย่างมีประสิทธิภาพมากขึ้น

เผชิญกับภาวะที่กลืนไม่เข้าคายไม่ออกในการจัดทำดัชนี

ไซต์ขนาดเล็กมักจะขยายทีละหน้า โดยใช้คำหลักเป็นองค์ประกอบสำคัญของกลยุทธ์ SEO

ไซต์ขนาดใหญ่มักจะใช้วิธีการที่ซับซ้อนมากขึ้น โดยพึ่งพาระบบ กฎ และระบบอัตโนมัติเป็นอย่างมาก

การทำ SEO ให้สอดคล้องกับเป้าหมายทางธุรกิจเป็นสิ่งสำคัญ การวัดความสำเร็จของ SEO โดยพิจารณาจากการจัดอันดับคำหลักหรือการเข้าชมที่นำไปสู่ผลลัพธ์ด้านลบเนื่องจากการจัดทำดัชนีมากเกินไป

ไม่มีสูตรวิเศษที่จะกำหนดจำนวน URL ที่จัดทำดัชนีที่เหมาะสมที่สุด Google ไม่ได้กำหนดขีดจำกัดสูงสุด

อย่างไรก็ตาม จุดเริ่มต้นที่ดีคือการพิจารณาประสิทธิภาพโดยรวมของช่องทาง SEO หากเว็บไซต์…

- ส่ง URL หลายสิบ หรือ หลายร้อยล้านรายการ ไป ยัง Google

- จัดอันดับเพียงไม่ กี่ล้าน คำหลัก

- รับการเข้าชมไม่ กี่พัน หน้า

- แปลง เศษส่วน เหล่านี้ (ถ้ามีเลย)

…นั่นเป็นข้อบ่งชี้ที่ดีว่าคุณจำเป็นต้องตอบสนองความต้องการด้าน SEO ที่ร้ายแรงบางอย่าง

การแก้ไขปัญหาด้านสุขอนามัยของไซต์ตอนนี้ควรป้องกันปัญหา SEO ที่ใหญ่กว่าในภายหลัง

มาดูตัวอย่าง SEO สำหรับองค์กรในชีวิตจริงสามตัวอย่างที่แสดงให้เห็นว่าเหตุใดสิ่งนี้จึงสำคัญมาก

กรณีที่ 1: ผลที่ตามมาของการจัดทำดัชนีเนื้อหาคุณภาพต่ำมากเกินไป

Google มีทรัพยากรจำกัดสำหรับการรวบรวมข้อมูลและประมวลผลเว็บ พวกเขาจัดลำดับความสำคัญของเนื้อหาที่มีคุณค่าต่อผู้ใช้

Google อาจรวบรวมข้อมูลแต่ไม่จัดทำดัชนี หน้าเว็บที่พิจารณาว่าบาง ทำซ้ำ หรือมีคุณภาพต่ำ

หากเป็นเพียงไม่กี่หน้าก็ไม่เป็นปัญหา แต่หากแพร่หลาย Google อาจเพิกเฉยต่อหน้าเว็บทั้งประเภทหรือเนื้อหาส่วนใหญ่ของไซต์

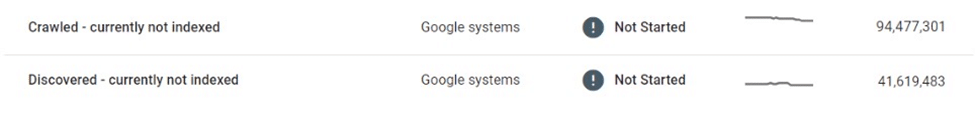

ในกรณีหนึ่ง ตลาดอีคอมเมิร์ซพบว่าหน้ารายชื่อนับสิบล้านหน้าได้รับผลกระทบจากการรวบรวมข้อมูลและการจัดทำดัชนีแบบเลือก

หลังจากรวบรวมข้อมูลหน้ารายชื่อที่บางและเกือบซ้ำกันหลายล้านหน้าและไม่ได้จัดทำดัชนี ในที่สุด Google ก็ลดขนาดการรวบรวมข้อมูลเว็บไซต์ทั้งหมด ทำให้หลายหน้าอยู่ในขอบเขตที่ “ค้นพบแล้ว – ยังไม่ได้จัดทำดัชนี”

ตลาดนี้พึ่งพาเครื่องมือค้นหาอย่างมากในการโปรโมตรายชื่อใหม่แก่ผู้ใช้ ไม่มีการค้นพบเนื้อหาใหม่อีกต่อไป ซึ่งเป็นความท้าทายทางธุรกิจที่สำคัญ

มีการใช้มาตรการบางอย่างในทันที เช่น การปรับปรุงการเชื่อมโยงภายในและการปรับใช้แผนผังไซต์ XML แบบไดนามิก ในที่สุด ความพยายามเหล่านี้ก็ไร้ผล

โซลูชันที่แท้จริงจำเป็นต้องควบคุมปริมาณและคุณภาพของเนื้อหาที่จัดทำดัชนีได้

กรณีที่ 2: ผลที่คาดไม่ถึงของการหยุดรวบรวมข้อมูล

เมื่อการรวบรวมข้อมูลหยุดลง เนื้อหาที่ไม่ต้องการจะยังคงอยู่ในดัชนีของ Google แม้ว่าจะมีการเปลี่ยนแปลง เปลี่ยนเส้นทาง หรือลบออกก็ตาม

เว็บไซต์จำนวนมากใช้การเปลี่ยนเส้นทางแทนข้อผิดพลาด 404 สำหรับเนื้อหาที่ถูกลบเพื่อรักษาสิทธิ์ กลยุทธ์นี้สามารถบีบปริมาณการเข้าชมเพิ่มเติมจากหน้าผีเป็นเวลาหลายเดือนหรือหลายปี

อย่างไรก็ตาม บางครั้งสิ่งนี้อาจผิดพลาดอย่างมหันต์

ตัวอย่างเช่น ตลาดกลางที่มีชื่อเสียงระดับโลกที่ขายสินค้าทำมือโดยไม่ได้ตั้งใจเปิดเผยข้อมูลส่วนตัวของผู้ขาย (เช่น ชื่อ ที่อยู่ อีเมล หมายเลขโทรศัพท์) ในหน้ารายการเวอร์ชันที่แปลเป็นภาษาท้องถิ่น หน้าเหล่านี้บางหน้าได้รับการจัดทำดัชนีและแคชโดย Google โดยแสดงข้อมูลส่วนบุคคลที่สามารถระบุตัวตนได้ (PII) ในผลการค้นหา ซึ่งส่งผลต่อความปลอดภัยและความเป็นส่วนตัวของผู้ใช้

เนื่องจาก Google ไม่ได้รวบรวมข้อมูลหน้าเหล่านี้ซ้ำ การลบหรืออัปเดตหน้าเหล่านี้จะไม่ลบออกจากดัชนี แม้หลายเดือนหลังจากการลบ เนื้อหาที่แคชและข้อมูล PII ของผู้ใช้ยังคงมีอยู่ในดัชนีของ Google

ในสถานการณ์เช่นนี้ Marketplace มีหน้าที่แก้ไขข้อบกพร่องและทำงานร่วมกับ Google โดยตรงเพื่อลบเนื้อหาที่ละเอียดอ่อนออกจาก Search

กรณีที่ 3: ความเสี่ยงของการจัดทำดัชนีหน้าผลการค้นหามากเกินไป

การจัดทำดัชนีที่ไม่มีการควบคุมของหน้าเว็บคุณภาพต่ำปริมาณมากอาจส่งผลย้อนกลับได้ แต่การจัดทำดัชนีหน้าผลการค้นหาจะเป็นอย่างไร

Google ไม่สนับสนุนการจัดทำดัชนีของผลการค้นหาภายใน และ SEO ที่มีประสบการณ์จำนวนมากจะแนะนำอย่างยิ่งว่าอย่าใช้กลยุทธ์นี้ อย่างไรก็ตาม ไซต์ขนาดใหญ่จำนวนมากพึ่งพาการค้นหาภายในเป็นอย่างมากในฐานะตัวขับเคลื่อน SEO หลัก ซึ่งมักให้ผลตอบแทนที่มาก

หากเมตริกการมีส่วนร่วมของผู้ใช้ ประสบการณ์การใช้งานหน้าเว็บ และคุณภาพเนื้อหาสูงพอ Google อาจเมินได้ อันที่จริง มีหลักฐานเพียงพอที่จะบ่งชี้ว่า Google อาจชอบหน้าผลการค้นหาภายในคุณภาพสูงมากกว่าหน้ารายการแบบบาง

อย่างไรก็ตาม กลยุทธ์นี้อาจผิดพลาดได้เช่นกัน

ครั้งหนึ่งฉันเคยเห็นเว็บไซต์ประมูลในท้องถิ่นสูญเสียส่วนสำคัญในการจัดอันดับหน้าการค้นหา และมากกว่าหนึ่งในสามของปริมาณการใช้ SEO ในชั่วข้ามคืน

กฎ 20/80 มีผลใช้บังคับในส่วนเล็กๆ ของคำนำสำหรับการเข้าชม SEO ส่วนใหญ่ไปยังผลการค้นหาที่จัดทำดัชนี อย่างไรก็ตาม มักจะเป็นหางยาวที่สร้างส่วนแบ่งสิงโตของปริมาณ URL และมีอัตราการแปลงที่สูงที่สุด

ผลที่ตามมาคือ เว็บไซต์ที่ใช้กลวิธีนี้ มีเพียงไม่กี่แห่งที่กำหนดข้อจำกัดหรือกฎตายตัวในการจัดทำดัชนีหน้าค้นหา

สิ่งนี้ก่อให้เกิดปัญหาใหญ่สองประการ:

- คำค้นหาใด ๆ สามารถสร้างหน้าที่ถูกต้องได้ ซึ่งหมายความว่าสามารถสร้างหน้าอัตโนมัติจำนวนไม่ จำกัด

- ทั้งหมดสามารถจัดทำดัชนีได้ใน Google

ในกรณีของตลาดโฆษณาย่อยที่สร้างรายได้จากหน้าการค้นหาด้วยโฆษณาของบุคคลที่สาม ช่องโหว่นี้ถูกใช้ประโยชน์อย่างดีผ่านรูปแบบของการเก็งกำไรจากโฆษณา:

- มีการสร้าง URL การค้นหาจำนวนมหาศาลสำหรับคำที่ไม่สุภาพ สำหรับผู้ใหญ่ และผิดกฎหมายโดยสิ้นเชิง

- แม้ว่าเพจที่สร้างขึ้นโดยอัตโนมัติเหล่านี้จะไม่แสดงผลลัพธ์คลังโฆษณาจริง แต่เพจเหล่านี้แสดงโฆษณาของบุคคลที่สาม และได้รับการปรับแต่งเพื่อจัดอันดับสำหรับคำค้นหาที่ร้องขอผ่านเทมเพลตเพจและข้อมูลเมตา

- ลิงก์ย้อนกลับถูกสร้างขึ้นไปยังหน้าเหล่านี้จากฟอรัมคุณภาพต่ำเพื่อให้บอทค้นพบและรวบรวมข้อมูล

- ผู้ใช้ที่มาถึงหน้าเหล่านี้จาก Google จะคลิกโฆษณาของบุคคลที่สามและไปยังไซต์คุณภาพต่ำซึ่งเป็นปลายทางที่ต้องการ

เมื่อถึงเวลาที่แผนถูกค้นพบ ชื่อเสียงโดยรวมของไซต์ได้รับความเสียหาย นอกจากนี้ยังโดนบทลงโทษหลายครั้งและทำให้ประสิทธิภาพ SEO ลดลงอย่างมาก

เปิดรับการจัดทำดัชนีที่มีการจัดการ

ปัญหาเหล่านี้จะหลีกเลี่ยงได้อย่างไร?

หนึ่งในวิธีที่ดีที่สุดสำหรับไซต์องค์กรขนาดใหญ่ที่จะเติบโตใน SEO คือการลดขนาดลงผ่านการจัดทำดัชนีที่มีการจัดการ

สำหรับไซต์ที่มีหน้าเว็บหลายสิบหรือหลายร้อยล้านหน้า สิ่งสำคัญคือต้องก้าวข้ามแนวทางที่เน้นคำหลักไปสู่แนวทางที่ขับเคลื่อนด้วยข้อมูล กฎ และระบบอัตโนมัติ

การจัดทำดัชนีที่ขับเคลื่อนด้วยข้อมูล

ข้อดีอย่างหนึ่งที่สำคัญของไซต์ขนาดใหญ่คือข้อมูลการค้นหาภายในที่มีอยู่อย่างมากมาย

แทนที่จะพึ่งพาเครื่องมือภายนอก พวกเขาสามารถใช้ข้อมูลนี้เพื่อทำความเข้าใจความต้องการและแนวโน้มการค้นหาระดับภูมิภาคและตามฤดูกาลในระดับที่ละเอียด

เมื่อแมปข้อมูลนี้กับคลังเนื้อหาที่มีอยู่แล้ว จะสามารถให้คำแนะนำที่ชัดเจนเกี่ยวกับเนื้อหาที่จะจัดทำดัชนี ตลอดจนเวลาและสถานที่ที่จะทำดัชนี

ลดความซ้ำซ้อนและรวมบัญชี

URL ที่เชื่อถือได้และมีอันดับสูงจำนวนน้อยมีค่ามากกว่าหน้าเว็บจำนวนมากที่กระจายอยู่ใน 100 อันดับแรก

การรวมหน้าที่คล้ายกันโดยใช้บัญญัติ การใช้ประโยชน์จากกฎและระบบอัตโนมัตินั้นคุ้มค่า บางหน้าอาจรวมเข้าด้วยกันตามคะแนนความคล้ายคลึงกัน ส่วนหน้าอื่นๆ จะรวมเข้าด้วยกันหากจัดลำดับสำหรับคำค้นหาที่คล้ายกัน

กุญแจที่นี่คือการทดลอง ปรับแต่งตรรกะและแก้ไขเกณฑ์เมื่อเวลาผ่านไป

ทำความสะอาดหน้าเนื้อหาที่บางและว่างเปล่า

เมื่อมีปริมาณมาก หน้ากระดาษที่บางและว่างเปล่าอาจทำให้สุขอนามัยและประสิทธิภาพของไซต์เสียหายอย่างมาก

หากการปรับปรุงด้วยเนื้อหาที่มีคุณค่าหรือการรวมเข้าด้วยกันนั้นยากเกินไป ก็ไม่ควรจัดทำดัชนีหรือแม้แต่ไม่ได้รับอนุญาต

ลดพื้นที่ไม่จำกัดด้วย robots.txt

สิบห้าปีหลังจากที่ Google เขียนเกี่ยวกับ "ช่องว่างที่ไม่มีที่สิ้นสุด" เป็นครั้งแรก ปัญหาของการสร้างดัชนีมากเกินไปของตัวกรอง การเรียงลำดับ และชุดค่าผสมอื่นๆ ยังคงสร้างปัญหาให้กับเว็บไซต์อีคอมเมิร์ซหลายแห่ง

ในกรณีร้ายแรง โปรแกรมรวบรวมข้อมูลอาจทำให้เซิร์ฟเวอร์ขัดข้องได้เนื่องจากพยายามหาทางผ่านลิงก์เหล่านี้ โชคดีที่สามารถแก้ไขได้อย่างง่ายดายผ่าน robots.txt

การแสดงผลฝั่งไคลเอนต์

การใช้การแสดงผลฝั่งไคลเอ็นต์สำหรับส่วนประกอบในหน้าบางอย่างที่คุณไม่ต้องการให้เครื่องมือค้นหาจัดทำดัชนี อาจเป็นตัวเลือก พิจารณาเรื่องนี้อย่างรอบคอบ

ยังดีกว่า ส่วนประกอบเหล่านี้ไม่ควรเข้าถึงได้สำหรับผู้ใช้ที่ออกจากระบบ

เงินเดิมพันเพิ่มขึ้นอย่างมากตามขนาดที่เพิ่มขึ้น

แม้ว่า SEO มักจะถูกมองว่าเป็นแหล่งที่มาของการเข้าชม "ฟรี" แต่ก็ค่อนข้างทำให้เข้าใจผิด การโฮสต์และให้บริการเนื้อหามีค่าใช้จ่าย

ค่าใช้จ่ายอาจเล็กน้อยต่อ URL แต่เมื่อขนาดถึงหลายร้อยล้านหรือพันล้านหน้า เพนนีจะเริ่มรวมกันเป็นจำนวนจริง

แม้ว่า ROI ของ SEO จะวัดได้ยาก แต่เงินที่ประหยัดได้ก็คือเงินที่เสียไป และการประหยัดต้นทุนผ่านการรวบรวมข้อมูลและการจัดทำดัชนีที่มีการจัดการควรเป็นปัจจัยหนึ่งเมื่อพิจารณากลยุทธ์การจัดทำดัชนีสำหรับไซต์ขนาดใหญ่

แนวทางการปฏิบัติจริงสำหรับ SEO ด้วยการรวบรวมข้อมูลและการจัดทำดัชนีที่มีการจัดการอย่างดี ซึ่งได้รับคำแนะนำจากข้อมูล กฎ และระบบอัตโนมัติ สามารถปกป้องเว็บไซต์ขนาดใหญ่จากความผิดพลาดที่มีค่าใช้จ่ายสูงได้

ความคิดเห็นที่แสดงในบทความนี้เป็นความคิดเห็นของผู้เขียนรับเชิญและไม่จำเป็นต้องเป็น Search Engine Land ผู้เขียนเจ้าหน้าที่อยู่ที่นี่