เทคนิคการขูดเว็บที่ดีที่สุด 7 อันดับแรก 2023: คู่มือปฏิบัติ

เผยแพร่แล้ว: 2023-03-08แหล่งข้อมูลที่ใหญ่ที่สุดในโลกน่าจะพบได้บนอินเทอร์เน็ต การรวบรวมและวิเคราะห์ข้อมูลจากเว็บไซต์มีแอปพลิเคชันที่มีศักยภาพมากมายในหลากหลายสาขา รวมถึงวิทยาศาสตร์ข้อมูล ข่าวกรององค์กร และการรายงานเชิงสืบสวน

นักวิทยาศาสตร์ข้อมูลกำลังมองหาข้อมูลและข้อมูลใหม่ ๆ เพื่อแก้ไขและวิเคราะห์อย่างต่อเนื่อง การขูดข้อมูลทางอินเทอร์เน็ตเพื่อหาข้อมูลเฉพาะเป็นหนึ่งในวิธีที่ได้รับความนิยมมากที่สุดในปัจจุบัน

คุณพร้อมสำหรับประสบการณ์การขูดเว็บครั้งแรกของคุณหรือยัง? แต่ก่อนอื่น คุณต้องเข้าใจว่าการขูดเว็บจริง ๆ คืออะไรและพื้นฐานบางประการ จากนั้นเราจะพูดถึงเทคนิคการขูดเว็บที่ดีที่สุด

สารบัญ

การขูดเว็บคืออะไร?

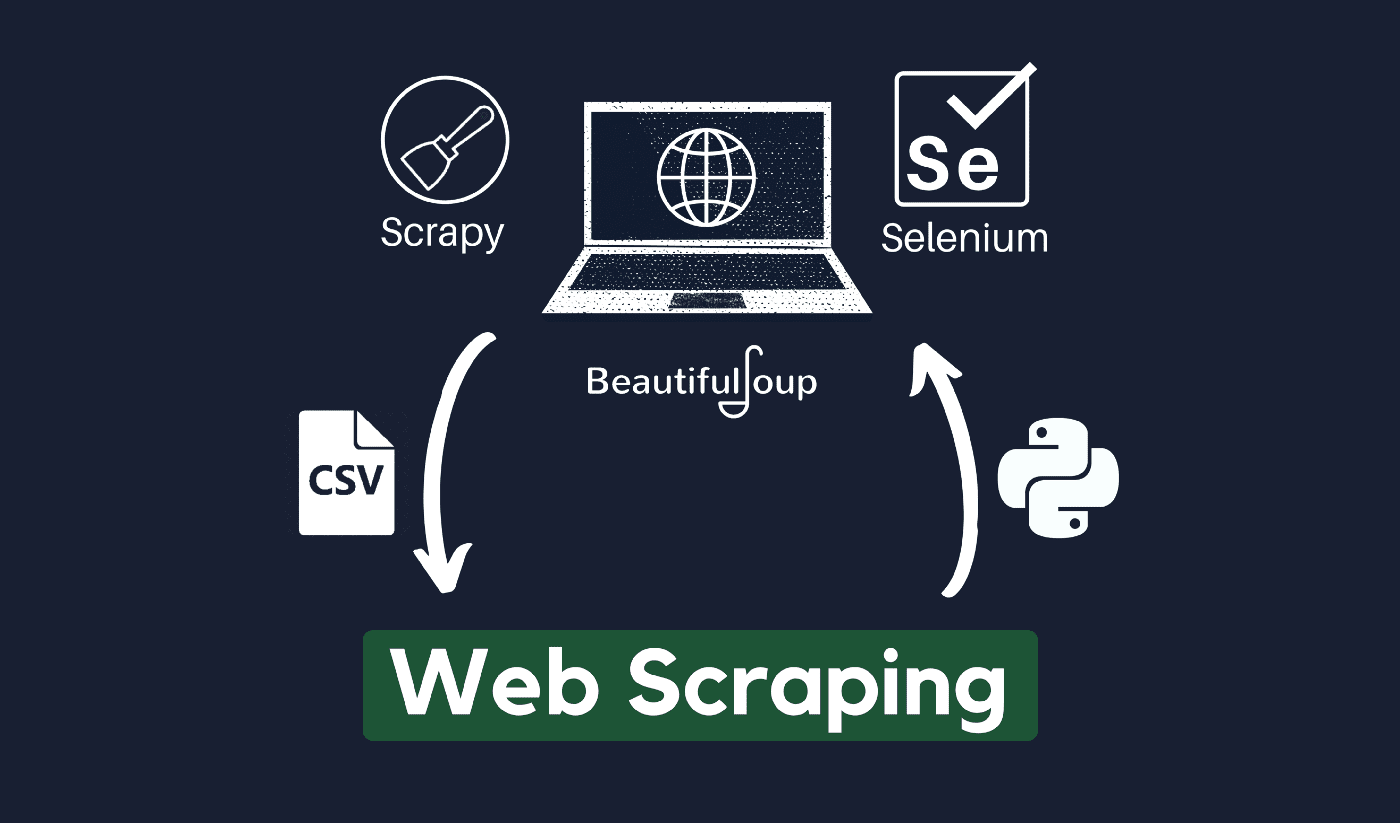

เทคนิคการรวบรวมและประมวลผลข้อมูลดิบจากเว็บเรียกว่าการขูดเว็บ และชุมชน Python ได้พัฒนาเครื่องมือขูดเว็บที่ค่อนข้างทรงพลัง ไปป์ไลน์ข้อมูลใช้เพื่อประมวลผลและจัดเก็บข้อมูลนี้ในลักษณะที่มีโครงสร้าง

การขูดเว็บเป็นวิธีปฏิบัติทั่วไปในปัจจุบันโดยมีแอปพลิเคชันมากมาย:

- ธุรกิจการตลาดและการขายสามารถรวบรวมข้อมูลที่เกี่ยวข้องกับลูกค้าเป้าหมายได้โดยใช้การขูดเว็บ

- บริษัทอสังหาริมทรัพย์สามารถรับข้อมูลเกี่ยวกับการพัฒนาใหม่ อสังหาริมทรัพย์สำหรับขาย ฯลฯ โดยใช้การขูดเว็บ

- เว็บไซต์เปรียบเทียบราคาเช่น Trivago มักใช้การขูดเว็บเพื่อรับข้อมูลผลิตภัณฑ์และราคาจากเว็บไซต์อีคอมเมิร์ซต่างๆ

คุณสามารถขูดเว็บโดยใช้ภาษาโปรแกรมต่างๆ ได้ และแต่ละภาษาโปรแกรมมีไลบรารีต่างๆ มากมายที่สามารถช่วยให้คุณทำสิ่งเดียวกันได้สำเร็จ หนึ่งในโปรแกรมยอดนิยม เชื่อถือได้ และถูกกฎหมายที่ใช้สำหรับการขูดเว็บอย่างมีประสิทธิภาพคือ Python

เกี่ยวกับไพธอน

Python เป็นภาษาที่นิยมมากที่สุดสำหรับการสแครปที่พัฒนาและเปิดตัวในปี 1991 ภาษาโปรแกรมนี้มักใช้ในการสร้างเว็บไซต์ เขียนโค้ด สร้างซอฟต์แวร์ สร้างสคริปต์ระบบ และอื่นๆ โปรแกรมนี้เป็นรากฐานที่สำคัญของภาคออนไลน์และใช้กันอย่างแพร่หลายในการค้าทั่วโลก

สามารถพัฒนาเว็บแอปพลิเคชันบนเซิร์ฟเวอร์โดยใช้ Python สามารถใช้ร่วมกับแอพพลิเคชั่นเพื่อสร้างกระบวนการและเชื่อมโยงกับระบบฐานข้อมูล ไฟล์สามารถอ่านและเปลี่ยนแปลงได้ด้วย

นอกจากนี้ยังสามารถใช้ในการจัดการข้อมูลจำนวนมหาศาล ดำเนินการทางคณิตศาสตร์ที่ซับซ้อน เร่งกระบวนการต้นแบบ หรือสร้างซอฟต์แวร์ที่พร้อมสำหรับการผลิต

คุณจะใช้ Python สำหรับการขูดเว็บได้อย่างไร

คุณอาจต้องผ่านสามขั้นตอนเพื่อขูดและแยกข้อมูลใดๆ จากอินเทอร์เน็ต: รับ HTML, รับโครงสร้าง HTML และสุดท้ายแยกข้อมูลจากโครงสร้าง

เป็นไปได้ที่จะดึงรหัส HTML จากไซต์ที่กำหนดโดยใช้ไลบรารีคำขอ ต้นไม้ HTML จะถูกแยกวิเคราะห์และแยกโดยใช้ BeautifulSoup จากนั้นข้อมูลอาจถูกจัดระเบียบโดยใช้ Python เท่านั้น

ขอแนะนำให้ตรวจสอบนโยบายการใช้งานที่ยอมรับได้ของเว็บไซต์เป้าหมายเสมอ เพื่อดูว่าการเข้าถึงเว็บไซต์โดยใช้เครื่องมืออัตโนมัติเป็นการละเมิดเงื่อนไขการใช้งานหรือไม่ ก่อนที่จะใช้ความสามารถของ Python ในการขูดเว็บ

การขูดเว็บทำงานอย่างไร

โดยทั่วไปแล้วแมงมุมจะใช้ในกระบวนการขูดออนไลน์ พวกเขาดึงเอกสาร HTML จากเว็บไซต์ที่เกี่ยวข้อง แยกเนื้อหาที่จำเป็นตามตรรกะทางธุรกิจ แล้วจัดเก็บไว้ในรูปแบบที่กำหนด

เว็บไซต์นี้ทำหน้าที่เป็นแนวทางสำหรับการสร้างตัวขูดที่ปรับขนาดได้สูง

เฟรมเวิร์กและวิธีการของ Python ที่รวมกับส่วนย่อยของโค้ดบางส่วนสามารถใช้เพื่อขูดข้อมูลด้วยวิธีที่ตรงไปตรงมาได้หลายวิธี มีคำแนะนำมากมายที่อาจช่วยให้คุณนำไปปฏิบัติได้

การคัดลอกหน้าเดียวเป็นเรื่องง่าย แต่การจัดการโค้ดสไปเดอร์ การรวบรวมข้อมูล และการบำรุงรักษาคลังข้อมูลเป็นเรื่องยากเมื่อคัดลอกหน้าหลายล้านหน้า เพื่อให้การขูดง่ายและแม่นยำ เราจะตรวจสอบปัญหาเหล่านี้และวิธีแก้ไข

ลิงค์ด่วน:

- รีวิว Shiftproxy

- พร็อกซีเซิร์ฟเวอร์คืออะไร

- ทางเลือก SmartProxy 3 อันดับแรก

**คำแนะนำเพิ่มเติม: ใช้ IP หมุนเวียนและบริการพร็อกซี

เมื่อคุณเห็นภาพชัดเจนแล้ว การขูดเว็บจะช่วยให้คุณสามารถรวบรวมข้อมูลจากเว็บโดยใช้ชุดคำสั่งในการเขียนโปรแกรม แต่อย่างที่คุณต้องระวัง กิจกรรมการขูดเว็บของคุณสามารถตรวจสอบได้ผ่านที่อยู่ IP ของคุณ

สิ่งนี้จะไม่เป็นปัญหามากนักหากข้อมูลที่คุณกำลังคัดลอกมาจากสาธารณสมบัติ แต่ถ้าคุณกำลังขูดข้อมูลส่วนตัวจากไซต์สื่อพิเศษ คุณอาจพบปัญหาหากที่อยู่ IP ของคุณถูกติดตาม

ดังนั้น โดยพื้นฐานแล้ว เพื่อป้องกันไม่ให้สไปเดอร์ของคุณถูกขึ้นบัญชีดำ คุณควรใช้บริการพร็อกซีและเปลี่ยนที่อยู่ IP เสมอ

เราไม่สนับสนุนให้คุณใช้การขูดเว็บเพื่อรวบรวมข้อมูลที่ผิดกฎหมายหรือเป็นส่วนตัว หรือหลงระเริงในกิจกรรมสปายแวร์ที่เป็นอันตราย

แต่ถ้าคุณกำลังรวบรวมข้อมูลที่อาจเป็นส่วนตัว ขอแนะนำให้ปกปิดหรือหมุนที่อยู่ IP ของคุณหรือใช้พร็อกซีเซิร์ฟเวอร์เพื่อหลีกเลี่ยงการติดตาม

คุณอาจต้องการอ่าน:

- รีวิว Octoparse

- เครื่องขูด Reddit ที่ดีที่สุด

- 12 พร็อกซีการขูดเว็บที่ดีที่สุด

การขูดเว็บถูกกฎหมายหรือไม่?

อย่างเป็นทางการไม่มีระบุไว้ในบรรทัดฐานและหลักเกณฑ์ทางอินเทอร์เน็ตว่าการขูดเว็บเป็นสิ่งผิดกฎหมาย พูดตามตรง การขูดเว็บเป็นสิ่งที่ถูกกฎหมายโดยสิ้นเชิง หากคุณกำลังทำงานกับข้อมูลสาธารณะ

ปลายเดือนมกราคม 2020 มีการประกาศว่าอนุญาตให้คัดลอกข้อมูลที่เปิดเผยต่อสาธารณะเพื่อวัตถุประสงค์ที่ไม่ใช่เชิงพาณิชย์โดยสิ้นเชิง

ข้อมูลที่ประชาชนทั่วไปสามารถเข้าถึงได้โดยเสรีคือข้อมูลที่ทุกคนสามารถเข้าถึงได้ทางออนไลน์โดยไม่ต้องใช้รหัสผ่านหรือการพิสูจน์ตัวตนอื่นๆ ดังนั้น ข้อมูลที่เปิดเผยต่อสาธารณะจึงรวมถึงข้อมูลที่อาจพบได้ในวิกิพีเดีย โซเชียลมีเดีย หรือผลการค้นหาของ Google

อย่างไรก็ตาม บางเว็บไซต์ห้ามไม่ให้ผู้ใช้คัดลอกข้อมูลด้วยการขูดเว็บอย่างชัดเจน การขูดข้อมูลจากโซเชียลมีเดียบางครั้งถือว่าผิดกฎหมาย

เหตุผลนี้คือบางส่วนไม่สามารถเข้าถึงได้โดยบุคคลทั่วไป เช่น เมื่อผู้ใช้ตั้งค่าข้อมูลเป็นส่วนตัว ในกรณีนี้ ห้ามคัดลอกข้อมูลนี้ การคัดลอกข้อมูลจากเว็บไซต์โดยไม่ได้รับความยินยอมจากเจ้าของอาจถือเป็นอันตรายได้เช่นกัน

รับประโยชน์สูงสุดจากเว็บผ่าน Web Scraping!

การรวบรวมและวิเคราะห์ข้อมูลจากเว็บไซต์มีแอปพลิเคชันที่มีศักยภาพมากมายในหลากหลายสาขา รวมถึงวิทยาศาสตร์ข้อมูล ข่าวกรองขององค์กร และการรายงานเชิงสืบสวน

หนึ่งในความสามารถพื้นฐานที่นักวิทยาศาสตร์ข้อมูลต้องการคือการขูดเว็บ

โปรดทราบว่าไม่ใช่ทุกคนที่ต้องการให้คุณเข้าถึงเว็บเซิร์ฟเวอร์เพื่อหาข้อมูล ก่อนเริ่มขูดเว็บไซต์ ตรวจสอบให้แน่ใจว่าคุณได้อ่านเงื่อนไขการใช้งานแล้ว นอกจากนี้ โปรดคำนึงถึงเวลาในการค้นหาเว็บของคุณเพื่อหลีกเลี่ยงการล้นเซิร์ฟเวอร์

ลิงค์ด่วน

- ผู้รับมอบฉันทะที่ดีที่สุดสำหรับการรวมค่าโดยสาร

- พร็อกซีฝรั่งเศสที่ดีที่สุด

- ผู้รับมอบฉันทะของ Tripadvisor ที่ดีที่สุด

- พร็อกซี Etsy ที่ดีที่สุด

- รหัสคูปอง IPRoyal

- พร็อกซี่ TikTok ที่ดีที่สุด

- พร็อกซี่ที่ใช้ร่วมกันที่ดีที่สุด

- พร็อกซีเยอรมนีที่ดีที่สุด