Kurumsal düzeyde tarama ve dizin oluşturma verimliliği nasıl geliştirilir?

Yayınlanan: 2023-07-13Kurumsal SEO farklı kurallara göre oynar.

Küçük veya niş web siteleri için işe yarayabilecek stratejiler, her zaman geniş ölçekte çalışmayabilir.

Kurumsal SEO çok büyüdüğünde tam olarak ne olabilir?

Bu yazıda, gerçek hayattan üç örnek paylaşacağım. Ardından, geniş ölçekte daha verimli SEO yönetimi için potansiyel bir panzehir öğreneceksiniz.

İndeksleme ikilemiyle yüzleşmek

Küçük siteler, bir SEO stratejisinin yapı taşları olarak anahtar kelimeleri kullanarak her seferinde bir sayfa büyütme eğilimindedir.

Büyük siteler genellikle sistemlere, kurallara ve otomasyona dayanan daha karmaşık yaklaşımları benimser.

SEO'yu iş hedefleriyle uyumlu hale getirmek çok önemlidir. SEO başarısını anahtar kelime sıralamasına veya trafiğe göre ölçmek, aşırı indeksleme nedeniyle olumsuz sonuçlara yol açar.

Dizine eklenmiş URL'lerin optimal sayısını belirlemek için sihirli bir formül yoktur. Google bir üst sınır belirlemez.

Bununla birlikte, iyi bir başlangıç noktası, SEO dönüşüm hunisinin genel durumunu göz önünde bulundurmaktır. Eğer bir site…

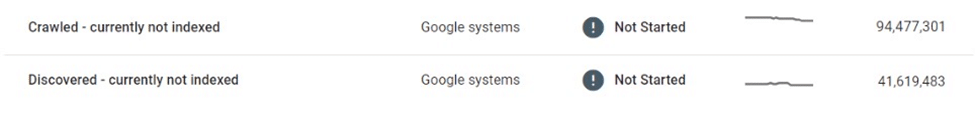

- Onlarca veya yüz milyonlarca , hatta milyarlarca URL'yi Google'a aktarır

- Yalnızca birkaç milyon anahtar kelime için sıralanır

- Birkaç bin sayfaya ziyaret alır

- Bunların bir kısmını dönüştürür (eğer varsa)

…o zaman bazı ciddi SEO sağlık ihtiyaçlarını karşılamanız gerektiğinin iyi bir göstergesidir.

Herhangi bir site hijyen sorununu şimdi düzeltmek, daha sonra daha büyük SEO sorunlarını önlemelidir.

Bunun neden bu kadar önemli olduğunu gösteren üç gerçek hayattan kurumsal SEO örneğine bakalım.

Durum 1: Düşük kaliteli içeriğin aşırı dizine eklenmesinin sonuçları

Google'ın web taraması ve işlemesi için sınırlı kaynakları vardır. Kullanıcılar için değerli olan içeriğe öncelik verirler.

Google ince, yinelenen veya düşük kaliteli olduğunu düşündüğü sayfaları tarayabilir ancak dizine ekleyemez.

Sadece birkaç sayfa ise, sorun değil. Ancak yaygınsa, Google tüm sayfa türlerini veya site içeriğinin çoğunu yok sayabilir.

Bir örnekte, bir e-ticaret pazarı, listeleme sayfalarının on milyonlarcasının seçici tarama ve dizine eklemeden etkilendiğini tespit etti.

Milyonlarca ince, neredeyse yinelenen listeleme sayfasını taradıktan ve bunları dizine eklemedikten sonra, Google sonunda web sitesini tamamen taramaya geri döndü ve birçoğunu "Keşfedildi - şu anda dizine eklenmemiş" belirsizlikte bıraktı.

Bu pazar, kullanıcılara yeni listeleri tanıtmak için büyük ölçüde arama motorlarına güvendi. Artık yeni içerik keşfedilmiyordu ve bu da önemli bir ticari zorluk oluşturuyordu.

Dahili bağlantıların iyileştirilmesi ve dinamik XML site haritalarının konuşlandırılması gibi bazı acil önlemler alındı. Sonuçta, bu girişimler boşunaydı.

Gerçek çözüm, dizine eklenebilir içeriğin hacmini ve kalitesini kontrol etmeyi gerektiriyordu.

Durum 2: Sürünmenin durmasının öngörülemeyen sonuçları

Tarama durduğunda, istenmeyen içerik değiştirilse, yönlendirilse veya silinse bile Google'ın dizininde kalır.

Birçok web sitesi, otoriteyi korumak için kaldırılan içerik için 404 hatası yerine yönlendirmeler kullanır. Bu taktik, hayalet sayfalardan gelen trafiği aylarca, hatta yıllarca sıkıştırabilir.

Ancak, bu bazen çok yanlış gidebilir.

Örneğin, el yapımı ürünler satan tanınmış bir küresel pazar yeri, satıcıların özel bilgilerini (ör. ad, adres, e-posta, telefon numarası) listeleme sayfalarının yerelleştirilmiş sürümlerinde yanlışlıkla ifşa etti. Bu sayfalardan bazıları Google tarafından dizine eklendi ve önbelleğe alındı, arama sonuçlarında Kişisel Olarak Tanımlanabilir Bilgileri (PII) görüntüleyerek kullanıcı güvenliği ve gizliliğini tehlikeye attı.

Google bu sayfaları yeniden taramadığından, bunların kaldırılması veya güncellenmesi onları dizinden çıkarmaz. Silme işleminden aylar sonra bile, önbelleğe alınan içerik ve kullanıcı PII verileri Google'ın dizininde bulunmaya devam etti.

Böyle bir durumda hataları düzeltmek ve hassas içeriği Arama'dan kaldırmak için doğrudan Google ile çalışmak pazarın sorumluluğundaydı.

Durum 3: Arama sonuçları sayfalarını aşırı dizine eklemenin riskleri

Büyük hacimli ince, düşük kaliteli sayfaların kontrolsüz dizine eklenmesi ters tepebilir - peki ya arama sonucu sayfalarını dizine ekleme?

Google, dahili arama sonuçlarının dizine eklenmesini onaylamaz ve deneyimli birçok SEO uzmanı bu taktiğe karşı şiddetle tavsiyede bulunur. Bununla birlikte, birçok büyük site, başlıca SEO sürücüsü olarak, genellikle önemli getiriler sağlayan dahili aramaya ağırlık vermiştir.

Kullanıcı etkileşimi metrikleri, sayfa deneyimi ve içerik kalitesi yeterince yüksekse, Google görmezden gelebilir. Aslında, Google'ın yüksek kaliteli bir dahili arama sonuç sayfasını ince bir listeleme sayfasına bile tercih edebileceğini önermek için yeterli kanıt vardır.

Ancak bu strateji yanlış da gidebilir.

Bir keresinde yerel bir açık artırma sitesinin arama sayfası sıralamalarının önemli bir bölümünü ve SEO trafiğinin üçte birinden fazlasını bir gecede kaybettiğini gördüm.

20/80 kuralı, ana terimlerin küçük bir kısmının indekslenmiş arama sonuçlarına yapılan çoğu SEO ziyaretini hesaba katması bakımından geçerlidir. Bununla birlikte, URL hacminde aslan payını oluşturan ve en yüksek dönüşüm oranlarından bazılarına sahip olan genellikle uzun kuyruktur.

Sonuç olarak, bu taktiği kullanan sitelerin çok azı, arama sayfalarının dizine eklenmesi konusunda katı sınırlar veya kurallar uygulamaktadır.

Bu iki önemli sorun ortaya çıkarır:

- Herhangi bir arama sorgusu geçerli bir sayfa oluşturabilir, bu da sonsuz sayıda sayfanın otomatik olarak oluşturulabileceği anlamına gelir.

- Hepsi Google'da indekslenebilir.

Arama sayfalarından üçüncü taraf reklamlarla para kazanan sınıflandırılmış bir pazar durumunda, bu güvenlik açığı bir tür reklam hakemliği yoluyla iyi bir şekilde istismar edildi:

- Gölgeli, yetişkinlere uygun ve tamamen yasa dışı terimler için çok sayıda arama URL'si oluşturuldu.

- Otomatik olarak oluşturulan bu sayfalar gerçek bir envanter sonucu döndürmese de, üçüncü taraf reklamları sundular ve sayfa şablonu ve meta veriler aracılığıyla istenen arama sorguları için sıralanacak şekilde optimize edildiler.

- Düşük kaliteli forumlardan bu sayfalara, botlar tarafından keşfedilmelerini ve taranmalarını sağlamak için geri bağlantılar oluşturuldu.

- Google'dan bu sayfalara gelen kullanıcılar, üçüncü taraf reklamlarına tıklar ve amaçlanan hedef olan düşük kaliteli sitelere giderdi.

Düzen keşfedildiğinde, sitenin genel itibarı zarar görmüştü. Ayrıca birkaç ceza aldı ve SEO performansında büyük düşüşler yaşadı.

Yönetilen indekslemeyi benimsemek

Bu sorunlar nasıl önlenebilirdi?

Büyük kurumsal sitelerin SEO'da başarılı olmasının en iyi yollarından biri, yönetilen indeksleme yoluyla ölçeği küçültmektir.

Onlarca veya yüz milyonlarca sayfadan oluşan bir site için, anahtar kelime odaklı bir yaklaşımın ötesine geçerek veriler, kurallar ve otomasyon tarafından yönlendirilen bir yaklaşıma geçmek çok önemlidir.

Veriye dayalı indeksleme

Büyük sitelerin önemli bir avantajı, ellerinde bulunan dahili arama verilerinin zenginliğidir.

Harici araçlara güvenmek yerine, bölgesel ve sezonluk arama talebini ve trendlerini ayrıntılı bir şekilde anlamak için bu verileri kullanabilirler.

Bu veriler, mevcut içerik envanteriyle eşleştirildiğinde, hangi içeriğin dizine ekleneceği ve bunun ne zaman ve nerede yapılacağı konusunda sağlam bir kılavuz sağlayabilir.

Tekilleştirme ve birleştirme

Az sayıda yetkili, üst düzey URL, ilk 100'e dağılmış çok sayıda sayfadan çok daha değerlidir.

Bunu yapmak için standartlar kullanarak, kurallardan ve otomasyondan yararlanarak benzer sayfaları birleştirmek faydalı olacaktır. Bazı sayfalar benzerlik puanlarına göre birleştirilebilir, diğerleri ise benzer sorgular için toplu olarak sıralanırsa bir araya kümelenebilir.

Buradaki anahtar deneydir. Mantığı değiştirin ve eşikleri zaman içinde gözden geçirin.

İnce ve boş içerik sayfalarını temizleyin

İnce ve boş sayfalar, çok büyük hacimlerde bulunduklarında site hijyenine ve performansına önemli ölçüde zarar verebilir.

Bunları değerli içerikle geliştirmek veya birleştirmek çok zorsa, o zaman endekslenmemeli ve hatta izin verilmemelidir.

robots.txt ile sonsuz boşlukları azaltın

Google'ın "sonsuz alanlar" hakkında ilk kez yazmasından on beş yıl sonra, filtrelerin aşırı dizine eklenmesi, sıralama ve diğer parametre kombinasyonları birçok e-ticaret sitesini rahatsız etmeye devam ediyor.

Aşırı durumlarda, tarayıcılar bu bağlantılardan geçmeye çalışırken sunucuları çökertebilir. Neyse ki, bu sorun robots.txt aracılığıyla kolayca çözülebilir.

İstemci tarafı oluşturma

Arama motorları tarafından dizine eklenmesini istemediğiniz belirli sayfa bileşenleri için istemci tarafı oluşturmayı kullanmak bir seçenek olabilir. Bunu dikkatlice düşünün.

Daha da iyisi, oturumu kapatmış kullanıcılar için bu bileşenlere erişilemez olmalıdır.

Ölçek arttıkça bahisler önemli ölçüde artar

SEO genellikle “ücretsiz” bir trafik kaynağı olarak algılansa da, bu biraz yanıltıcıdır. İçeriği barındırmak ve sunmak maliyetlidir.

URL başına maliyetler önemsiz olabilir, ancak ölçek yüz milyonlarca veya milyarlarca sayfaya ulaştığında, kuruşlar gerçek sayılara ulaşmaya başlar.

SEO'nun yatırım getirisini ölçmek zor olsa da, tasarruf edilen bir kuruş, kazanılan bir kuruştur ve büyük siteler için indeksleme stratejileri düşünülürken, yönetilen tarama ve indeksleme yoluyla maliyet tasarrufu bir faktör olmalıdır.

Veriler, kurallar ve otomasyon tarafından yönlendirilen, iyi yönetilen tarama ve indeksleme ile SEO'ya yönelik pragmatik bir yaklaşım, büyük web sitelerini maliyetli hatalardan koruyabilir.

Bu makalede ifade edilen görüşler konuk yazara aittir ve mutlaka Search Engine Land değildir. Personel yazarları burada listelenir.