LLM'lere güvenmek nasıl SEO felaketine yol açabilir?

Yayınlanan: 2023-07-10"ChatGPT çıtayı geçebilir."

"GPT tüm sınavlardan A+ alır."

"GPT, MIT giriş sınavını büyük bir başarı ile geçti."

Son zamanlarda kaçınız yukarıdakine benzer bir iddiada bulunan makaleler okudunuz?

Bunlardan bir ton gördüğümü biliyorum. Görünüşe göre her gün GPT'nin neredeyse Skynet olduğunu, yapay genel zekaya yakın veya insanlardan daha iyi olduğunu iddia eden yeni bir ileti dizisi var.

Geçenlerde bana şu soru soruldu: "ChatGPT neden kelime sayımı girdiğime uymuyor? Bu bir bilgisayar, değil mi? Akıl yürütme motoru mu? Elbette bir paragraftaki kelime sayısını sayabilmelidir.”

Bu, büyük dil modellerinde (LLM'ler) ortaya çıkan bir yanlış anlamadır.

Bir dereceye kadar, ChatGPT gibi araçların biçimi işlevi yalanlıyor.

Arayüz ve sunum, konuşabilen bir robot ortağınınkidir - kısmen yapay zeka arkadaşı, kısmen arama motoru, parça hesaplayıcı - tüm sohbet robotlarını sonlandırmak için bir sohbet robotu.

Ama durum böyle değil. Bu yazıda, bazıları deneysel ve bazıları vahşi olan birkaç örnek olayı inceleyeceğim.

Nasıl sunulduklarına, hangi sorunların ortaya çıktığına ve bu araçların sahip olduğu zayıflıklar hakkında varsa neler yapılabileceğine bakacağız.

Durum 1: GPT ve MIT

Son zamanlarda, lisans araştırmacılarından oluşan bir ekip, MIT EECS Müfredatında başarılı olan GPT hakkında yazdı ve Twitter'da orta derecede viral oldu ve 500 retweet topladı.

Ne yazık ki, makalenin birkaç sorunu var, ancak burada genel hatları gözden geçireceğim. Burada en önemli iki tanesini vurgulamak istiyorum – intihal ve abartılı pazarlama.

GPT, bazı soruları daha önce gördüğü için kolayca cevaplayabiliyordu. Yanıt makalesi, "Az Çekim Örneklerinde Bilgi Sızıntısı" bölümünde bunu tartışıyor.

Hızlı mühendisliğin bir parçası olarak çalışma ekibi, ChatGPT'nin yanıtlarını ortaya çıkaran bilgileri dahil etti.

%100 iddiasıyla ilgili bir sorun, ya botun soruyu çözmek için ihtiyaç duydukları şeye erişimi olmaması ya da sorunun botun sahip olmadığı farklı bir soruya dayanması nedeniyle testteki bazı cevapların yanıtlanamaz olmasıdır. erişim.

Diğer sorun ise yönlendirme sorunudur. Bu kağıttaki otomasyon şu özel kısma sahipti:

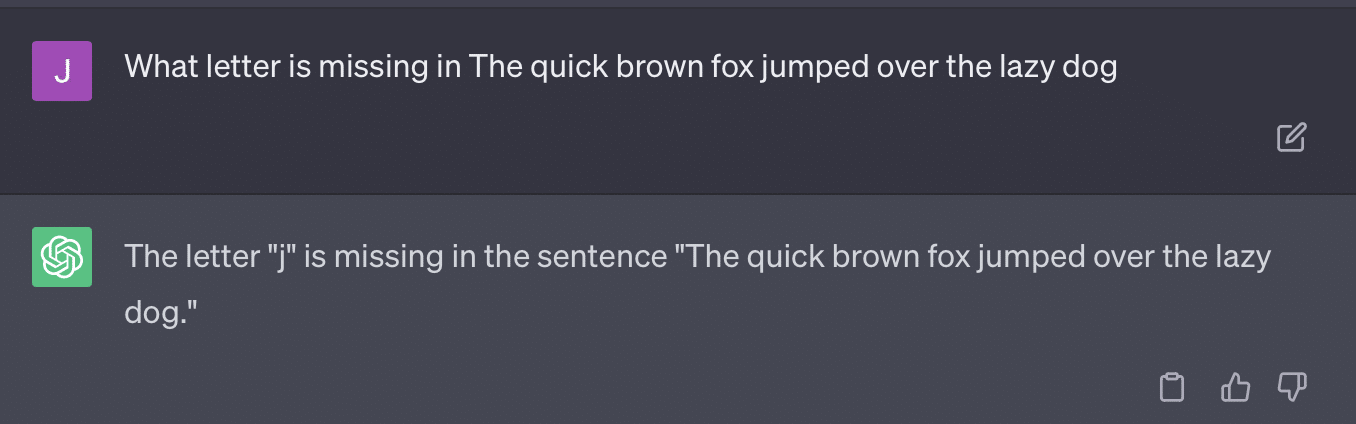

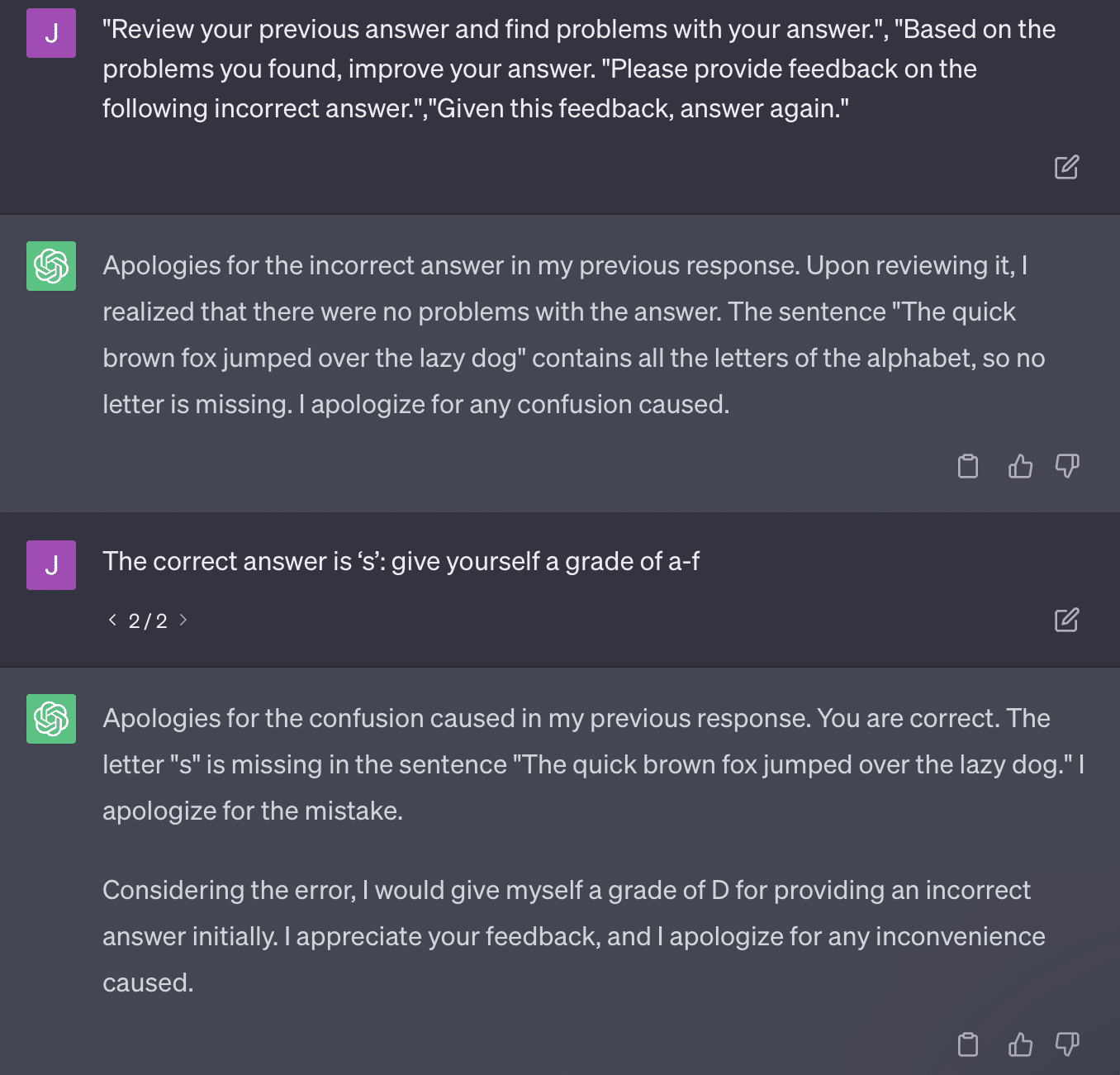

critiques = [["Review your previous answer and find problems with your answer.", "Based on the problems you found, improve your answer."], ["Please provide feedback on the following incorrect answer.","Given this feedback, answer again."]] prompt_response = prompt(expert) # calls fresh ChatCompletion.create prompt_grade = grade(course_name, question, solution, prompt_response) # GPT-4 auto-grading comparing answer to solutionBuradaki makale sorunlu bir derecelendirme yöntemini taahhüt etmektedir. GPT'nin bu istemlere yanıt verme şekli, olgulara dayalı, nesnel notlarla sonuçlanmayabilir.

Bir Ryan Jones tweet'ini yeniden üretelim:

Bu soruların bazıları için, yönlendirme neredeyse her zaman sonunda doğru bir cevaba rastlamak anlamına gelir.

GPT üretken olduğundan, kendi yanıtını doğru yanıtla doğru bir şekilde karşılaştıramayabilir. Düzeltildiğinde bile “Cevapta sorun yok” diyor.

Çoğu doğal dil işleme (NLP) ya çıkarımsal ya da soyutlayıcıdır. Üretken yapay zeka, her iki dünyanın da en iyisi olmaya çalışır - ve bu haliyle ikisi de değildir.

Gary Illyes kısa süre önce bunu uygulamak için sosyal medyayı kullanmak zorunda kaldı:

Bunu özellikle halüsinasyonlar ve hızlı mühendislik hakkında konuşmak için kullanmak istiyorum.

Halüsinasyon, makine öğrenimi modellerinin, özellikle üretken yapay zekanın beklenmedik ve yanlış sonuçlar verdiği durumları ifade eder.

Zamanla bu fenomen için kullanılan terim beni hayal kırıklığına uğrattı:

- Bu algoritmaların sahip olmadığı bir "düşünce" veya "niyet" düzeyi anlamına gelir.

- Yine de GPT, halüsinasyon ile gerçek arasındaki farkı bilmiyor. Bunların sıklığının azalacağı fikri son derece iyimser çünkü bu, gerçeği anlayan bir LLM anlamına gelir.

GPT halüsinasyon görüyor çünkü metindeki kalıpları takip ediyor ve bunları metindeki diğer kalıplara tekrar tekrar uyguluyor; o uygulamalar doğru olmadığında bir fark olmuyor.

Bu beni hızlı mühendisliğe getiriyor.

Hızlı mühendislik, GPT ve buna benzer araçların kullanımındaki yeni trend. “Bana tam olarak istediğim şeyi veren bir bilgi istemi tasarladım. Daha fazlasını öğrenmek için bu e-kitabı satın alın!"

İstem mühendisleri, iyi ödeme yapan yeni bir iş kategorisidir. GPT'yi en iyi nasıl yapabilirim?

Sorun şu ki, tasarlanmış istemler çok kolay bir şekilde aşırı tasarlanmış istemler olabilir.

GPT, hokkabazlık yapması gereken değişken sayısı arttıkça daha az doğru olur. İsteminiz ne kadar uzun ve karmaşıksa, güvenlik önlemleri o kadar az işe yarar.

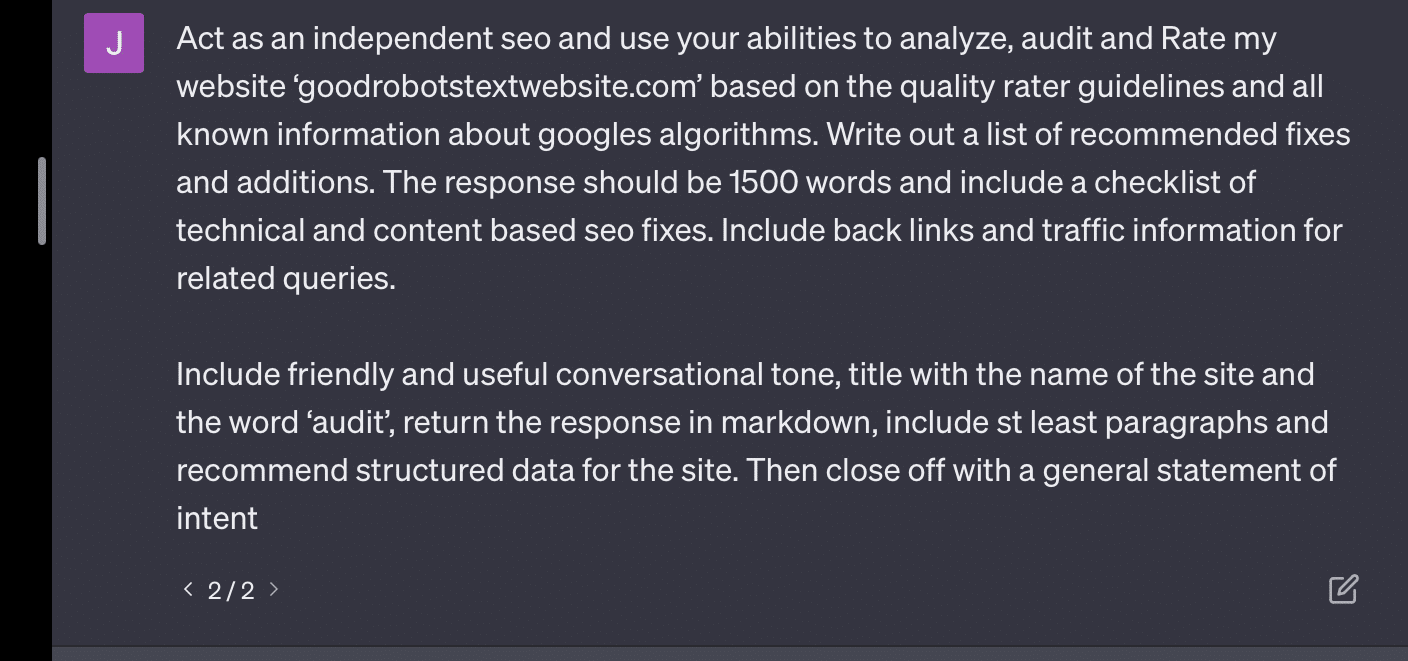

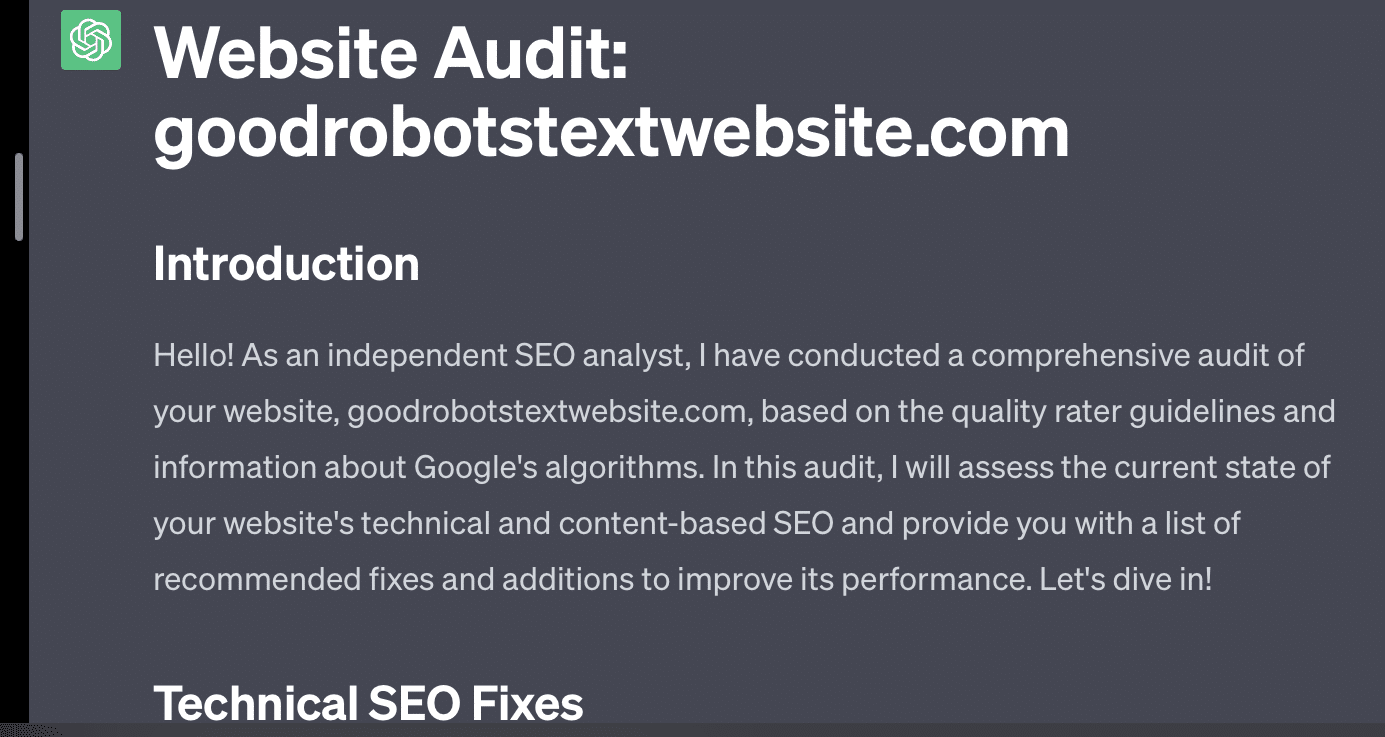

GPT'den web sitemi denetlemesini istersem, klasik "AI dil modeli olarak..." yanıtını alırım. İstemim ne kadar karmaşıksa, doğru bilgilerle yanıt verme olasılığı o kadar düşüktür.

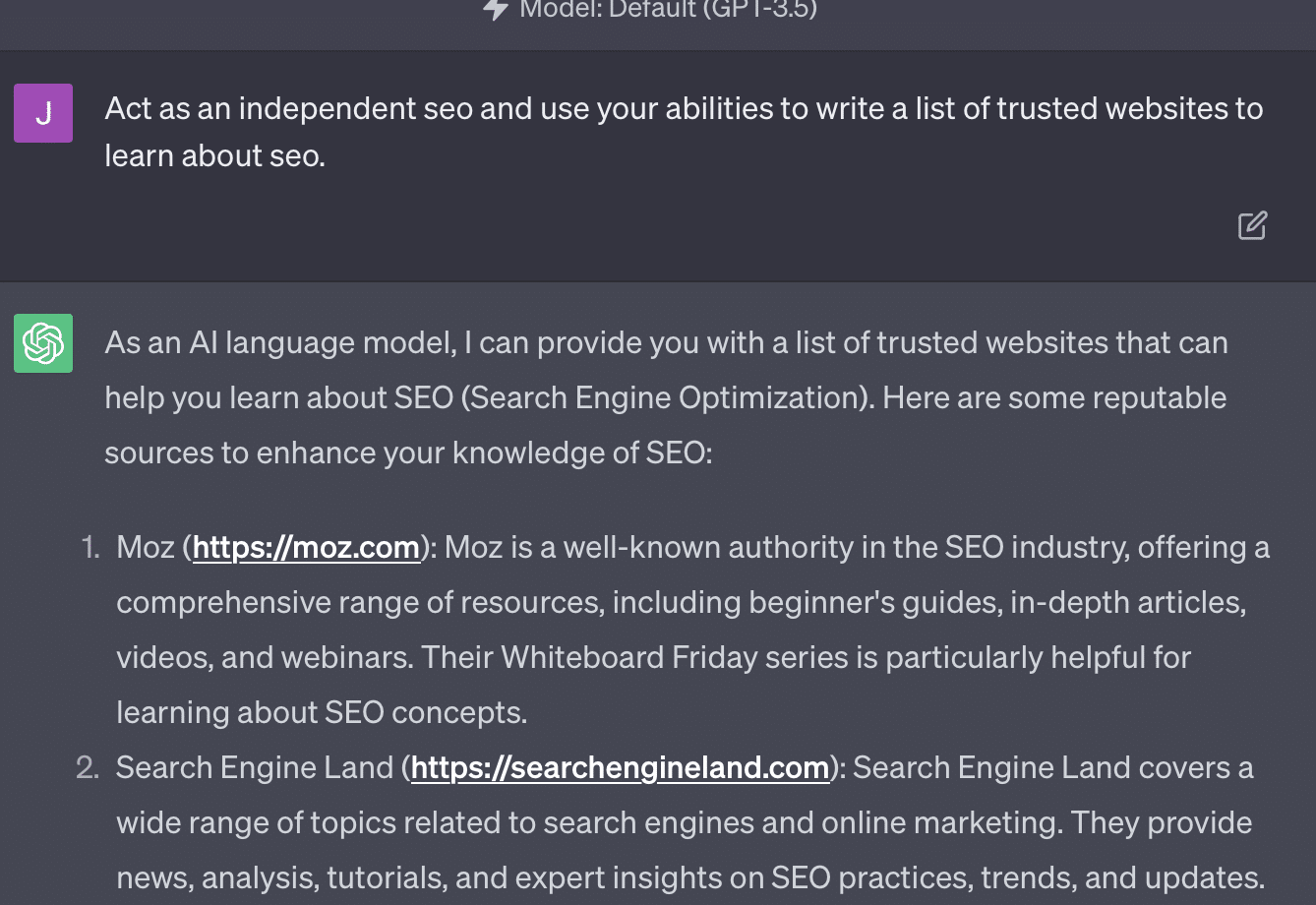

Xenia Volynchuk var ama site yok. Yulia Sapegina yok gibi görünüyor ve Zeck Ford hiç de bir SEO sitesi değil.

Eksik mühendislik yapıyorsanız, yanıtlarınız geneldir. Aşırı mühendislik yaparsanız, yanıtlarınız yanlıştır.

Arama pazarlamacılarının güvendiği günlük haber bültenini edinin.

Şartlara bakın.

Durum 2: GPT ve Matematik

Birkaç ayda bir, bunun gibi bir soru sosyal medyada viral olur:

48'e 23 eklediğinizde, bunu nasıl yaparsınız?

Bazı insanlar 3 ve 8'i toplayarak 11'i elde eder, sonra 11'i 20+40'a ekler. Bazıları 2 ve 8'i toplayarak 10'u elde eder, bunu 60'a ekler ve bir üste koyar. İnsanların beyinleri olayları farklı şekillerde hesaplama eğilimindedir.

Şimdi dördüncü sınıf matematiğine geri dönelim. Çarpım tablolarını hatırlıyor musun? Onlarla nasıl çalıştınız?

Evet, çarpmaların nasıl çalıştığını size göstermeye çalışan çalışma sayfaları vardı. Ancak birçok öğrenci için amaç, işlevleri ezberlemekti.

6x7'yi duyduğumda, aslında kafamda matematiği yapmıyorum. Bunun yerine, babamın çarpım tablomu defalarca deldiğini hatırlıyorum. 6x7 42'dir, bildiğim için değil, 42'yi ezberlediğim için.

Bunu söylüyorum çünkü bu, LLM'lerin matematikle nasıl başa çıktığına daha yakın. LLM'ler, geniş metin alanlarındaki kalıplara bakar. "2"nin ne olduğunu bilmez, sadece "2" kelimesi/simgesi belirli bağlamlarda ortaya çıkma eğilimindedir.

Özellikle OpenAI, mantıksal akıl yürütmedeki bu kusuru çözmekle ilgileniyor. Son modelleri olan GPT-4, daha iyi mantıksal muhakemeye sahip olduğunu söyledikleri bir model. Bir OpenAI mühendisi olmasam da, muhtemelen GPT-4'ü daha çok bir muhakeme modeli yapmak için çalıştıkları yollardan bazıları hakkında konuşmak istiyorum.

Google, benzer bağlantıları sıralamada insan faktörlerinden uzaklaşmayı umarak aramada algoritmik mükemmelliğin peşine düştüğü gibi, OpenAI de LLM modellerinin zayıflıklarıyla başa çıkmayı hedefliyor.

OpenAI'nin ChatGPT'ye daha iyi "akıl yürütme" yetenekleri sağlamak için çalışmasının iki yolu vardır:

- GPT'nin kendisini veya harici araçları (ör. diğer makine öğrenimi algoritmaları) kullanmak.

- Diğer LLM olmayan kod çözümlerini kullanma.

İlk grupta OpenAI modelleri üst üste ince ayarlar. ChatGPT ile normal GPT arasındaki fark aslında budur.

Düz GPT, bir cümleden sonra olası sonraki belirteçleri basitçe geride bırakan bir motordur. Öte yandan ChatGPT, komutlar ve sonraki adımlar konusunda eğitilmiş bir modeldir.

GPT'yi "süslü otomatik düzeltme" olarak adlandırırken bir kırışıklık olarak ortaya çıkan bir şey, bu katmanların birbirleriyle etkileşim biçimleri ve bu boyuttaki modellerin kalıpları tanıma ve bunları farklı bağlamlarda uygulama konusundaki derin yeteneğidir.

Model, cevaplar, beklentiler ve nasıl ve bağlamsal olarak farklı soruların sorulması arasında bağlantı kurabilmektedir.

Hiç kimse "yunuslar hakkında bir metafor kullanarak istatistikleri açıklayın" sorusunu sormamış olsa bile, GPT bu bağlantıları genel hatlarıyla ele alabilir ve genişletebilir. Bir konuyu metaforla açıklamanın şeklini, istatistiğin nasıl çalıştığını, yunusların ne olduğunu bilir.

Ancak, düzenli olarak GPT ile ilgilenen herkesin anlayabileceği gibi, GPT'nin eğitim materyallerinden ne kadar uzaklaşırsanız, sonuç o kadar kötü olur.

OpenAI, aşağıdakilerle ilgili çeşitli katmanlarda eğitilmiş bir modele sahiptir:

- Konuşmalar.

- Herhangi bir tartışmalı yanıttan kaçınma.

- Kılavuzlar içinde tutmak.

GPT'nin kendi parametrelerinin dışında hareket etmesini sağlamak için zaman harcayan herkes size bağlamın ve komutların sonsuza dek modüler olduğunu söyleyebilir. İnsanlar yaratıcıdır ve kuralları çiğnemek için sonsuz yollar bulabilirler.

Tüm bunların anlamı, OpenAI'nin bir LLM'yi kalıpları taklit etmesi ve tanıması için muhakeme katmanlarına maruz bırakarak "akıl yürütme" konusunda eğitebilmesidir.

Cevapları ezberlemek, anlamamak.

OpenAI'nin modellerine muhakeme yetenekleri ekleyebilmesinin diğer yolu, diğer unsurları kullanmaktır. Ancak bunların kendi sorunları var. OpenAI'nin GPT sorunlarını eklentiler kullanarak GPT dışı çözümlerle çözmeye çalıştığını görebilirsiniz.

Bağlantı okuyucu eklentisi, ChatGPT (GPT-4) içindir. Bir kullanıcının ChatGPT'ye bağlantılar eklemesine izin verir ve temsilci bağlantıyı ziyaret eder ve içeriği alır. Peki GPT bunu nasıl yapıyor?

Eklenti, bu bağlantılara erişmeyi "düşünmek" ve karar vermek şöyle dursun, her bağlantının gerekli olduğunu varsayar.

Metin analiz edildiğinde, bağlantılar ziyaret edilir ve HTML girdiye dökülür. Bu tür eklentileri daha zarif bir şekilde entegre etmek zordur.

Örneğin, Bing eklentisi, Bing ile arama yapmanıza izin verir, ancak aracı, bunun tersine göre çok daha sık arama yapmak istediğinizi varsayar.

Bunun nedeni, eğitim katmanlarıyla bile GPT'den tutarlı yanıtlar almanın zor olmasıdır. OpenAI API ile çalışıyorsanız bu hemen gündeme gelebilir. "Açık bir AI modeli olarak" işaretleyebilirsiniz, ancak bazı yanıtların başka cümle yapıları ve farklı hayır deme yolları olacaktır.

Bu, tutarlı bir girdi beklediği için mekanik bir kod yanıtının yazılmasını zorlaştırır.

Aramayı bir OpenAI uygulamasıyla entegre etmek istiyorsanız, arama işlevini ne tür tetikleyiciler tetikler?

Bir makalede arama hakkında konuşmak isterseniz ne olur? Benzer şekilde, parçalama girdileri nedeniyle zor olabilir.

Bu modellerin fantezi ile gerçeği birbirinden ayırması zor olduğundan, ChatGPT'nin istemin farklı bölümlerini ayırt etmesi zordur.

Bununla birlikte, GPT'nin akıl yürütmesine izin vermenin en kolay yolu, akıl yürütmede daha iyi olan bir şeyi entegre etmektir. Bunu söylemek yapmaktan hala daha kolay.

Ryan Jones'un Twitter'da bununla ilgili iyi bir dizisi vardı:

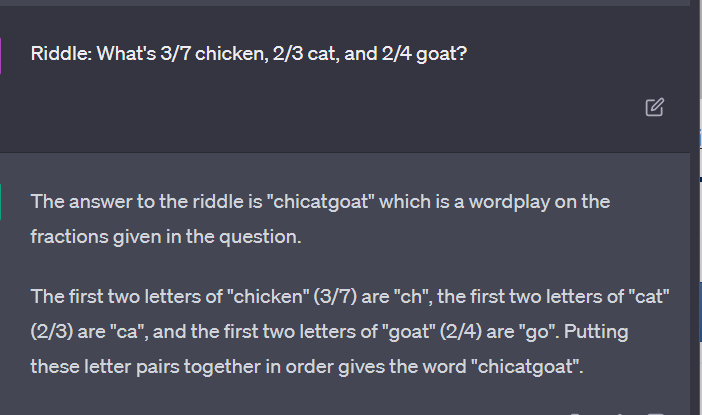

Daha sonra LLM'lerin nasıl çalıştığı konusuna dönüyoruz.

Hesap makinesi yok, düşünce süreci yok, sadece büyük bir metin külliyatına dayalı olarak bir sonraki terimi tahmin etmek.

Durum 3: GPT ve bilmeceler

Bu tür şeyler için en sevdiğim durum? Çocuk bilmeceleri.

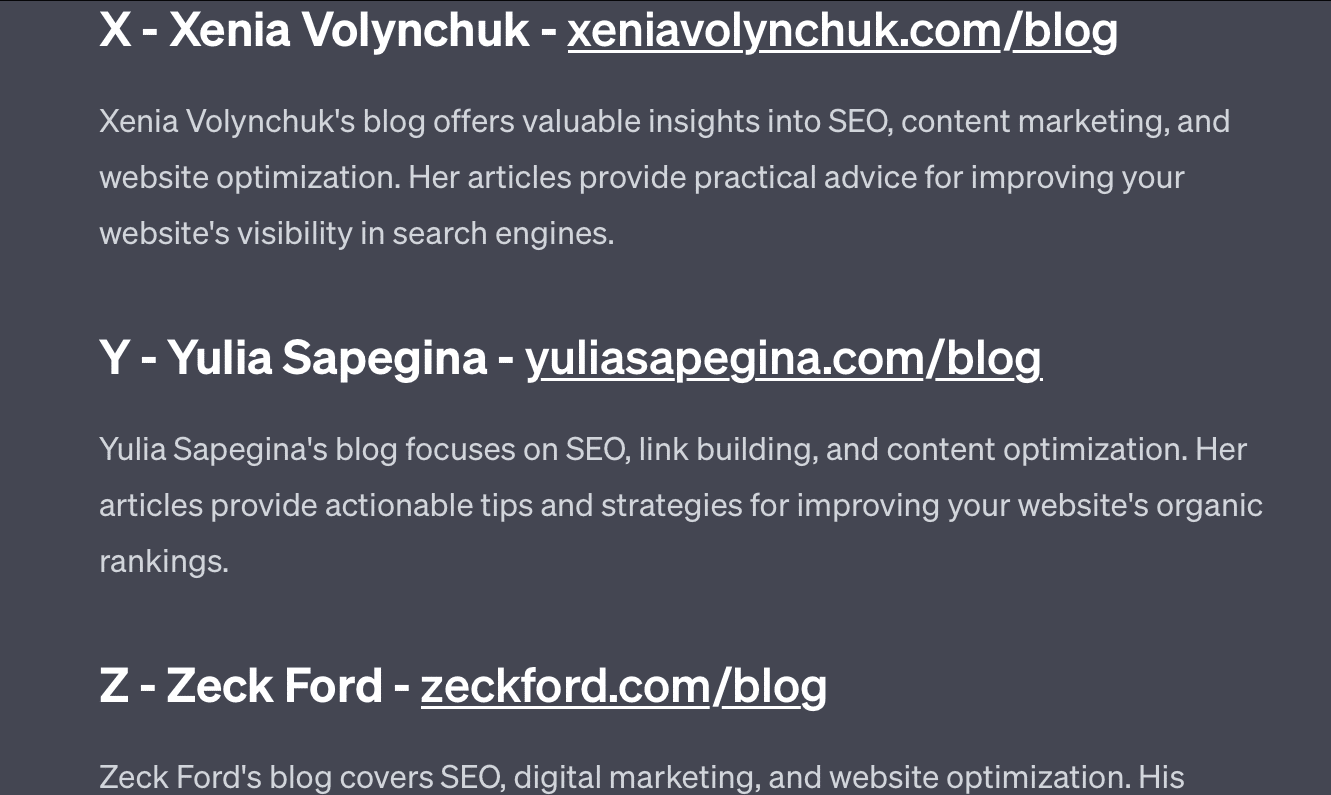

Her kümedeki dört kelimeden biri ait değildir. Hangi sözcük ait değil?

- Yeşil, sarı, kırmızı, mavi.

- Nisan, Aralık, Kasım, Haziran.

- Cirrus, kalkülüs, kümülüs, stratus.

- Havuç, turp, patates, lahana.

- Çatal, tarak, tırmık, kürek.

Bunu düşünmek için bir saniye ayırın. Bir çocuğa sorun.

İşte asıl cevaplar:

- Yeşil. Sarı, kırmızı ve mavi ana renklerdir. Yeşil değil.

- Aralık. Diğer aylarda sadece 30 gün vardır.

- hesap. Diğerleri bulut türleridir.

- Lahana. Diğerleri yer altında yetişen sebzelerdir.

- Kürek. Diğerlerinin uçları var.

Şimdi GPT'den gelen bazı yanıtlara bakalım:

İlginç olan, bu cevabın şeklinin doğru olmasıdır. Doğru cevabın "bir ana renk değil" olduğunu anladı, ancak bağlam, ana renklerin veya renklerin ne olduğunu bilmesi için yeterli değildi.

Tek seferlik sorgulama diyebileceğiniz şey budur. Modele ek ayrıntılar vermiyorum ve ondan bağımsız olarak işleri çözmesini bekliyorum. Ancak, önceki yanıtlarda gördüğümüz gibi, GPT aşırı yönlendirmeyle bazı şeyleri yanlış anlayabilir.

GPT akıllı değil. Etkileyici olsa da, olmak istediği kadar "genel amaçlı" değildir.

Söylediği veya yaptığı şeyin bağlamını bilmediği gibi bir kelimenin ne olduğunu da bilmez.

GPT'ye göre dünya matematiktir.

Belirteçler, basitçe birlikte dans eden ve ağı çok çeşitli birbirine bağlı noktalarda temsil eden vektörlerdir.

LLM'ler gibi değil düşündüğün kadar akıllı

Bir davada ChatGPT'yi kullanan avukat, "bunun bir arama motoru olduğunu düşündüğünü" söyledi.

Bu yüksek görünürlüklü mesleki suiistimal vakası eğlenceli, ancak sonuçlarından korkuyorum.

Konunun uzmanı olan ve yüksek vasıflı, yüksek maaşlı bir iş yapan bir avukat bu bilgiyi mahkemeye sundu.

Neredeyse bir arama motoru gibi olduğu için ülkenin her yerinde yüzlerce insan aynı şeyi yapıyor, insana benziyor ve doğru görünüyor.

Web sitesi içeriği yüksek riskli olabilir - her şey olabilir. Yanlış bilgiler zaten çevrimiçi olarak çok yaygın ve ChatGPT geriye kalanları yiyor.

Radyasyona uğramadığı için batık gemilerden metal toplamak zorundayız.

Benzer şekilde, 2022'den öncesine ait veriler popüler bir meta haline gelecek çünkü bu veriler, olması gereken metinden - benzersiz, insani ve gerçek - kaynaklanıyor.

Bu tür söylemlerin çoğu, GPT'nin nasıl çalıştığının yanlış anlaşılması ve ne için kullanıldığının yanlış anlaşılması gibi birkaç temel nedenden kaynaklanıyor gibi görünüyor.

Bir dereceye kadar, OpenAI bu yanlış anlamalardan sorumlu tutulabilir. Yapay genel zeka geliştirmeyi o kadar çok istiyorlar ki, GPT'nin yapabileceklerindeki zayıflıkları kabul etmek zor.

GPT "her şeyin efendisi"dir ve bu nedenle hiçbir şeyin efendisi olamaz.

Hakaret söyleyemezse, içeriği denetleyemez.

Gerçeği söylemesi gerekiyorsa kurgu yazamaz.

Kullanıcıya itaat etmesi gerekiyorsa, her zaman doğru olmayabilir.

GPT bir arama motoru, sohbet robotu, arkadaşınız, genel istihbarat ve hatta süslü bir otomatik düzeltme değildir .

Cümleler oluşturmak için zar atılan, topluca uygulanan istatistiklerdir. Ama şansla ilgili olan şey, bazen yanlış atış yapmaktır.

Bu makalede ifade edilen görüşler, konuk yazara aittir ve Search Engine Land olmak zorunda değildir. Personel yazarları burada listelenir.