Wikipedia Web Scraping 2023: Analiz için Veri Çıkarma

Yayınlanan: 2023-03-29Çevrimiçi kazıma, fiyat karşılaştırması, pazar araştırması, reklam doğrulama vb. amaçlar için web sitelerinden açık veriler toplamanıza olanak tanır.

Genel olarak gerekli genel verilerin büyük miktarları çıkarılır, ancak ablukalara karşı koştuğunuzda, ayıklama zor olabilir.

Kısıtlama, hız engelleme veya IP engelleme olabilir (isteğin IP adresi, yasaklanmış bir alandan, yasaklanmış IP türünden vb. kaynaklandığı için kısıtlanmıştır). (birden fazla istekte bulunduğu için IP adresi bloke edilmiştir).

Şimdi, bazı yararlı bilgi ve bilgileri kazmaya hazırsanız, o zaman eminim tonlarca bilgiye ev sahipliği yapan bilgi ansiklopedisi Wikipedia'yı kazımayı düşünmüşsünüzdür.

Web kazıma Vikipedi hakkında birkaç şeyi anlayalım.

İçindekiler

Wikipedia Web Kazıma

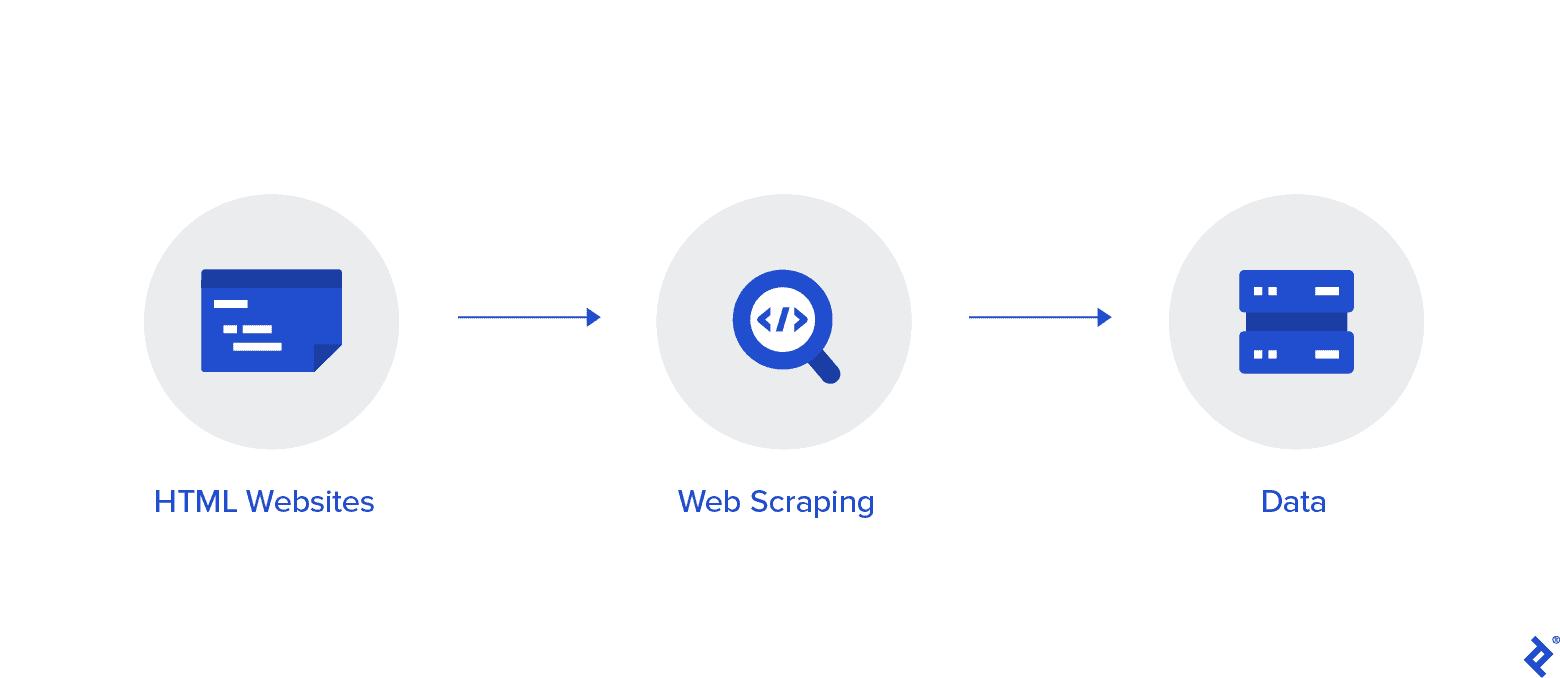

Web kazıma, internetten veri toplamanın otomatikleştirilmiş bir yöntemidir. Bu makalede, web kazıma hakkında derinlemesine bilgi, web tarama ile karşılaştırma ve web kazıma lehine argümanlar verilmektedir.

Amaç, çeşitli web kazıma yöntemlerini kullanarak Wikipedia Ana sayfasından veri toplamak ve ardından ayrıştırmaktır.

Çeşitli web kazıma yöntemlerine, Python web kazıma kitaplıklarına ve veri çıkarma ve işleme prosedürlerine daha aşina olacaksınız.

Web Scraping ve Python

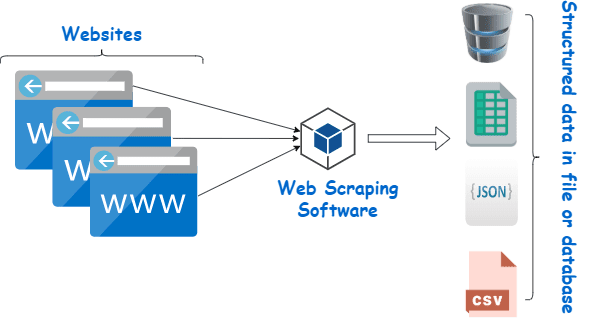

Web kazıma, temelde, bir programlama dilinde oluşturulmuş bir yazılım kullanarak çok sayıda web sitesinden büyük miktarda veriden yapılandırılmış veri çıkarma ve bunu cihazlarımızda, tercihen Excel sayfalarında, JSON'da veya elektronik tablolarda yerel olarak kaydetme işlemidir.

Bu, programcıların hem küçük hem de büyük projeler için mantıklı, anlaşılır kod oluşturmasına yardımcı olur.

Python, öncelikle web kazıma için en iyi dil olarak kabul edilir. Web taramasıyla ilgili görevlerin çoğunu etkili bir şekilde gerçekleştirebilir ve daha çok yönlüdür.

Wikipedia'dan veri nasıl kazınır?

Veriler web sayfalarından çeşitli şekillerde çıkarılabilir.

Örneğin, Python gibi bilgisayar dillerini kullanarak kendiniz uygulayabilirsiniz. Ancak teknoloji konusunda bilgili değilseniz, bu süreçte çok şey yapabilmek için önce çok çalışmanız gerekecek.

Ayrıca zaman alıcıdır ve Wikipedia sayfalarını manuel olarak taramak kadar uzun sürebilir. Ayrıca, ücretsiz web kazıyıcılara çevrimiçi olarak erişilebilir. Yine de, genellikle güvenilirlikten yoksundurlar ve tedarikçilerinin kötü niyetleri olabilir.

Saygın bir tedarikçiden düzgün bir web kazıyıcıya yatırım yapmak, Wiki verilerini toplamanın en iyi yöntemidir.

Bir sonraki adım genellikle basit ve karmaşık değildir çünkü sağlayıcı size sıyırıcının nasıl kurulacağı ve kullanılacağına ilişkin talimatlar sunacaktır.

Proxy, verileri daha etkili bir şekilde kazımak için wiki kazıyıcınızla birlikte kullanabileceğiniz bir araçtır. Scrapy, Scraping Robot ve Beautiful Soup gibi Python tabanlı çerçeveler, bu dili kullanarak kazımanın ne kadar kolay olduğunun sadece birkaç örneğidir.

Wikipedia'dan veri kazımak için proxy

Verileri etkili bir şekilde kazımak için son derece hızlı, kullanımı güvenli ve ihtiyaç duyduğunuzda size zarar vermeyeceği garanti edilen proxy'lere ihtiyacınız var. Bu tür proxy'ler Rayobyte'tan makul fiyatlara temin edilebilir.

Her kullanıcının farklı tercihleri ve kullanım durumları olduğunun farkında olduğumuz için çeşitli proxy'ler sunmaya çalışıyoruz.

Web kazıma Vikipedi için dönen proxy'ler

Proxy örneği, IP adresini düzenli olarak değiştiren örnektir. Ayrıca kesintileri önlemek için ban gerçekleştiğinde IP adresi hemen değiştirilmektedir. Bu, bu belirli proxy'yi site kazıma için mükemmel bir seçim haline getirir.

Statik proxy'ler, karşılaştırıldığında, yalnızca bir IP adresine sahiptir. İSS'niz otomatik değiştirmeyi etkinleştirmiyorsa ve yalnızca bir IP adresine erişiminiz varsa ve bu adres engellenirse bir tuğla duvarla karşılaşırsınız. Bu nedenle, statik proxy'ler web kazıma için en iyi seçenek değildir.

Web kazıma Wiki verileri için konut proxy'leri

Konut proxy'leri, İnternet Servis Sağlayıcılarının (ISS'ler) dağıttığı ve belirli hanelerle ilişkilendirildiği proxy IP adresleridir. Gerçek insanlardan geldikleri için onları elde etmek oldukça zordur. Sonuç olarak, kıt ve nispeten pahalıdırlar.

Verileri kazımak için konut proxy'lerini kullandığınızda, gerçek kişilerin adreslerine bağlı oldukları için sıradan bir kullanıcı gibi görünürsünüz.

Bu nedenle, konut proxy'lerini kullanmak, keşfedilme ve engellenme şansınızı önemli ölçüde azaltır. Bu nedenle, veri kazıma için mükemmel adaylardır.

Viki verilerini toplamak için dönüşümlü konut proxy'leri

Az önce bahsettiğimiz iki türü birleştiren dönen bir konut proxy'si, Wikipedia'yı web kazıma için en iyi proxy'dir.

Onları sık sık döndüren bir proxy kullanarak çok sayıda ev IP'sine erişebilirsiniz.

Bu çok önemlidir, çünkü konut proxy'lerini tanımlamanın zorluğuna rağmen, ürettikleri taleplerin hacmi sonunda kazınmakta olan web sitesinin dikkatini çekecektir.

Döndürme, IP adresi kaçınılmaz olarak kara listeye alınsa bile projenin devam edebilmesini sağlar.

Bu nedenle, ister birkaç veri merkezi proxy'si ile devam etmeye karar verin, ister birkaç yerleşik proxy'ye yatırım yapmayı tercih edin, ihtiyacınız olan her şeye sahibiz.

1GBS hızında çalışan proxy'ler, sınırsız bant genişliği ve 24 saat müşteri desteği ile en iyi web kazıma deneyiminin keyfine varacaksınız.

Ayrıca okuyabilirsiniz

- En İyi Web Kazıma Teknikleri: Pratik Bir Kılavuz

- Octoparse İncelemesi Gerçekten İyi Bir Web Scraping Aracı mı?

- En İyi Web Kazıma Araçları

- Web Scraping Nedir?-Nasıl Kullanılır? İşletmenize Nasıl Fayda Sağlayabilir?

Wikipedia'yı neden kazımalısın?

Wikipedia şu anda çevrimiçi dünyadaki en güvenilir ve bilgi açısından zengin hizmetlerden biridir. Bu platformda aklınıza gelebilecek hemen hemen her türlü konuya cevap ve bilgi bulunmaktadır.

Dolayısıyla, doğal olarak Wikipedia, verileri sıyırmak için harika bir kaynaktır. Wikipedia'yı neden kazmanız gerektiğinin ana nedenlerini tartışalım.

Akademik araştırma için web kazıma

Veri toplama, araştırmada yer alan en sancılı faaliyetlerden biridir. Daha önce tartışıldığı gibi, ağ sıyırıcılar bu prosedürü daha hızlı ve kolay hale getirirken aynı zamanda size bir ton zaman ve enerji tasarrufu sağlar.

Bir web kazıyıcı ile çok sayıda wiki sayfasını hızlı bir şekilde tarayabilir ve ihtiyacınız olan tüm verileri organize bir şekilde toplayabilirsiniz.

Bir an için hedefinizin, depresyon ve güneş ışığına maruz kalmanın ülkeden ülkeye değişip değişmediğini belirlemek olduğunu varsayalım.

Farklı ülkelerde depresyonun yaygınlığı ve güneşli saatleri gibi bilgileri bulmak için çok sayıda Wikipedia girdisini incelemek yerine bir Wiki kazıyıcı kullanabilirsiniz.

İtibar yönetimi

Wikipedia sayfası oluşturmak, modern çağda birçok farklı işletme türü için yapılması gereken bir pazarlama stratejisi haline geldi çünkü Wikipedia gönderileri sıklıkla Google'ın ilk sayfasında yer alıyor.

Ancak Wikipedia'da bir sayfanızın olması, pazarlama çabalarınızın sonu olmamalıdır. Vikipedi kitle kaynaklı bir platformdur, bu nedenle vandalizm oldukça sık gerçekleşen bir şeydir.

Sonuç olarak, birisi şirketinizin sayfasına olumsuz bilgiler ekleyebilir ve itibarınıza zarar verebilir. Alternatif olarak, ilgili bir wiki makalesinde işletmenizi karalayabilirler.

Bu nedenle, Wiki sayfanıza ve bir kez işinizden bahseden diğer sayfalara göz kulak olmalısınız. Bunu bir wiki kazıyıcı yardımıyla kolaylıkla yapabilirsiniz.

İşletmenizle ilgili referanslar için Wikipedia sayfalarını düzenli olarak arayabilir ve oradaki herhangi bir vandalizm örneğine dikkat çekebilirsiniz.

SEO'yu Artırın

Web sitenize gelen trafiği artırmak için Wikipedia'yı kullanabilirsiniz.

İşinize ve hedef kitlenize uygun sayfaları bulmak için bir Wiki veri kazıyıcı kullanarak değiştirmek istediğiniz makalelerin bir listesini oluşturun.

Makaleleri okuyarak ve siteye katkıda bulunan biri olarak güvenilirlik kazanmak için birkaç yararlı düzenleme yaparak başlayın.

Bir miktar güvenilirlik oluşturduktan sonra, web sitenize kopuk bağlantıların olduğu veya alıntı yapılması gereken yerlerde bağlantılar ekleyebilirsiniz.

Hızlı Linkler

- En İyi Fransız Vekilleri

- En İyi Spotify Proxy'si

- En İyi Nike Proxy'leri

Web kazıma için kullanılan Python kitaplıkları

Python, daha önce de söylendiği gibi, dünyadaki en popüler ve saygın programlama dili ve web kazıma aracıdır. Şimdi şu anda mevcut olan Python web kazıma kitaplıklarına bakalım.

Web Kazıma için İstekler (İnsanlar için HTTP) Kitaplığı

GET ve POST gibi farklı HTTP istekleri göndermek için kullanılır. Tüm kütüphaneler arasında en temel ama aynı zamanda en önemli olanıdır.

Web Scraping için lxml Kitaplığı

Web sitelerinden HTML ve XML metinlerinin çok hızlı ve yüksek performanslı ayrıştırılması, lxml paketi tarafından sunulmaktadır. Büyük veritabanlarını kazımak istiyorsanız, seçeceğiniz şey budur.

Web Kazıma için Güzel Çorba Kitaplığı

Çalışması, içerik ayrıştırma için bir ayrıştırma ağacı oluşturmaktır. Yeni başlayanlar için başlamak için harika bir yer ve son derece kullanıcı dostu.

Web Kazıma için Selenyum Kitaplığı

Bu kitaplık, yukarıda belirtilen tüm kitaplıkların sahip olduğu sorunu, yani dinamik olarak doldurulmuş web sayfalarından içerik kazıma sorununu çözer.

Başlangıçta web uygulamalarının otomatik testi için tasarlanmıştır. Bu nedenle, daha yavaştır ve endüstriyel düzeydeki görevler için uygun değildir.

Web Scraping için Scrapy

Eşzamansız kullanım kullanan eksiksiz bir web kazıma çerçevesi, tüm paketlerin BOSS'udur. Bu, verimliliği artırır ve son derece hızlı hale getirir.

Çözüm

Yani bu, Wikipedia Web Scraping hakkında bilmeniz gereken hemen hemen en önemli husustu. Web Scraping ve çok daha fazlası hakkında bu tür bilgilendirici gönderiler için bizi takip etmeye devam edin!

Hızlı Linkler

- Seyahat Ücreti Toplama İçin En İyi Proxy'ler

- En İyi Fransız Vekilleri

- En İyi Tripadvisor Proxy'leri

- En İyi Etsy Proxy'leri

- IPRoyal Kupon Kodu

- En İyi TikTok Proxy'leri