Yıl Boyu SEO Vaka Çalışması: Googlebot Hakkında Bilmeniz Gerekenler

Yayınlanan: 2019-08-30Editörün Notu: JetOctopus paletli CEO'su Serge Bezborodov, web sitenizi Googlebot için nasıl çekici hale getireceğinize dair uzman tavsiyeleri veriyor. Bu makaledeki veriler, bir yıllık araştırmaya ve taranan 300 milyon sayfaya dayanmaktadır.

Birkaç yıl önce, 5 milyon sayfalık iş toplayıcı web sitemizdeki trafiği artırmaya çalışıyordum. Trafiğin tavan yapacağını umarak SEO ajans hizmetlerini kullanmaya karar verdim. Ama yanılmışım. Kapsamlı bir denetim yerine tarot kartları baktırdım. Bu yüzden en başa döndüm ve kapsamlı sayfa içi SEO analizi için bir web gezgini oluşturdum.

Bir yılı aşkın süredir Googlebot'u gözetliyorum ve şimdi davranışıyla ilgili bilgileri paylaşmaya hazırım. Gözlemlerimin en azından web tarayıcılarının nasıl çalıştığını netleştireceğini ve en fazla sayfa içi optimizasyonu verimli bir şekilde yapmanıza yardımcı olacağını umuyorum. İster yeni bir site ister binlerce sayfalık bir site için işinize yarayacak en anlamlı verileri bir araya topladım.

Sayfalarınız SERP'lerde Görünüyor mu?

Hangi sayfaların arama sonuçlarında olduğundan emin olmak için tüm web sitesinin indekslenebilirliğini kontrol etmelisiniz. Bununla birlikte, 10 milyondan fazla sayfadan oluşan bir web sitesindeki her bir URL'nin analizi, yaklaşık olarak yeni bir araba kadar bir servete mal olur.

Bunun yerine günlük dosyaları analizini kullanalım. Web siteleriyle şu şekilde çalışıyoruz: Arama botunun yaptığı gibi web sayfalarını tarıyoruz ve ardından yılın yarısında toplanan günlük dosyalarını analiz ediyoruz. Günlükler, botların web sitesini ziyaret edip etmediğini, hangi sayfaların tarandığını ve botların sayfaları ne zaman ve ne sıklıkta ziyaret ettiğini gösterir.

Tarama, arama botlarının web sitenizi ziyaret etmesi, web sayfalarındaki tüm bağlantıları işlemesi ve bu bağlantıları indeksleme için sıraya koyması işlemidir. Tarama sırasında botlar, yeni işlenen URL'leri zaten dizinde bulunanlarla karşılaştırır. Böylece, botlar verileri yeniler ve kullanıcılara en alakalı ve taze sonuçları sağlamak için arama motoru veritabanından bazı URL'ler ekler/sler.

Şimdi, kolayca şu sonuçları çıkarabiliriz:

- Arama botu URL'de olmadıkça, bu URL muhtemelen dizinde olmayacaktır.

- Googlebot URL'yi günde birkaç kez ziyaret ederse, bu URL yüksek önceliklidir ve bu nedenle özel dikkat göstermenizi gerektirir.

Toplamda, bu bilgiler web sitenizin organik büyümesini ve gelişimini neyin engellediğini ortaya koymaktadır. Artık ekibiniz körü körüne çalışmak yerine bir web sitesini akıllıca optimize edebilir.

Çoğunlukla büyük web siteleriyle çalışıyoruz çünkü web siteniz küçükse, Googlebot er ya da geç tüm web sayfalarınızı tarayacaktır.

Tersine, 100.000'den fazla sayfaya sahip web siteleri, tarayıcı web yöneticileri tarafından görülemeyen sayfaları ziyaret ettiğinde bir sorunla karşılaşır. Bu yararsız ve hatta zararlı sayfalarda değerli tarama bütçesi boşa harcanabilir. Aynı zamanda bir web sitesi yapısında bir karmaşa olduğu için bot karlı sayfalarınızı asla bulamayabilir.

Tarama bütçesi, Googlebot'un web sitenizde harcamaya hazır olduğu sınırlı kaynaklardır. Neyin ne zaman analiz edileceğine öncelik vermek için oluşturuldu. Tarama bütçesinin boyutu, web sitenizin boyutu, yapısı, kullanıcı sorgularının hacmi ve sıklığı gibi birçok faktöre bağlıdır.

Arama botunun web sitenizi tamamen taramakla ilgilenmediğini unutmayın.

Arama motoru botunun temel amacı, kullanıcılara minimum kaynak kaybıyla en alakalı yanıtları vermektir.Bot asıl amaç için ihtiyaç duyduğu kadar veriyi tarar. Bu nedenle, botun en yararlı ve karlı içeriği almasına yardımcı olmak SİZİN görevinizdir.

Googlebot'ta casusluk

Geçen yıl boyunca, büyük web sitelerinde 300 milyondan fazla URL ve 6 milyar günlük satırı taradık. Bu verilere dayanarak, aşağıdaki soruları yanıtlamaya yardımcı olmak için Googlebot'un davranışını izledik:

- Ne tür sayfalar yoksayılır?

- Hangi sayfalar sıklıkla ziyaret edilir?

- Bot için dikkat edilmesi gereken nedir?

- Neyin değeri yok?

Aşağıda, Google Web Yöneticisi Yönergeleri'nin yeniden yazılmış hali değil, analizimiz ve bulgularımız yer almaktadır. Aslında, kanıtlanmamış ve gerekçesiz tavsiyeler vermiyoruz. Her nokta, rahatınız için gerçek istatistiklere ve grafiklere dayanmaktadır.

Lafı uzatmayalım ve öğrenelim:

- Googlebot için gerçekten önemli olan nedir?

- Botun sayfayı ziyaret edip etmeyeceğini ne belirler?

Aşağıdaki faktörleri belirledik:

Dizinden Uzaklık

DFI, Dizinden Uzaklık anlamına gelir ve URL'nizin tıklamalarda ana/kök/dizin URL'sine ne kadar uzak olduğunu gösterir. Googlebot'un ziyaret sıklığını etkileyen en önemli kriterlerden biridir. İşte DFI hakkında daha fazla bilgi edinmek için bir eğitim videosu .

DFI'nin URL dizinindeki eğik çizgi sayısı olmadığını unutmayın, örneğin:

site.com / mağaza /iphone/iphoneX.html – DFI – 3

Yani, DFI tam olarak ana sayfadan TIKLAMALAR ile sayılır

https://site.com/shop/iphone/iphoneX.html

https://site.com iPhone Kataloğu → https://site.com/shop/iphone iPhone X → https://site.com/shop/iphone/iphoneX.html – DFI – 2

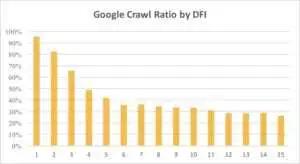

Aşağıda, Googlebot'un DFI'lı URL'ye olan ilgisinin geçen ay ve son altı ayda nasıl kademeli olarak azaldığını görebilirsiniz.

Gördüğünüz gibi, DFI 5 t0 6 ise, Googlebot web sayfalarının yalnızca yarısını tarar. DFI daha büyükse, işlenen sayfaların yüzdesi azalır. Tablodaki göstergeler 18 milyon sayfa için birleştirildi. Verilerin, belirli bir web sitesinin nişine bağlı olarak değişebileceğini unutmayın.

Ne yapalım?

Bu durumda en iyi stratejinin 5'ten uzun DFI'den kaçınmak, gezinmesi kolay bir web sitesi yapısı oluşturmak, bağlantılara özellikle dikkat etmek vb. olduğu açıktır.

Gerçek şu ki, bu önlemler 100.000'den fazla sayfalı web siteleri için gerçekten zaman alıyor. Genellikle büyük web sitelerinin uzun bir yeniden tasarım ve geçiş geçmişi vardır. Bu nedenle web yöneticileri DFI'si 10, 12 ve hatta 30 olan sayfaları silmemelidir. Ayrıca, sık ziyaret edilen sayfalardan bir bağlantı eklemek sorunu çözmez.

Uzun DFI ile başa çıkmanın en iyi yolu, bu URL'lerin alakalı, karlı olup olmadığını ve SERP'lerde hangi konumlara sahip olduklarını kontrol etmek ve tahmin etmektir.

Uzun DFI'ye sahip ancak SERP'lerde iyi konumlara sahip sayfaların potansiyeli yüksektir. Yüksek kaliteli sayfalardaki trafiği artırmak için web yöneticileri sonraki sayfalardan bağlantılar eklemelidir. Somut ilerleme için bir ila iki bağlantı yeterli değildir.

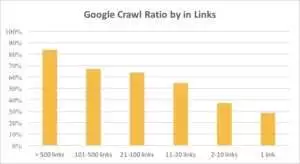

Sayfada 10'dan fazla bağlantı varsa, Googlebot'un URL'leri daha sık ziyaret ettiğini aşağıdaki grafikten görebilirsiniz.

Bağlantılar

Aslında, bir web sitesi ne kadar büyükse, web sayfalarındaki bağlantı sayısı o kadar fazladır. Bu veriler aslında 1 milyondan fazla sayfadan oluşan web sitelerinden alınmıştır.

Karlı sayfalarınızda 10'dan az bağlantı olduğunu keşfettiyseniz, paniğe kapılmayın. İlk olarak, bu sayfaların yüksek kaliteli ve karlı olup olmadığını kontrol edin. Bunu yaptığınızda, yüksek kaliteli sayfalara acele etmeden ve kısa yinelemelerle, her adımdan sonra günlükleri analiz ederek bağlantılar ekleyin.

İçerik Boyutu

İçerik, SEO analizinin en popüler yönlerinden biridir. Elbette, web sitenizde ne kadar alakalı içerik varsa, Tarama Oranınız o kadar iyi olur. Aşağıda, 500 kelimeden az sayfalar için Googlebot'un ilgisinin ne kadar önemli ölçüde azaldığını görebilirsiniz.

Ne yapalım?

Deneyimlerime göre, 500 kelimeden az olan tüm sayfaların neredeyse yarısı çöp sayfalardır. Bir web sitesinde yalnızca giysi bedenlerinin listelendiği 70.000 sayfa bulunduğu bir durum gördük, bu nedenle bu sayfaların yalnızca bir kısmı dizinde yer aldı.

Bu nedenle, öncelikle bu sayfalara gerçekten ihtiyacınız olup olmadığını kontrol edin. Bu URL'ler önemliyse, bunlarla ilgili bazı içerikler eklemelisiniz. Ekleyecek bir şeyiniz yoksa rahatlayın ve bu URL'leri olduğu gibi bırakın. Bazen işe yaramaz içerik yayınlamak yerine hiçbir şey yapmamak daha iyidir.

Diğer Faktörler

Aşağıdaki faktörler, Tarama Oranını önemli ölçüde etkileyebilir:

Yükleme zamanı

Web sayfası hızı, tarama ve sıralama için çok önemlidir. Bot insan gibidir: Bir web sayfasının yüklenmesini çok uzun süre beklemekten nefret eder. Web sitenizde 1 milyondan fazla sayfa varsa, arama botu muhtemelen bir sayfanın 5 saniyede yüklenmesini beklemek yerine 1 saniyelik yükleme süresiyle beş sayfayı indirecektir.

Ne yapalım?

Aslında, bu teknik bir görevdir ve daha büyük bir sunucu kullanmak gibi "herkese uyan tek yöntem" bir çözüm yoktur. Ana fikir, sorunun darboğazını bulmaktır. Web sayfalarının neden yavaş yüklendiğini anlamalısınız. Ancak sebep ortaya çıktıktan sonra harekete geçebilirsiniz.

Benzersiz ve Şablonlu İçeriğin Oranı

Benzersiz ve şablonlanmış veriler arasındaki denge önemlidir. Örneğin, evcil hayvan adlarının varyasyonlarını içeren bir web siteniz var. Bu konu hakkında gerçekten ne kadar alakalı ve benzersiz içerik toplayabilirsiniz?

Luna en popüler “ünlü” köpek ismiydi, onu Stella, Jack, Milo ve Leo takip etti.

Arama botları kaynaklarını bu tür sayfalarda harcamayı sevmezler.

Ne yapalım?

Dengeyi koruyun. Kullanıcılar ve botlar, karmaşık şablonlara, çok sayıda giden bağlantıya ve az içeriğe sahip sayfaları ziyaret etmekten hoşlanmazlar.

Yetim Sayfalar

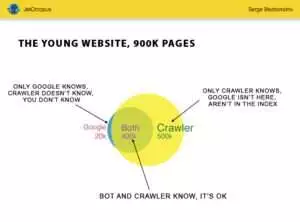

Yetim Sayfalar, web sitesi yapısında olmayan URL'lerdir ve bu sayfalar hakkında bilginiz yoktur, ancak bu yetim sayfalar botlar tarafından taranabilir. Açıklığa kavuşturmak için, aşağıdaki resimde Euler Çemberine bakın :

Bir süredir yapısı değişmeyen genç web sitesi için normal durumu görebilirsiniz. Sizin ve tarayıcının analiz edebileceği 900.000 sayfa var. Yaklaşık 500.000 sayfa tarayıcı tarafından işleniyor ancak Google tarafından bilinmiyor. Bu 500.000 URL'yi indekslenebilir hale getirirseniz, trafiğiniz kesinlikle artacaktır.

Dikkat: Genç bir web sitesinde bile web sitesi yapısında olmayan ancak bot tarafından düzenli olarak ziyaret edilen bazı sayfalar (resimdeki mavi kısım) bulunmaktadır.

Ve bu sayfalar, otomatik olarak oluşturulan işe yaramaz ziyaretçi sorguları gibi çöp içeriği içerebilir.

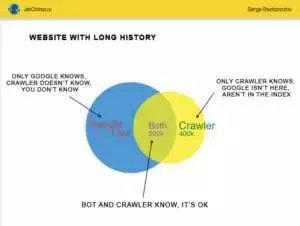

Ancak büyük web siteleri nadiren bu kadar hassastır. Çoğu zaman geçmişi olan web siteleri şöyle görünür:

İşte diğer sorun: Google, web siteniz hakkında sizden daha fazlasını biliyor. Silinmiş sayfalar, JavaScript veya Ajax'taki sayfalar, bozuk yönlendirmeler vb. Bir keresinde, bir programcının hatası nedeniyle site haritasında 500.000 kırık bağlantı listesinin göründüğü bir durumla karşılaştık. Üç gün sonra hata bulundu ve düzeltildi, ancak Googlebot altı aydır bu bozuk bağlantıları ziyaret ediyordu!

Tarama Bütçeniz sıklıkla bu Yetim Sayfalarda boşa harcanır.

Ne yapalım?

Bu olası sorunu çözmenin iki yolu vardır: İlki kurala uygundur: pisliği temizlemek. Web sitesinin yapısını düzenleyin, dahili bağlantıları doğru bir şekilde ekleyin, dizinlenmiş sayfalardan bağlantılar ekleyerek artık sayfaları DFI'ye ekleyin, programcılar için görev belirleyin ve bir sonraki Googlebot ziyaretini bekleyin.

İkinci yol istemdir: yetim sayfaların listesini toplayın ve alakalı olup olmadıklarını kontrol edin. Cevabınız “evet” ise site haritasını bu URL'lerle oluşturun ve Google'a gönderin. Bu yol daha kolay ve hızlıdır, ancak yetim sayfaların yalnızca yarısı dizinde olacaktır.

Sonraki seviye

Arama motoru algoritmaları yirmi yıldır gelişiyor ve arama taramasının birkaç grafikle açıklanabileceğini düşünmek saflık.

Her sayfa için 200'den fazla farklı parametre topluyoruz ve bu sayının yıl sonuna kadar artmasını bekliyoruz. Web sitenizin 1 milyon satırlık (sayfalık) bir tablo olduğunu düşünün ve bu satırları 200 sütunla çarpın, basit bir örnek, kapsamlı, teknik bir denetim için yeterli değildir. Katılıyor musun?

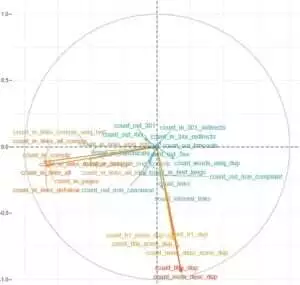

Daha derine inmeye karar verdik ve her durumda Googlebot'ların taramasını neyin etkilediğini öğrenmek için makine öğrenimini kullandık.

Birincisi, web sitesi bağlantıları çok önemliyken, içerik diğeri için anahtar faktördür.

Bu görevin asıl amacı, karmaşık ve devasa verilerden kolay yanıtlar almaktı: Web sitenizde indekslemeyi en çok ne etkiler? Hangi URL kümeleri aynı faktörlerle bağlantılıdır? Böylece onlarla kapsamlı bir şekilde çalışabilirsiniz.

HotWork toplayıcı web sitemizdeki günlükleri indirip analiz etmeden önce, botlar tarafından görülebilen ancak bizim için görünmeyen yetim sayfalarla ilgili hikaye bana gerçekçi gelmedi. Ancak gerçek durum beni daha da şaşırttı: Tarama, 301 yönlendirmeli 500 sayfa gösterdi, ancak Yandex aynı durum koduna sahip 700.000 sayfa buldu.

Genellikle, teknik meraklılar günlük dosyalarını depolamaktan hoşlanmazlar çünkü bu veriler diskleri "aşırı yükler". Ancak nesnel olarak, ayda 10 milyona kadar ziyaret edilen çoğu web sitesinde, günlük depolamanın temel ayarı mükemmel şekilde çalışır.

Günlüklerin hacminden bahsetmişken, en iyi çözüm bir arşiv oluşturup onu Amazon S3-Glacier'de indirmektir (250 GB veriyi yalnızca 1 ABD Doları karşılığında depolayabilirsiniz). Sistem yöneticileri için bu görev bir fincan kahve yapmak kadar kolaydır. Gelecekte, geçmiş günlükler, teknik hataların ortaya çıkarılmasına ve Google'ın güncellemelerinin web sitenizdeki etkisinin tahmin edilmesine yardımcı olacaktır.