如何提高企业级爬取和索引效率

已发表: 2023-07-13企业搜索引擎优化遵循不同的规则。

适用于小型或利基网站的策略并不总是适用于大规模网站。

那么当企业 SEO 规模太大时到底会发生什么?

在这篇文章中,我将分享三个现实生活中的例子。 然后,您将学习一种潜在的解药,可以更有效地大规模管理 SEO。

面临索引困境

小型网站倾向于一次增加一页,使用关键字作为 SEO 策略的构建块。

大型网站通常采用更复杂的方法,严重依赖系统、规则和自动化。

将 SEO 与业务目标保持一致至关重要。 根据关键词排名或流量来衡量 SEO 成功与否会因过度索引而产生负面后果。

没有一个神奇的公式可以确定索引 URL 的最佳数量。 谷歌没有设定上限。

然而,一个好的起点是考虑 SEO 漏斗的整体健康状况。 如果一个网站...

- 向 Google 推送数千万、数亿、甚至数十亿的 URL

- 仅对几百万个关键字进行排名

- 接收数千个页面的访问量

- 转换其中的一小部分(如果有的话)

…那么这是一个很好的迹象,表明您需要解决一些严重的 SEO 健康需求。

现在解决任何网站卫生问题应该可以防止以后出现更大的 SEO 问题。

让我们看三个现实的企业 SEO 示例,说明为什么这如此重要。

案例 1:对低质量内容过度索引的后果

谷歌用于网络抓取和处理的资源有限。 他们优先考虑对用户有价值的内容。

Google 可能会抓取它认为薄弱、重复或低质量的页面,但不会对其编制索引。

如果只有几页,那不是问题。 但如果它很普遍,谷歌可能会忽略整个页面类型或网站的大部分内容。

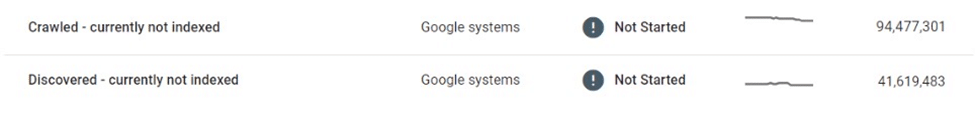

在一个例子中,一个电子商务市场发现其数千万个列表页面受到选择性爬行和索引的影响。

在抓取了数百万个薄弱的、近乎重复的列表页面并且没有将它们编入索引之后,谷歌最终缩减了对网站的抓取,使许多页面处于“已发现 - 目前未编入索引”的困境。

该市场严重依赖搜索引擎向用户推广新列表。 不再发现新内容,这构成了重大的业务挑战。

我们立即采取了一些措施,例如改进内部链接和部署动态 XML 站点地图。 最终,这些尝试都是徒劳的。

真正的解决方案需要控制可索引内容的数量和质量。

案例2:爬行停止的不可预见的后果

当抓取停止时,不需要的内容将保留在 Google 索引中 - 即使它被更改、重定向或删除。

许多网站对删除的内容使用重定向而不是 404 错误来维护权威。 这种策略可以从幽灵页面中挤出额外的流量数月甚至数年。

然而,这有时可能会出现严重错误。

例如,一个销售手工制品的知名全球市场无意中在其列表页面的本地化版本上泄露了卖家的私人信息(例如姓名、地址、电子邮件、电话号码)。 其中一些页面被谷歌索引和缓存,在搜索结果中显示个人身份信息(PII),危及用户安全和隐私。

由于 Google 不会重新抓取这些页面,因此删除或更新它们不会将它们从索引中删除。 即使在删除几个月后,缓存的内容和用户 PII 数据仍然存在于 Google 索引中。

在这种情况下,市场有责任修复错误并直接与 Google 合作从搜索中删除敏感内容。

案例3:过度索引搜索结果页面的风险

对大量薄弱的低质量页面进行不受控制的索引可能会适得其反,但是对搜索结果页面进行索引又如何呢?

Google 不支持对内部搜索结果建立索引,许多经验丰富的 SEO 强烈建议不要采用这种策略。 然而,许多大型网站严重依赖内部搜索作为主要的 SEO 驱动力,通常会产生可观的回报。

如果用户参与度指标、页面体验和内容质量足够高,谷歌就可以视而不见。 事实上,有足够的证据表明谷歌甚至可能更喜欢高质量的内部搜索结果页面而不是精简的列表页面。

然而,这种策略也可能出错。

我曾经看到一家本地拍卖网站一夜之间失去了很大一部分搜索页面排名以及超过三分之一的 SEO 流量。

20/80 规则适用,因为一小部分核心词占对索引搜索结果的大多数 SEO 访问。 然而,长尾通常占据了 URL 数量的大部分,并且拥有最高的转化率。

因此,在使用这种策略的网站中,很少有对搜索页面的索引施加硬性限制或规则。

这带来了两个主要问题:

- 任何搜索查询都可以生成有效页面,这意味着可以自动生成无限数量的页面。

- 所有这些都可以在 Google 中索引。

在通过第三方广告将其搜索页面货币化的分类市场的情况下,此漏洞通过某种形式的广告套利得到了很好的利用:

- 为可疑、成人和完全非法的术语生成了大量的搜索 URL。

- 虽然这些自动生成的页面没有返回实际的库存结果,但它们提供第三方广告,并经过优化以通过页面模板和元数据对请求的搜索查询进行排名。

- 从低质量的论坛建立到这些页面的反向链接,以使它们被发现并被机器人爬行。

- 从 Google 登陆这些页面的用户会点击第三方广告,然后前往预期目的地的低质量网站。

当该计划被发现时,该网站的整体声誉已经受损。 它还受到了多次处罚,并且 SEO 性能持续大幅下降。

拥抱托管索引

如何避免这些问题?

大型企业网站在 SEO 中蓬勃发展的最佳方法之一是通过托管索引缩小规模。

对于拥有数千万或数亿页面的网站,至关重要的是超越以关键字为中心的方法,转向由数据、规则和自动化驱动的方法。

数据驱动的索引

大型网站的一项显着优势是其拥有丰富的内部搜索数据。

他们可以利用这些数据来详细了解区域和季节性搜索需求和趋势,而不是依赖外部工具。

当这些数据映射到现有的内容清单时,可以为要索引的内容以及索引的时间和地点提供可靠的指导。

重复数据删除和整合

少量权威、高排名的 URL 远比分散在前 100 名中的大量页面更有价值。

使用规范、利用规则和自动化来整合类似的页面是值得的。 某些页面可能会根据相似性分数进行合并,而其他页面可能会根据相似的查询进行集体排名,从而聚集在一起。

这里的关键是实验。 随着时间的推移调整逻辑并修改阈值。

清理内容薄且空的页面

当大量存在时,薄页和空页可能会对站点卫生和性能造成严重损害。

如果用有价值的内容来改进它们或整合它们太具有挑战性,那么它们应该不被索引,甚至不允许。

使用 robots.txt 减少无限空间

谷歌首次撰写有关“无限空间”的文章十五年后,过滤器、排序和其他参数组合的过度索引问题仍然困扰着许多电子商务网站。

在极端情况下,爬虫在尝试通过这些链接时可能会使服务器崩溃。 值得庆幸的是,这个问题可以通过 robots.txt 轻松解决。

客户端渲染

对某些您不希望被搜索引擎索引的页面组件使用客户端呈现可能是一种选择。 请仔细考虑这一点。

更好的是,注销的用户应该无法访问这些组件。

随着规模的扩大,风险急剧增加

虽然搜索引擎优化通常被认为是“免费”的流量来源,但这有点误导。 托管和提供内容需要花钱。

每个 URL 的成本可能可以忽略不计,但一旦规模达到数亿或数十亿页面,几便士的成本加起来就变成了实际数字。

尽管 SEO 的投资回报率很难衡量,但节省一分钱就是赚一分钱,在考虑大型网站的索引策略时,通过托管爬行和索引节省成本应该是一个因素。

务实的 SEO 方法——通过管理良好的爬行和索引,以数据、规则和自动化为指导——可以保护大型网站免受代价高昂的错误的影响。

本文表达的观点是客座作者的观点,并不一定是搜索引擎土地的观点。 此处列出了工作人员作者。