如何修复 WordPress 中的“Googlebot 无法访问 CSS 和 JS 文件”警告?

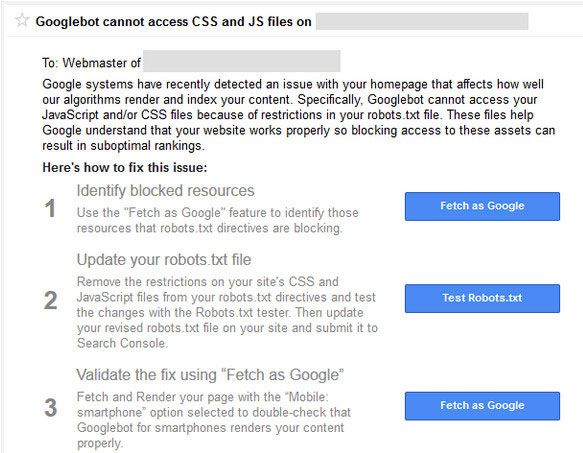

已发表: 2015-10-15如果您使用的是 WordPress 驱动的网站或博客,您可能在过去(或将要)收到来自 Google 搜索控制台团队的警告,说Googlebot 无法访问您域中的CSS 和 JS 文件。

如果您收到来自 Google 的此警告,请不要惊慌。 这听起来很糟糕,但有一个简单的解决方法。 该电子邮件消息包含指向有关如何解决此问题的说明的链接。 但是这些说明并不容易遵循。

Google bot 和其他搜索蜘蛛会在点击 htaccess 文件后立即访问您网站的 robots.txt 文件。

Htaccess 有阻止IP 地址、重定向URL、启用gzip 压缩等的规则。robots.txt 也将有一组针对搜索引擎的规则。 它们是您收到“Googlebot 无法访问 CSS 和 JS 文件”的原因。

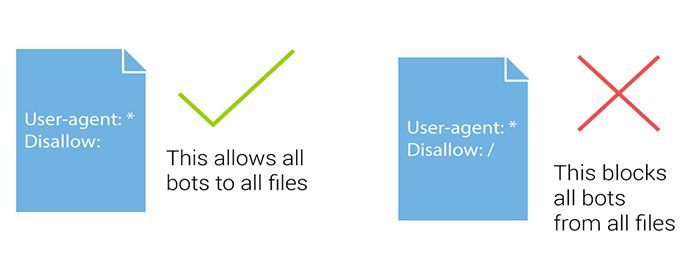

Robots.txt 有几行会阻止或允许抓取文件和目录。 谷歌已经开始惩罚阻止抓取 js 和 css 文件的网站。 JavaScript 和级联样式表负责呈现您的网站并处理表单、触发事件等。

如果 JS 被阻止,Google bot 将无法抓取代码,它会将代码视为垃圾邮件或违反链接方案。 相同的逻辑适用于 CSS 文件。

如果您还没有收到此警告电子邮件,与其等待电子邮件,您可以立即采取措施。

什么是 WordPress Robots.txt?

Robots.txt 文件帮助搜索引擎机器人指导抓取哪些部分,避免哪些部分。 当搜索机器人或搜索引擎蜘蛛来到您的网站并希望为您的网站建立索引时,他们会首先关注 robots.txt 文件。

搜索机器人或蜘蛛遵循此文件方向为您网站的任何页面建立索引或不索引。 如果您使用的是 WordPress ,您会在 WordPress 安装的根目录中找到 Robots.txt 文件。

如果您没有 robots.txt,您可以简单地创建一个新的记事本文件并将其命名为 Robots.txt。 然后只需使用 FTP 或直接通过 cPanel 文件管理器将其上传到您域的根目录中。

您可以使用 cPanel 登录服务器的 FTP 帐户来编辑WordPress robots.txt文件,也可以使用插件。 您应该将一些内容与站点地图 URL 一起添加到 robots.txt 文件中。

添加站点地图 URL 有助于搜索引擎机器人找到您的站点地图文件,从而更快地索引您的帖子和页面。 这是一个示例 robots.txt 文件。 在站点地图中,将站点地图 URL 替换为您的博客 URL:

用户代理: * # 禁止这些目录中的所有文件 禁止:/cgi-bin/ 禁止:/wp-admin/ 禁止:/档案/ 不允许: /*?* 禁止:*?replytocom 禁止:/wp-* 禁止:/comments/feed/ 用户代理:Googlebot-Image 允许:/wp-content/uploads/ 用户代理:Adsbot-Google 允许: / 用户代理:Googlebot-Mobile 允许: /

站点地图:https://www.kasareviews.com/sitemap.xml

为什么 Google 需要访问 CSS 和 JS 文件?

自从去年 10 月将 CSS 和 JavaScript 写入网站管理员指南以来,阻止 CSS 和 JavaScript 一直是 Google 的禁忌。 直到最近,该公司才发出警告。

如果您的网站一直在阻止 Googlebot访问这些文件,那么了解它是一件好事,这样您就可以解决问题。

谷歌专注于为用户友好的网站提供更好的排名。 速度快、用户体验良好等的网站。为了确定网站的用户体验,Google 需要访问权限才能访问该网站的 CSS 和 JavaScript 文件。

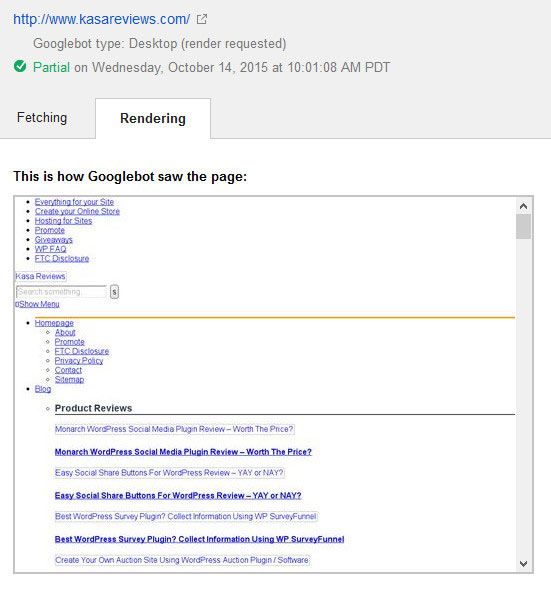

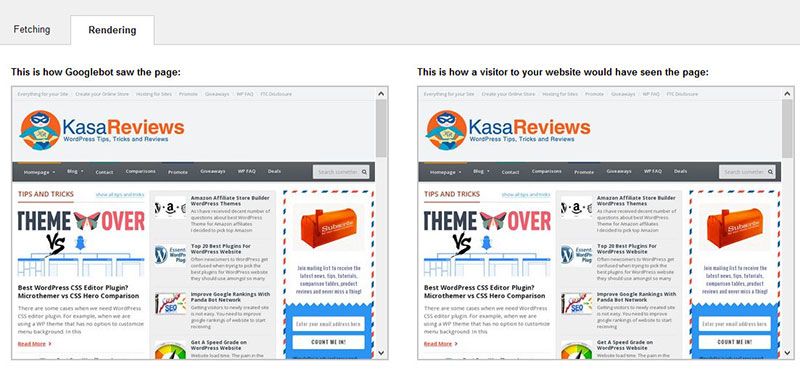

这是谷歌在修复之前看到 Kasa 评论网站的方式

默认情况下,WordPress不会阻止搜索机器人访问任何 CSS 或 JS 文件。 然而,一些网站所有者可能会在尝试添加额外的安全措施或使用 WordPress 安全插件时意外阻止它们。

这会限制 Googlebot 为可能影响您网站的 SEO 性能的 CSS 和 JS 文件编制索引。 有一个简单的修复方法,包括编辑您网站的 robots.txt 文件。

如何修复“Googlebot 无法访问 CSS 和 JS 文件”警告?

如果像 robots.txt 这样的术语对您来说听起来很陌生,请不要担心,因为您并不孤单。 这是 SEO 行业的常用行话,但在博主中并不流行。

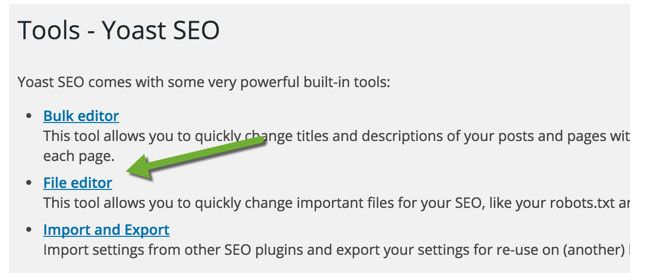

对于 WordPress 博客,您可以使用 FTP 编辑 robots.txt 文件,例如 FileZilla,使用 cPanel(请参阅 cPanel 优缺点)或使用 Yoast 的 SEO 的文件编辑器功能(查看 Yoast 与排名数学比较)。

Yoast SEO 插件可让您从 WordPress 仪表板编辑 robots.txt 和 .htaccess 文件。 在您的 WordPress 仪表板中,单击 SEO > 工具并单击文件编辑器

在此页面上,您可以查看和编辑您的 robots.txt 文件。 在大多数情况下,您需要删除以下行: Disallow: /wp-includes/

根据您配置 robots.txt 文件的方式,它将修复大部分警告。 您很可能会看到您的网站不允许访问某些 WordPress 目录,如下所示:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

一些用户可能会注意到他们的robots.txt 文件要么是空的,要么根本不存在。 如果 Googlebot 没有找到 robots.txt 文件,它会自动抓取所有文件并将其编入索引。

那你为什么会看到这个警告? 在极少数情况下,一些 WordPress 托管服务提供商可能会主动阻止机器人访问默认的 WordPress 文件夹。 您可以通过允许访问被阻止的文件夹在 robots.txt 中覆盖此设置。

User-agent: *

Allow: /wp-includes/js/

完成后,保存您的 robots.txt 文件。 访问 fetch as Google 工具,然后单击 fetch and render 按钮。 现在比较你的获取结果,你会看到大多数被阻塞的资源问题现在应该消失了。

以下是 Google 在编辑和修复 robots.txt 文件后呈现 Kasa 评论的方式。 您还应该以完整呈现您的整个网站为目标。

修改博客的 robots.txt 文件后,使用 Google 网站管理员工具的 robots.txt 测试器测试您网站的任何网址。 如果您发现任何错误或 Googlebot 无法抓取资源,该工具将突出显示导致错误的行。

要消除该问题,请删除突出显示的行。 希望这有帮助。 如果您有任何问题,请随时通过评论部分提问。