使用人工智能進行營銷時面臨的 7 個嚴重風險

已發表: 2023-07-06幾年前,我們大多數營銷人員對如何使用人工智能進行營銷一無所知。 突然間,我們開始在 LinkedIn 上撰寫有關在 ChatGPT 耳邊低語的最佳提示的帖子。

人工智能突然融入我們的工作中有很多值得慶祝的事情。 McKenzie 認為人工智能將為營銷人員釋放 2.6 萬億美元的價值。

但我們對人工智能的快速採用可能會超出重要的道德、法律和運營問題——這將使營銷人員面臨我們以前從未考慮過的風險(即我們是否會因為告訴人工智能“像史蒂芬·金一樣寫作?”而被起訴? ”)。

營銷氛圍中存在大量的人工智能灰塵,而且多年來都不會沉澱。 無論您多麼努力地觀察,您都無法找出使用大型語言模型和機器學習來創建內容和管理廣告的所有潛在陷阱。

因此,我們本文的目標是從一個很高的角度審視使用人工智能進行營銷的七個最突出的風險。 我們收集了專家的建議,以幫助減輕這些風險。 我們添加了大量資源,以便您可以更深入地研究您最關心的問題。

風險#1:機器學習偏差

有時,機器學習算法會給出不公平地支持或反對某人或某物的結果。 這被稱為機器學習偏差或人工智能偏差,即使是最先進的深度神經網絡,這也是一個普遍存在的問題。

是數據問題

這並不是說人工智能網絡本質上是偏執的。 這是輸入到其中的數據的問題。

機器學習算法通過識別模式來計算結果的概率,例如特定的購物者群體是否會喜歡您的產品。

但是,如果人工智能訓練的數據偏向於特定種族、性別或年齡組怎麼辦? 人工智能將得出結論,認為這些人更匹配,並相應地調整廣告創意或展示位置。

偏見洗錢版 pic.twitter.com/YQLRcq59lQ

- Janelle Shane (@JanelleCShane) 2021 年 6 月 17 日

這是一個例子。 研究人員最近測試了 Facebook 廣告定位系統中的性別偏見。 調查人員為必勝客投放了招聘送貨司機的廣告,並為 Instacart 投放了具有相同資格的類似廣告。

現有的必勝客司機群體以男性為主,因此 Facebook 向男性展示這些廣告的比例不成比例。 Instacart 擁有更多女性司機,因此她們的工作廣告被投放到更多女性面前。 但女性並沒有不想了解必勝客工作的內在原因,因此這是廣告定位的一個重大失誤。

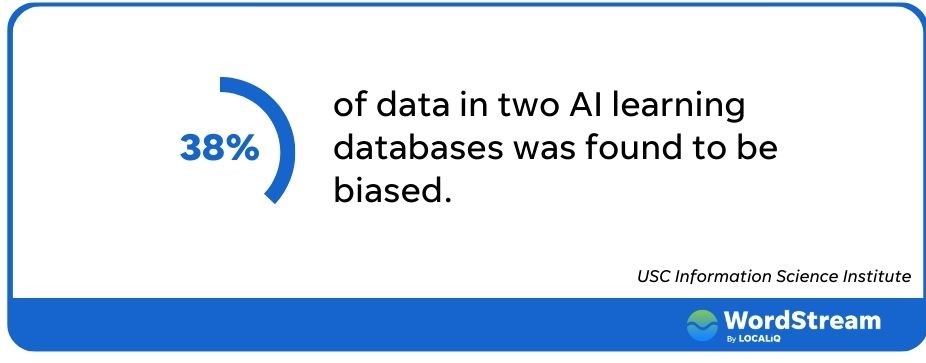

人工智能偏見很常見

這個問題遠遠超出了 Facebook 的範疇。 南加州大學的研究人員查看了兩個大型人工智能數據庫,發現其中超過 38% 的數據存在偏見。 ChatGPT 的文檔甚至警告說,他們的算法可能會將“負面刻板印象與黑人女性聯繫起來”。

機器學習偏差給營銷人員帶來了多種影響; 其中最重要的是廣告效果不佳。 如果您希望吸引盡可能多的潛在客戶,那麼排除大量人群的廣告定位平台並不理想。

當然,如果我們的廣告不公平地針對或排除某些群體,則會產生更大的後果。 如果您的房地產廣告歧視受保護的少數群體,您可能會陷入《公平住房法》和聯邦貿易委員會的錯誤立場。 更不用說完全錯過了包容性營銷的船。

如何避免人工智能偏見

那麼當我們的人工智能工具失控時我們該怎麼辦? 您可以採取幾個步驟來確保您的廣告公平對待每個人。

Writer 的內容和社區高級經理 Alaura Weaver 寫道,首先也是最重要的是,確保有人審核您的內容。 “雖然人工智能技術取得了顯著進步,但它缺乏人類所擁有的批判性思維和決策能力,”她解釋道。 “通過讓人類編輯審查和事實核查人工智能編寫的內容,他們可以確保內容沒有偏見並遵循道德標準。”

人工監督也將降低付費廣告活動中出現負面結果的風險。

“目前,也許是無限期地,讓人工智能完全接管營銷活動或任何形式的營銷是不可取的,”經驗營銷的創始人布雷特·麥克海爾說。 “當人工智能從已經積累了大量數據和經驗的有機智能那裡接收到準確的輸入時,人工智能就能發揮最佳性能。”

風險#2:事實謬誤

最近,谷歌的新人工智能聊天機器人 Bard 在促銷推文中給出了錯誤答案,導致其母公司估值損失 100 億美元。

Bard 是一項實驗性對話式人工智能服務,由 LaMDA 提供支持。 它使用我們的大型語言模型構建並藉鑑網絡信息,是好奇心的啟動板,可以幫助簡化複雜的主題 → https://t.co/fSp531xKy3 pic.twitter.com/JecHXVmt8l

— 谷歌 (@Google) 2023 年 2 月 6 日

谷歌的失誤凸顯了人工智能的最大局限性之一,也是營銷人員使用人工智能的最大風險之一:人工智能並不總是說實話。

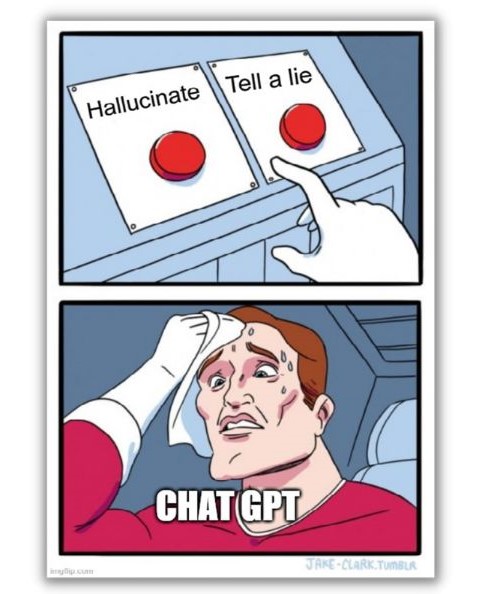

AI產生幻覺

沃頓商學院教授 Ethan Mollic 最近將 ChatGPT 等人工智能驅動的系統描述為“無所不知、渴望取悅但有時會撒謊的實習生”。

當然,儘管有些人可能會這麼說,但人工智能並沒有感知能力。 它無意欺騙我們。 然而,它可能會遭受“幻覺”的困擾,導致它編造一些東西。

人工智能是一個預測機器。 它看起來會填寫下一個可以回答您的查詢的單詞或短語。 但它沒有自我意識; 人工智能沒有直覺檢查邏輯來知道它串在一起的內容是否有意義。

與偏見不同,這似乎不是數據問題。 即使網絡擁有所有正確的信息,它仍然可能告訴我們錯誤的信息。

考慮這個例子,用戶詢問 ChatGPT“阿根廷贏得了多少次 FIFA 世界杯?” 它曾說過一次並提到了球隊 1978 年的勝利。 推特隨後詢問哪支球隊在 1986 年獲勝。

問#ChatGPT abt 誰贏得了 2022 年 FIFA 世界杯。它無法回答。 這是預期的。 然而,它似乎提供了錯誤的信息(其他兩個獲勝),即使系統中存在該信息。 有#Explanations 嗎? pic.twitter.com/fvxe05N12p

- indranil sinharoy (@indranil_leo) 2022 年 12 月 29 日

該聊天機器人承認是阿根廷隊,但沒有對其之前的失態做出任何解釋。

令人不安的是,人工智能的錯誤答案通常寫得如此自信,它們融入了周圍的文本,使它們看起來完全可信。 它們也可以是全面的,正如針對 Open.ai 提起的訴訟中所詳述的那樣,ChatGPT 據稱炮製了整個貪污的故事,然後由一名記者分享。

如何避免人工智能的幻覺

雖然人工智能甚至會用一個單詞的答案讓你誤入歧途,但在編寫較長的文本時,它更有可能偏離軌道。

“只需一個提示,人工智能就可以生成博客或電子書。 是的,這太棒了——但有一個問題,”韋弗警告說。 “它生成的越多,你需要做的編輯和事實核查就越多。”

韋弗表示,為了減少人工智能工具開始編造幻覺敘述的機會,最好創建一個大綱,並讓機器人一次處理一個部分。 當然,然後讓人審查它添加的事實和統計數據。

風險#3:人工智能工具的誤用

每天早上我們醒來都會看到一批新的人工智能工具,它們似乎像暴雨後的蘑菇一樣在一夜之間發芽。

但並非每個平台都是針對所有營銷功能而構建的,並且某些營銷挑戰尚無法通過人工智能來解決。

人工智能工具有局限性

ChatGPT 就是一個很好的例子。 人工智能球的美女玩起來很有趣(就像以詹姆斯國王聖經的風格寫如何從錄像機中取出花生醬三明治一樣)。 它還可以產生一些令人驚訝的寫得很好的簡短答案,打破作家的障礙。 但不要要求它幫助您進行關鍵字研究。

ChatGPT 失敗的原因是其數據集相對較舊,僅包含 2022 年之前的信息。 要求它提供“人工智能營銷”的關鍵詞,它的答案與你在 Thinword 或 Contextminds 等其他工具中找到的答案並不相符。

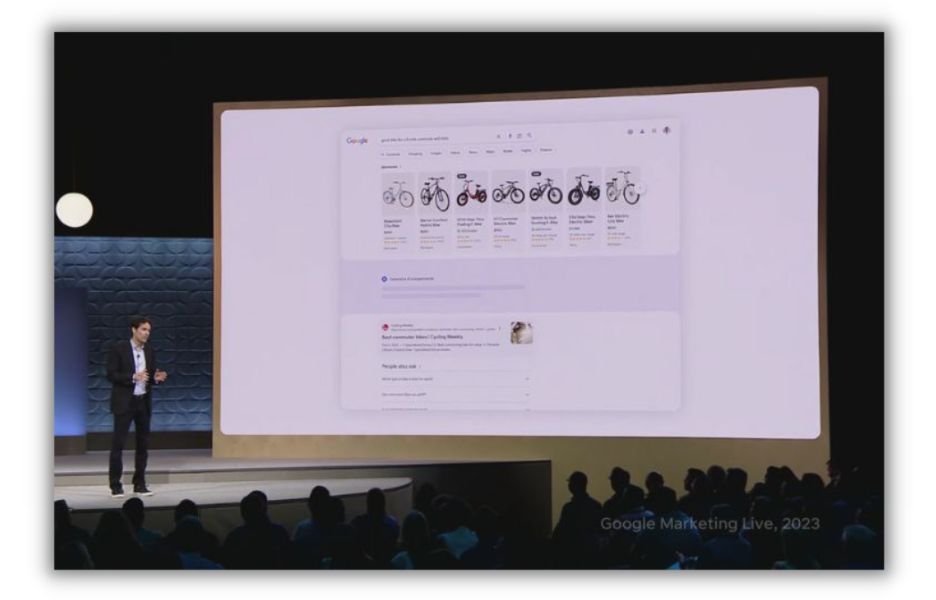

同樣,谷歌和 Facebook 都有新的人工智能工具來幫助營銷人員製作廣告、優化廣告支出和個性化廣告體驗。 聊天機器人無法解決這些挑戰。

谷歌在 2023 年 Google Marketing Live 活動上宣布對其搜索和廣告管理產品進行一系列人工智能升級。

你可能會過度使用人工智能

如果你給人工智能工具一項單一的任務,它可能只會在一個目標上過度索引。 營銷自動化專家 Nick Abbene 在專注於改進 SEO 的公司中經常看到這種情況。

“我看到的最大問題是盲目使用 SEO 工具,對搜索引擎進行過度優化,並忽視客戶的搜索意圖,”Abbene 說。 “SEO 工具非常適合向搜索引擎發出高質量內容的信號。 但最終,谷歌希望滿足搜索者的要求。”

如何避免人工智能工具的誤用

扳手並不是敲釘子的最佳選擇。 同樣,人工智能寫作助手可能不適合創建網頁。 Abbene 表示,在你全力投入任何一種人工智能選項之前,請先從該工具的構建者和其他用戶那裡獲取反饋。

“為了避免錯誤選擇人工智能工具,請了解其他營銷人員是否正在針對您的用例使用該工具,”他說。 “請隨意請求產品演示,或與提供相同功能的其他一些工具一起試用。”

Capterra 等網站可讓您快速比較多個 AI 平台。

一旦找到合適的人工智能工具堆棧,就用它來幫助流程,而不是接管它。 “不要害怕使用人工智能工具來增強你的工作流程,但只是為了這個目的使用它們,”阿貝內說。 “從第一原則開始每一條內容,進行高質量的關鍵詞研究並理解搜索意圖。”

風險#4:內容同質化

AI 可以在大約 10 秒內寫出整篇文章。 但儘管生成式人工智能已經變得令人印象深刻,但它缺乏真正創造性的細微差別,導致其輸出常常給人一種機器人般的感覺。

“雖然人工智能擅長製作信息豐富的內容,但它往往缺乏人類帶來的創造力和參與度,”韋弗說。

AI是用來模仿的

讓一個生成式 AI 寫作機器人來寫你的讀書報告,它會很容易地寫出 500 個單詞,充分解釋《麥田裡的守望者》的主題(假設它不會將霍爾頓·考菲爾德幻覺為銀行搶劫犯)。

它之所以能做到這一點,是因為它吸收了數千篇有關 JD Salinger 傑作的文本。

現在,請您的人工智能朋友寫一篇博客文章,以概括您的品牌、受眾和價值主張的方式解釋您業務的核心概念。 你可能會失望。 “人工智能生成的內容並不總是能夠解釋品牌個性和價值觀的細微差別,並且可能會產生不切實際的內容,”韋弗說。

換句話說,人工智能擅長消化、組合和重新配置已經創建的內容。 它不擅長創建與現有內容脫穎而出的內容。

生成式人工智能工具也不擅長使內容引人入勝。 他們會很高興地寫出大量的文字,而不用任何圖像、圖表或要點來讓疲倦的眼睛休息。 他們不會引用客戶故事或假設的例子來使觀點更具相關性。 他們很難將您所在行業的新聞報導與您的產品提供的好處聯繫起來。

如何避免內容同質化

一些人工智能工具(例如 Writer)具有內置功能,可以幫助作家保持一致的品牌個性。 但你仍然需要一名編輯來“審查和編輯品牌聲音和語氣的內容,以確保其與受眾產生共鳴並強化組織的信息和目標,”韋弗建議。

編輯和作家也可以像其他人一樣查看文章。 如果有難以理解的文字塊,他們就會將其分解並添加一點視覺效果。

使用人工智能內容作為起點,作為幫助啟動創造力和研究的一種方式。 但始終添加您自己的個人風格。

風險#5:SEO 損失

谷歌對人工智能內容的立場一直有些模糊。 起初,搜索引擎似乎會懲罰用人工智能撰寫的帖子。

[圖片:約翰·穆勒關於人工智能的推文]

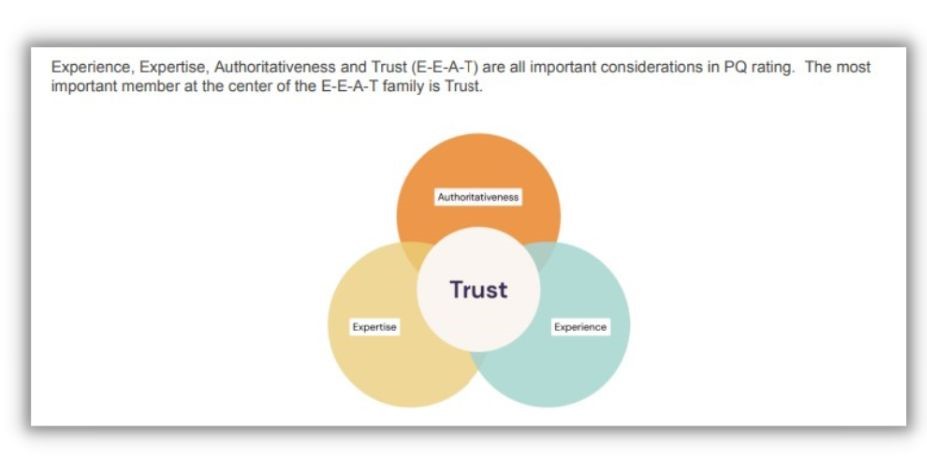

最近,谷歌的開發者博客表示,他們書中的人工智能是可以的。 但這一確認卻引起了人們的極大關注。 只有“展示我們所謂的 EEAT 品質的內容:專業知識、經驗、權威性和可信度”才會給不斷評估 Google 排名系統的人類搜索評估者留下深刻的印象。

信任是 SEO 的關鍵

在 Google 的 EEAT 中,決定一切的因素之一就是信任。

[來源]

我們已經討論過,人工智能內容很容易出現謬誤,因此在沒有人類監督的情況下本質上是不可信的。 它也無法滿足支持要求,因為本質上它不是由在該主題上具有專業知識、權威或經驗的人編寫的。

寫一篇關於烘焙香蕉麵包的博客文章。 人工智能機器人將在大約兩秒鐘內為您提供食譜。 但在寒冷的冬日為家人烘焙時,它卻無法變得富有詩意。 或者談談它作為商業麵包師多年來嘗試各種類型麵粉的經歷。 這些觀點正是谷歌搜索評估者所尋求的。

這似乎也是人們所渴望的。 這就是為什麼他們中的許多人轉向 TikTok 視頻上的真人來學習他們過去在谷歌上找到的東西。

如何避免失去SEO

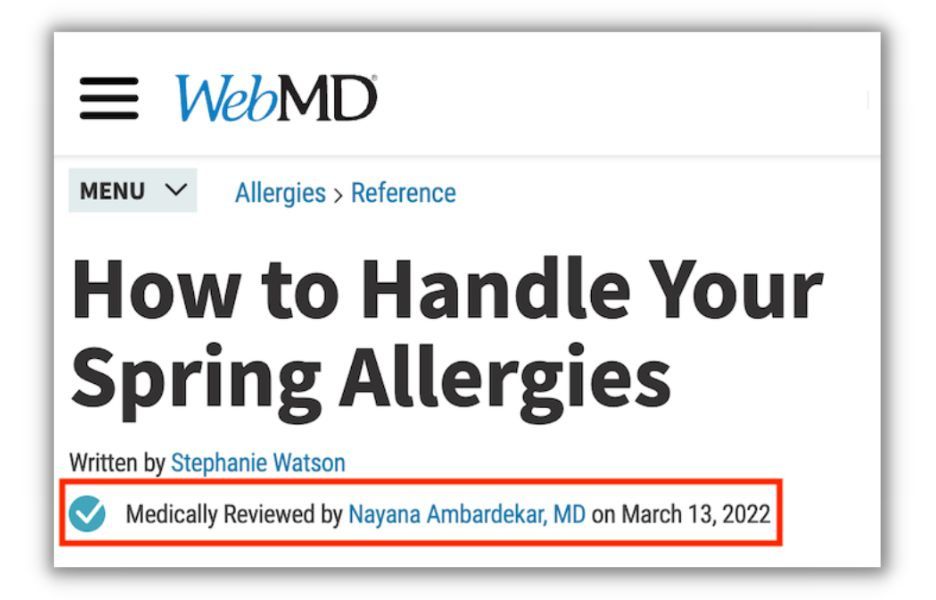

人工智能的偉大之處在於它不介意共享署名。 因此,當您確實使用聊天機器人來加速內容製作時,請確保引用具有憑據的人類作者。

對於醫療保健和個人理財等敏感主題尤其如此,谷歌將其稱為“你的金錢,你的生活”主題。 “如果您處於 YMYL 垂直領域,請優先考慮內容的權威性、信任度和準確性,”WordStream 和 LocaliQ 的內容和 SEO 總監 Elisa Gabbert 建議。

例如,在撰寫有關醫療保健的文章時,請讓醫療專業人員審核您的帖子並在帖子中引用它們。 這向 Google 發出了一個強烈的信號,表明您的內容值得信賴,即使它是在聊天機器人中啟動的。

風險#6:法律挑戰

生成式人工智能從人類創造的作品中學習,然後創造出新的東西。 對於人工智能內容模型的輸入和輸出來說,版權問題都是不明確的。

現有的工作對於人工智能來說可能是公平的遊戲

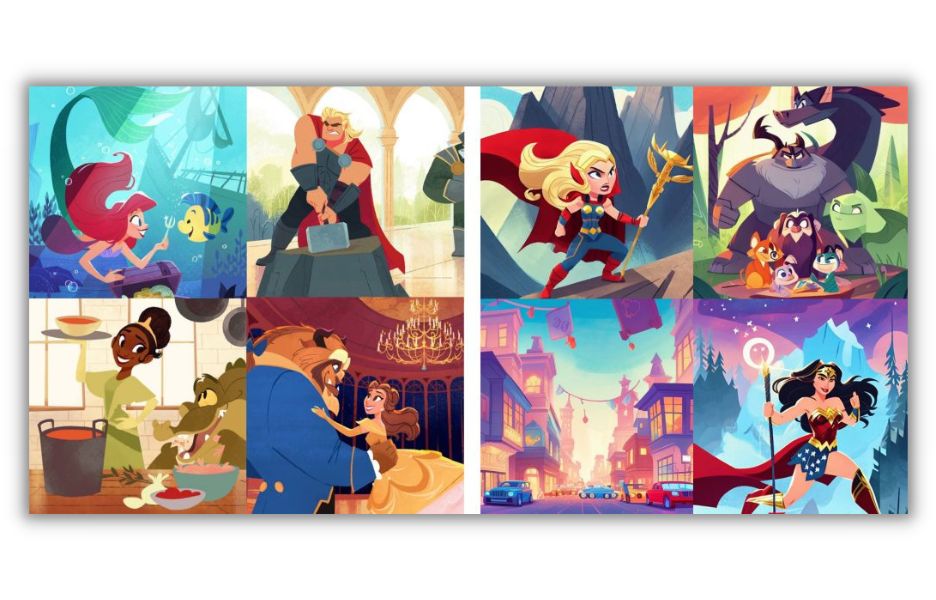

為了說明(雙關語)大型學習模型作品的版權問題,我們轉向技術專家安迪·拜奧(Andy Baio)報告的一個案例。 正如 Baio 所解釋的,一位名叫 Hollie Mengert 的洛杉磯藝術家了解到,她的 32 幅插圖已被吸收到人工智能模型中,然後通過開放許可提供給任何想要重現她的風格的人。

說明:安迪·拜奧 (Andy Baio) 策劃的藝術家霍莉·門格特 (Hollie Mengert) 的插圖集(左)與根據她的風格由人工智能生成的插圖進行比較。

當你得知她為迪士尼等客戶創作了許多圖像時,故事變得更加複雜,而迪士尼實際上擁有這些圖像的權利。

與門格特處境相同的插畫家(或作家或程序員)能否成功起訴侵犯版權?

這個問題還沒有明確的答案。 “我看到雙方的人都對自己的立場非常有信心,但現實是沒人知道,”拜奧告訴 The Verge。 “任何聲稱自己自信地知道法庭上將如何進行的人都是錯誤的。”

如果你用來創建圖像或文章的人工智能接受了許多創作者的數千件作品的訓練,那麼你不太可能輸掉官司。 但如果你給機器輸入十本史蒂芬·金的書,並告訴機器人以這種風格寫一本新書,你可能就會遇到麻煩。

免責聲明:我們不是律師,因此如果您不確定,請尋求法律建議。

您的人工智能內容也可能不受保護

您使用聊天機器人創建的內容怎麼樣,它是否受版權法保護? 在大多數情況下,除非您做了相當多的工作來編輯它,否則不會。 這意味著如果有人將您的帖子重新用於他們自己的博客,您將幾乎沒有追索權。

對於受保護的內容,擁有權利的可能是人工智能的程序員,而不是您。 許多國家認為製作作品的工具的製造者是其創作者,而不是輸入提示的人。

如何避免法律挑戰

首先使用信譽良好的人工智能內容創建工具。 找到一家公司發表的有大量正面評價的文章,該公司明確表達了其對版權法的立場。

另外,請運用您的良好判斷力來決定您是故意複製創作者的作品還是只是使用人工智能來增強您自己的作品。

如果您想在法庭上有機會保護您的產品,請做出許多實質性改變。 或者使用人工智能幫助創建大綱,但自己寫大部分單詞。

風險#7:安全和隱私洩露

人工智能工具給營銷人員的系統安全和數據隱私帶來了廣泛的潛在威脅。 有些是來自惡意行為者的直接攻擊。 其他的只是用戶無意中向旨在共享敏感信息的系統提供敏感信息。

AI工具帶來的安全風險

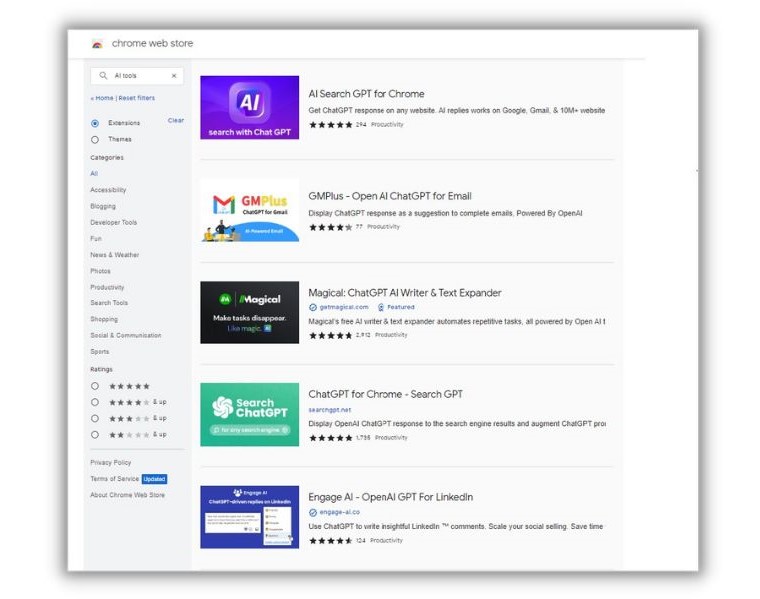

“有很多產品看起來、感覺和行為都像合法工具,但實際上是惡意軟件,”端點安全提供商 Kolide 的內容營銷高級編輯 Elaine Atwell 告訴我們。 “它們很難與合法工具區分開來,你現在就可以在 Chrome 商店中找到它們。”

在 Google Chrome 商店中輸入任意版本的“AI 工具”,您會發現不乏選項。

阿特韋爾在 Kolide 博客上闡述了這些風險。 在她的文章中,她提到了一個名為“快速訪問聊天 GPT”的 Chrome 擴展程序實際上是一個詭計的事件。 下載後,該軟件會劫持用戶的 Facebook 帳戶,並竊取受害者的所有 cookie,甚至是出於安全目的的 cookie。 據 Atwell 報導,每天有超過 2,000 人下載該擴展程序。

隱私不受保護

阿特韋爾表示,即使是合法的人工智能工具也可能帶來安全風險。 “......目前,大多數公司甚至沒有適當的政策來評估不同擴展所帶來的風險類型和水平。 在缺乏明確指導的情況下,世界各地的人們都在安裝這些小助手並向其提供敏感數據。”

假設您正在撰寫一份內部財務報告以與投資者分享。 請記住,人工智能網絡會從給定的信息中學習,為其他用戶生成輸出。 您放置在人工智能聊天機器人中的所有數據對於公司外部的人來說都是公平的遊戲。 如果競爭對手詢問您的底線,則可能會彈出。

如何避免隱私和安全風險

第一道防線是確保軟件與其聲稱的一樣。 除此之外,請謹慎使用您選擇的工具。 “如果你要使用人工智能工具(它們確實有用途!),請不要向它們提供任何可能被視為敏感的數據,”阿特韋爾說。

此外,當您審查人工智能工具的實用性和偏見時,請詢問他們的隱私和安全政策。

降低使用人工智能進行營銷的風險

人工智能正在以令人難以置信的速度發展。 在不到一年的時間裡,Chat GTP 的功能已得到顯著提升。 即使在接下來的六到十二個月內,我們也無法知道我們將能夠利用人工智能做什麼。 我們也無法預測潛在的問題。

您可以通過以下幾種方法來改善人工智能營銷成果,同時避免一些最常見的風險:

- 讓人類編輯審查內容的質量、可讀性和品牌聲音

- 仔細檢查您使用的每個工具的安全性和功能

- 定期審查人工智能定向廣告定位是否存在偏見

- 評估副本和圖像是否存在潛在的版權侵權

我們要感謝 Elain Attwell、Brett McHale、Nick Abenne 和 Alaura Weaver 對本文的貢獻。

回顧一下,讓我們回顧一下使用人工智能進行營銷所帶來的風險列表:

- 機器學習偏差

- 事實謬誤

- 人工智能工具的誤用

- 內容同質化

- SEO 損失

- 法律挑戰

- 安全和隱私洩露