如何修復 WordPress 中的“Googlebot 無法訪問 CSS 和 JS 文件”警告?

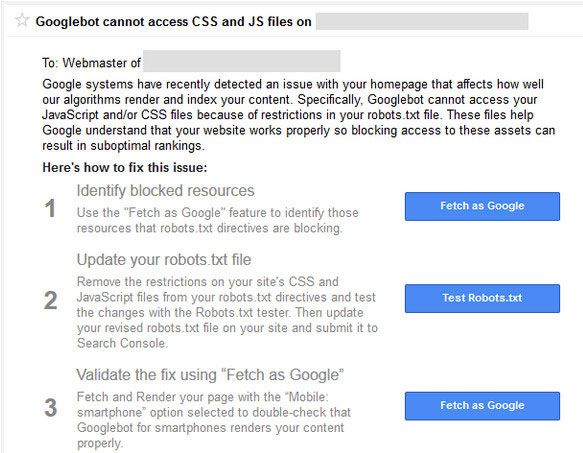

已發表: 2015-10-15如果您使用的是 WordPress 驅動的網站或博客,您可能在過去(或將要)收到來自 Google 搜索控制台團隊的警告,說Googlebot 無法訪問您域中的CSS 和 JS 文件。

如果您收到來自 Google 的此警告,請不要驚慌。 這聽起來很糟糕,但有一個簡單的解決方法。 該電子郵件消息包含指向有關如何解決此問題的說明的鏈接。 但是這些說明並不容易遵循。

Google bot 和其他搜索蜘蛛會在點擊 htaccess 文件後立即訪問您網站的 robots.txt 文件。

Htaccess 有阻止IP 地址、重定向URL、啟用gzip 壓縮等的規則。robots.txt 也將有一組針對搜索引擎的規則。 它們是您收到“Googlebot 無法訪問 CSS 和 JS 文件”的原因。

Robots.txt 有幾行會阻止或允許抓取文件和目錄。 谷歌已經開始懲罰阻止抓取 js 和 css 文件的網站。 JavaScript 和級聯樣式表負責呈現您的網站並處理表單、觸發事件等。

如果 JS 被阻止,Google bot 將無法抓取代碼,它會將代碼視為垃圾郵件或違反鏈接方案。 相同的邏輯適用於 CSS 文件。

如果您還沒有收到此警告電子郵件,與其等待電子郵件,您可以立即採取措施。

什麼是 WordPress Robots.txt?

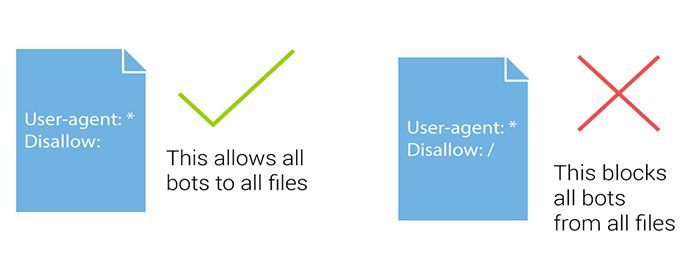

Robots.txt 文件幫助搜索引擎機器人指導抓取哪些部分,避免哪些部分。 當搜索機器人或搜索引擎蜘蛛來到您的網站並希望為您的網站建立索引時,他們會首先關注 robots.txt 文件。

搜索機器人或蜘蛛遵循此文件方向為您網站的任何頁面建立索引或不索引。 如果您使用的是 WordPress ,您會在 WordPress 安裝的根目錄中找到 Robots.txt 文件。

如果您沒有 robots.txt,您可以簡單地創建一個新的記事本文件並將其命名為 Robots.txt。 然後只需使用 FTP 或直接通過 cPanel 文件管理器將其上傳到您域的根目錄中。

您可以使用 cPanel 登錄服務器的 FTP 帳戶來編輯WordPress robots.txt文件,也可以使用插件。 您應該將一些內容與站點地圖 URL 一起添加到 robots.txt 文件中。

添加站點地圖 URL 有助於搜索引擎機器人找到您的站點地圖文件,從而更快地索引您的帖子和頁面。 這是一個示例 robots.txt 文件。 在站點地圖中,將站點地圖 URL 替換為您的博客 URL:

用戶代理: * # 禁止這些目錄中的所有文件 禁止:/cgi-bin/ 禁止:/wp-admin/ 禁止:/檔案/ 不允許: /*?* 禁止:*?replytocom 禁止:/wp-* 禁止:/comments/feed/ 用戶代理:Googlebot-Image 允許:/wp-content/uploads/ 用戶代理:Adsbot-Google 允許: / 用戶代理:Googlebot-Mobile 允許: /

站點地圖:https://www.kasareviews.com/sitemap.xml

為什麼 Google 需要訪問 CSS 和 JS 文件?

自從去年 10 月將 CSS 和 JavaScript 寫入網站管理員指南以來,阻止 CSS 和 JavaScript 一直是 Google 的禁忌。 直到最近,該公司才發出警告。

如果您的網站一直在阻止 Googlebot訪問這些文件,那麼了解它是一件好事,這樣您就可以解決問題。

谷歌專注於為用戶友好的網站提供更好的排名。 速度快、用戶體驗良好等的網站。為了確定網站的用戶體驗,Google 需要訪問權限才能訪問該網站的 CSS 和 JavaScript 文件。

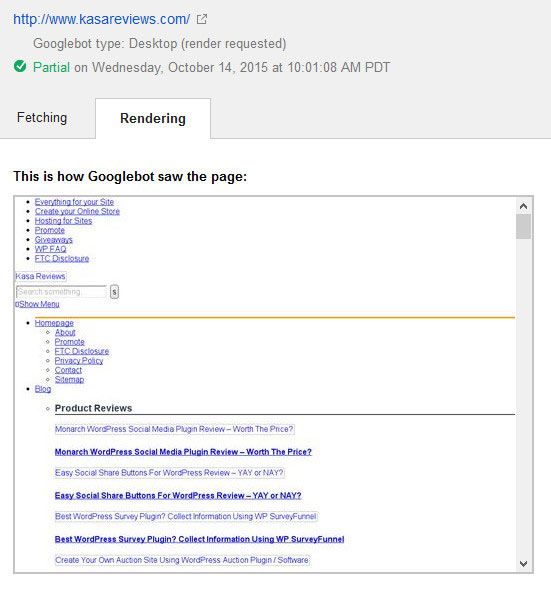

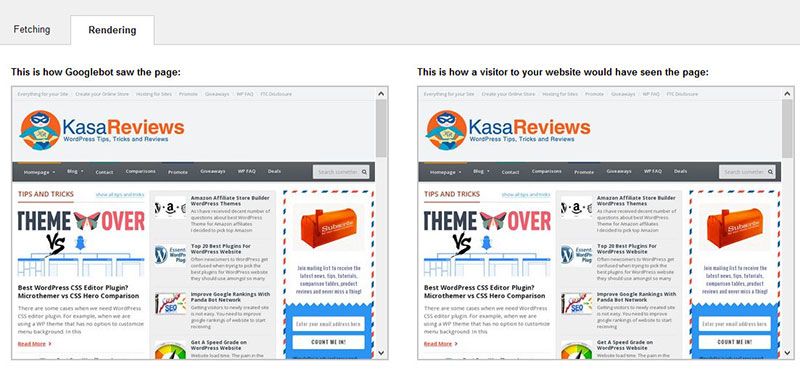

這是谷歌在修復之前看到 Kasa 評論網站的方式

默認情況下,WordPress不會阻止搜索機器人訪問任何 CSS 或 JS 文件。 然而,一些網站所有者可能會在嘗試添加額外的安全措施或使用 WordPress 安全插件時意外阻止它們。

這會限制 Googlebot 為可能影響您網站的 SEO 性能的 CSS 和 JS 文件編制索引。 有一個簡單的修復方法,包括編輯您網站的 robots.txt 文件。

如何修復“Googlebot 無法訪問 CSS 和 JS 文件”警告?

如果像 robots.txt 這樣的術語對您來說聽起來很陌生,請不要擔心,因為您並不孤單。 這是 SEO 行業的常用行話,但在博主中並不流行。

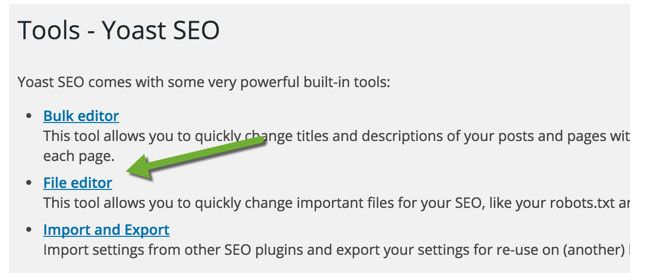

對於 WordPress 博客,您可以使用 FTP 編輯 robots.txt 文件,例如 FileZilla,使用 cPanel(請參閱 cPanel 優缺點)或使用 Yoast 的 SEO 的文件編輯器功能(查看 Yoast 與排名數學比較)。

Yoast SEO 插件可讓您從 WordPress 儀表板編輯 robots.txt 和 .htaccess 文件。 在您的 WordPress 儀表板中,單擊 SEO > 工具並單擊文件編輯器

在此頁面上,您可以查看和編輯您的 robots.txt 文件。 在大多數情況下,您需要刪除以下行: Disallow: /wp-includes/

根據您配置 robots.txt 文件的方式,它將修復大部分警告。 您很可能會看到您的網站不允許訪問某些 WordPress 目錄,如下所示:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

一些用戶可能會注意到他們的robots.txt 文件要么是空的,要么根本不存在。 如果 Googlebot 沒有找到 robots.txt 文件,它會自動抓取所有文件並將其編入索引。

那你為什麼會看到這個警告? 在極少數情況下,一些 WordPress 託管服務提供商可能會主動阻止機器人訪問默認的 WordPress 文件夾。 您可以通過允許訪問被阻止的文件夾在 robots.txt 中覆蓋此設置。

User-agent: *

Allow: /wp-includes/js/

完成後,保存您的 robots.txt 文件。 訪問 fetch as Google 工具,然後單擊 fetch and render 按鈕。 現在比較你的獲取結果,你會看到大多數被阻塞的資源問題現在應該消失了。

以下是 Google 在編輯和修復 robots.txt 文件後呈現 Kasa 評論的方式。 您還應該以完整呈現您的整個網站為目標。

修改博客的 robots.txt 文件後,使用 Google 網站管理員工具的 robots.txt 測試器測試您網站的任何網址。 如果您發現任何錯誤或 Googlebot 無法抓取資源,該工具將突出顯示導致錯誤的行。

要消除該問題,請刪除突出顯示的行。 希望這有幫助。 如果您有任何問題,請隨時通過評論部分提問。